谈到高性能计算机或超级计算机,不少人都会想到通过每秒多少亿次浮点计算能力或者用Linpack值来衡量系统的性能,并以此来衡量机器是否符合自己的需求。然而,这种观念已经过时了。在6月24日主题为“应用为本,寓智于衡”的2011年英特尔高性能计算研讨会上,英特尔提出的“平衡计算”理念受到了与会专家的一致认可。

根据此次研讨会上专家们讨论的情况,IT168服务器频道总结认为,所谓“平衡计算”,主要体现在以下四个方面:

一、CPU、I/O、存储之间的平衡

首先,从一套高性能计算机系统的硬件构成来看,它包含了计算节点、I/O节点、存储系统、连接网络等部分,系统整体性能的高低,并不简单取决于CPU能跑多快,尽管对于大多数高性能计算应用来说,浮点处理能力是一个最关键的指标。由于今天的CPU发展很快,如最新的至强处理器不仅主频能达到3GHz以上,而且在一个Socket中可以拥有10个核,可以同时执行多个线程,而相对来说,I/O与存储的发展要缓慢一些,加上实际应用中系统需要处理的数据量越来越大,数据交互越来越多,这些使得存储和I/O已经成为当今高性能计算系统的短板所在。【参考:高性能计算系统性能优化 打破存储瓶颈】

为此,早在两年前,英特尔就成立了数据中心事业部,开始将旗下服务器、存储和网络产品线的创新归入统一规划,以实现平衡计算的理念。

在此次研讨会中,英特尔高性能计算架构师David Scott博士就以石油勘探地震波计算为例,详细介绍了英特尔的平衡计算技术。David谈到,系统的设计主要取决于应用的特征,今天的地震波计算,由于采用了更加先进、优化的算法和软件,使得系统对于存储带宽、内存、网络带宽变得非常敏感,数据在系统中移动的成本变得越来越昂贵。

▲英特尔高性能计算架构师David Scott博士

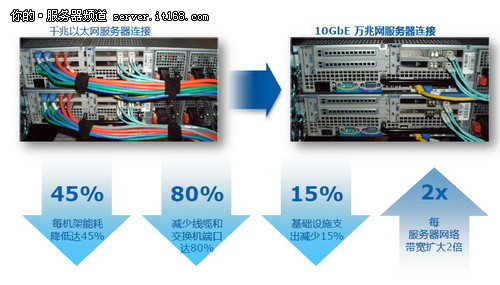

为了应对存储、网络带来的新挑战,近年来,英特尔已经将至强处理器拓展到存储系统领域,2010年绝大部分存储厂商发布的新品,如HDS的VSP、IBM的Storwize V7000和NetApp的FAS/V6200及3200等中高端产品,都采用了英特尔架构。另外,英特尔也在引领固态硬盘(SSD)的创新,这种硬盘可以非常合适地充当高性能计算集群每台服务器在内存与硬盘之间的缓存,以让CPU和内存可以更快地读写数据。在网络领域,英特尔也在推动万兆以太网的产品创新与成本降低,让更多高性能计算用户能够早日借助到万兆网在增大带宽、降低延迟、提升可靠性、统一简化网络等方面的优势。【参考:万兆以太网普及 降低价格高门槛是关键】

▲英特尔万兆以太网带来的优势

二、性能、功耗与编程应用之间的平衡

随着高性能计算系统越做越大,百万亿次、千万亿次的机器开始被广泛采用,甚至英特尔还提出了在2020年前实现每秒百亿亿次浮点计算性能(ExaFLOP/S)的愿景——这比今天全球最快的超级计算机还要快上百倍。对于这些大机器的用户,如大型超算中心,仅仅考虑系统性能的扩展显然已经不够,还需要综合考量成本、功耗、稳定性、易用性、占地空间等多个条件的限制。

另外,随着处理器技术的飞速发展,如从多核到众核,从同构到异构,从千万亿次到百亿亿次,软件设计也开始面临极大的挑战,比如,传统的算法如何获得性能提升,软件系统设计需要重新思考。

David在接受采访时也谈到,要实现百亿亿次的梦想,除了要考虑能耗限制之外,还要着重考虑系统的稳定性,因为系统规模越大,出问题的概率也越高,加上低功耗的限制,一些部件也容易出问题,其次就是软件,因为系统规模加大,要跑成千上万的线程,目前还看不到这样的应用会是什么。