概述

IT界很少发生革命。但当它发生的时候,我们通常会措手不及,然而在IT发展的历史中,随着时间的推移,我们会看到更多技术演变的过程。数据中心它的发展可能就是一个很好的例子来代表这个创新融合与发展演变,如同随着时间的推移新的计算模式的发展和新技术新机遇的诞生一样。这是计算机系统的历史,它引领计算迈向更高的地方。

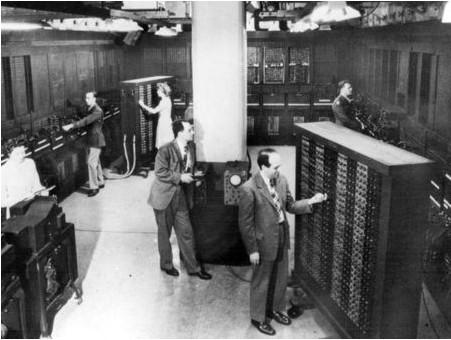

1960年以前:ENIAC诞生

如果我们定义一个最基础的数据中心,应该有完善的计算设备,基础设施和存储元件,以及安全的备用电源的话,那么ENIAC可以成为今天数据中心的始祖了。ENIAC是电子数字积分计算的简称,在1946年为美国陆军弹道研究实验室存储火炮发射码。在此之前,没有一个计算机拥有类似的存储和计算能力。它有17,468个真空管,7200个晶体二极管,和10,000个电容器。整个安装需要1800平方英尺的建筑面积,每计算0.05MIPS就要耗费150KW的电力。 ENIAC一直使用到1955年。现在在美国宾夕法尼亚大学工程与应用科学学院可以看到当年ENIAC的剩余部件。

20世纪60年代: 商业化与虚拟化

第一台晶体管计算机(TRADIC),不是真空管为基础的系统,开发于1954年,但没有达到真正的商业用途,直到20世纪60年代,大型机的出现,像IBM的System系列让计算性能有了飞跃性的提升。在此之前,这些大型机主要是用在政府和军事上,以确保地理环境的要求和数据安全的保护。性能的提升,致使人们想要在更小的硬件划分上使用,使得资源可以最大限度的被利用。于是虚拟化技术应运而生,虽然开端还是很基础的,但是这种想法迅速的演变成了技术,使大型机可以多任务处理以及同时运行多个应用程序。第一个被用于商业上的虚拟化系统是IBM的VM/370操作系统。

1964年:第一台超级计算机

Control Data公司创造的CDC 6000是第一台超级计算机,也是现在数据中心超级计算的鼻祖。该系统的设计是由超级计算机之父Seymour Cray在劳伦斯辐射实验室里创造的,拥有100纳秒的时钟速度,第一个含CRT控制台的计算机。同时期也诞生了一款非常著名的视频游戏Lunar Lander。CDC6000是基于一个40MHz的中央科学处理器和10个外置的设备组成的,后来被精简成一个个指令集计算机(RISC)。性能保持在 1 MFLOPS(最高可达3 MFLOPS),这是迄今为止速度最快的计算机,直到1977年仍在使用。CDC 6600最初的售价为800万美元,在今天它的价值已经超过6000万美元。

20世纪70年代灾难恢复系统出现

早在1973年,灾难恢复计划就已经在大型机上出现,但真正在商业上有影响并且发展使用的是Sungard公司开启的,这是在美国的第一个商业上的灾难恢复系统(之后被称为联合国信息系统)这一业务帮助公司成长成为一个超过17000名员工的大公司,即使现在灾难恢复服务不再是它主要关注的项目。

1973年:Xerx Alto—微型计算机登场

在1971年随着英特尔4004处理器的诞生,使得计算机可以小型化。虽然Alto没有整合英特尔芯片(它已经是一个定制的TTL 16位的CPU了),它是第一款桌面电脑,并最终将会导致大型机的灭亡。Alto在著名的施乐公司帕洛阿尔托研究中心(PARC)被开发和使用,它是第一个可以使用的图形界面的计算机,和一个拥有3个按键的鼠标。这是从来没有的,即使一个稍微修改的版本,这颗新星在1981年被卖出了17,000美元。总共有2000个部件被施乐及学术界创造。

1977年:ARCNET,世界第一个商业局域网

在1977年能够让计算机与计算机之间连接的设备被Datapoint公司发明。他们开发ARCNET(附加资源计算机网络)用来连接Datapoint公司里的2200台电脑通过同轴电缆,共享软盘数据存储系统。但最终败给了更实用的以太网,并在1985年被标准化,但这奠定了微型计算机组网功能的基础。而且在今天ARCNET仍然在使用。

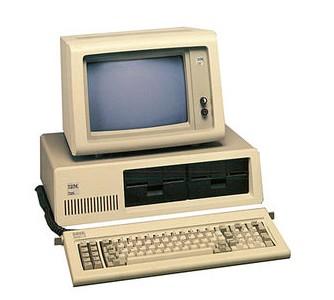

20世纪80年代初:PC的兴起

使用大型机极其昂贵,并且在空间,操作和冷却上消耗大量资源。IBM推出第一款正式的PC,型号为5150,在1982年,公司在全球开始部署桌面电脑,遍及各个企业并且看到了显著地优势就是运行很简单并且只需要很少的冷却。

20世纪80年代:使用虚拟化被质疑

在1980年,无数的个人PC在企业中扼杀了还需要虚拟化来运行多任务处理的方式。当时虚拟化一直被弃置,直到1990年末这项技术找到了新的用途才焕发新生。

20世纪90年代早期客户端 – 服务器计算

大约20年前,微型计算机产业进入到了繁荣期,台式计算机搬进了原来大型机的房间,结合廉价的网络设备于是一个非常好的客户服务计算模式诞生了,除此之外主机托管,数据中心等一系想法涌现出来。

20世纪90年代末:互联网和不间断运算

互联网,在20世纪90年代中期出现了拐点,开始向大众市场普及,它带来了近十年使用数据中心的狂潮。企业开始需要一个永久的互联网支持,网络连通性和场地出租服务发展成为一个企业的要求。互联网服务提供商和托管公司快速发展,互联网数据中心,也开始由数百和数千台服务器组成。对于大多数公司来说,数据中心成为了一个常见的服务模型。

21世纪初:能源与效率的问题

PC和数据中心行业蓬勃发展带来了前所未有的商机和使用计算机的需求,与此同时应对这些设备的能源需求也在增加。早在2002年数据中心就占美国能源消耗的1.5%,并且每年正在以10%的速度增长。每年有超过500万个新服务器被部署,成千上万的家庭需要新的能源支持。专家们警告说,电力过度被使用。硬件厂商开始更多的关注能效问题在未来的发展中,减少数据中心冷却方面的能耗。数据中心的设计人员开始开发设计智能方案,使冷却系统在数据中心更有效率。到2007年,大型数据中心运营商开始利用可再生能源,例如风力发电运行自己的数据中心。

2007年:模块化数据中心

最近最具创新性的数据中心模式就是模块化的数据中心,通常以集装箱的形式来部署,箱子里有一套完整的计算设备。其中最有名的就是SUN公司的BlackBox,其模块化的数据中心可以在全世界任何位置交付280个服务器在一个20英尺的集装箱里。这些数据中心可能在视觉上不太好看,但Sun公司当时声称,他们数据中心的成本只有传统的构建成本的1%。BlackBox也是重新关注虚拟化的一个关键支持者,这次是作为一个技术整合服务器资源。

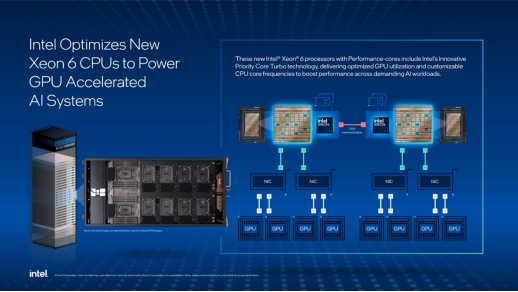

2010与未来:云数据中心

软件即服务(SaaS)正在改变从基础设施上计算的需求,硬件与软件的控制模式正在向订阅和能力需求模式转变。这种模式有利于网络基础设施和数据中心运营商之间的合作,同时数据带宽需要巨大的增长。尽管可能会有一些问题,早期进入这个领域的公司像亚马逊的云服务提供商的业务,以及一些基础设施具有相当规模的公司,大型互联网公司和大的用户群都在设计分布式云数据中心。像谷歌目前就在美国运维着17个数据中心在全球有超过16个数据中心。预计在此刻就有接近200万个服务器在数据中心运行着。