数据中心快速增长的高密度带来了数据中心能耗的急剧增加,这需要我们对数据中心制冷技术不断创新,提升制冷能效。

针对数据中心的冷却问题,其实有多种方案来应对计算性能和密度不断增长带来的挑战。此前根据每个斯坦福大学的一份研究报告,数据中心消耗的电能几乎为整个电能的2%。而IBM的数据则显示,IT带来的碳排放占了全球整个碳排放量的2%。无论是电能的消耗还是碳排放量都在过去几年来不断增长的态势下也在大肆增加。越来越强的计算性能在满足业务需求的他同时,却也给数据中心的能耗带来重大挑战。

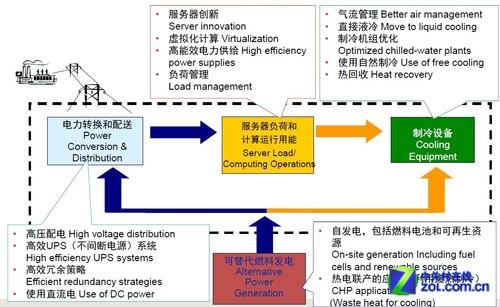

现代数据中心机柜中安装的IT设备越来越多,这不仅意味着机柜用电量大大增加,还意味着后面的所有辅助设施的容量和用电量也相应增加,包括冷却系统、配电设备、UPS和发电机等都会按比例增加。

数据中心能效提高的机会

日益小巧、能效日益提高的芯片架构也带来了更高的计算性能。目前服务器机柜能耗一般为2KW至5KW之间。而对于高端比如Nvidia的Grid则需要耗费45KW。在这些超高密度环境下的数据中心,传统的风冷制冷技术将不再是唯一选择,甚至都不是首要选择。

一、液冷技术

为了解决高热密度机柜中的热点问题,一些数据中心已经开始转向到液体冷却了。最常用的液体冷却技术称为紧耦合制冷,需要用管道将冷冻液(通常为水或乙二醇)输送到高架地板之上或者直接把冷冻液输送到机柜内部,然后通过风和冷冻液之间的热交换达到给机柜内部降温的目的。

利用改进的流体和热动力学可对传统液体冷却技术进行革新,使水冷却更高效。最知名的例子有Flometrics Chilldyne酷弗洛负压液体冷却系统,该系统以支持电信和信息技术测试被部署在加利福尼亚州的加州大学理工学院。

负压液体冷却系统

基于机架直接连接芯片散热的方式,吸取了来自美国NASA对火箭发动机和固定热插拔连接器进行冷却的灵感,也就是允许IT部门通过负液压系统隔离单个服务器。加州大学表示这种液冷方式,可以在传统的液冷方式基础上降低25%至35%的能耗。

浸入在矿物油中的服务器

关于液冷技术,其实早在之前英特尔也发布设计出一种采用矿物油进行降温的方法。

浸入在矿物油中的服务器主板

早在两年前,在德克萨斯州奥斯汀市一家名为Green Revolution Cooling(绿色革命冷却技术公司)的公司着手测试该技术的可行性。测试结果表明,一旦移除计算机上的风扇和硬盘,这种采用油来实现降温的方式会显得非常具有高效。这种采用矿物油冷却系统只需要花费2%-3%的冷却功耗——远比传统服务器的功耗少得多(50%-60%)。

二、“将计就计”热量转换

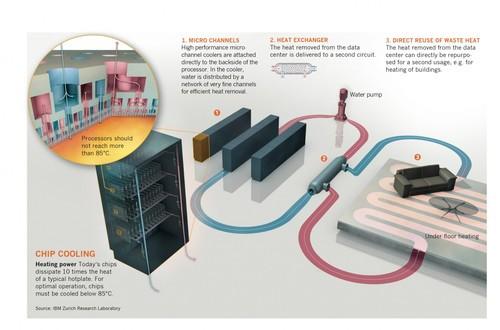

和刚才介绍的液冷冷却方式不同,这里采用“将计就计”的方法,将想方设法排除热量转变为利用服务器产生的热量,从而实现充分利用废弃能源的节能目的。

在2010年,IBM提出一种“热交换系统”的概念,通过吸收数据中心热量的热水被输送到其他建筑物的地板并对室内进行供暖。供暖的热水经过不断循环冷却再流入到数据中心,并通过获得数据中心排放出来的热量再次进行供暖,如此反复周而复始。

IBM“热交换系统”示意图(来源:IBM)

另外还有一种热交换,也就是苹果公司申请专利的更为复杂的一种系统。苹果提出一种利用风能涡轮机叶片的转动能量转化为热量,热量并传统存储在存储的流体当中,在需要时再转换给供电系统。

风能涡轮机

类似的概念其实也包括前面我们介绍的服务器液体冷却,但在当今市场上还不太普遍。通过能源的重复使用可以显著降低能源消耗,并减少数据中心带来的能源成本。

三、因地制宜

因地制宜说得是利用数据中心的选址来设计数据中心的制冷散热方案。

通常来说,数据中心的理想地点并不仅仅有着良好的电力网络、充足的空间和优惠的税收补贴,数据中心本身周围的环境条件也是衡量数据中心选址是否理想的关键。以最大限度地提高冷却的努力。在这方面最具代表性的当属谷歌和Facebook打造的数据中心。

谷歌在数据中心选址上非常谨慎。以谷歌位于哥伦比亚河畔的Dalles数据中心为例,谷歌喜欢将数据中心建设在河流旁边开阔的谷地。而且,可以看出其典型的建筑风格是大开间低层厂房结构,多为结构较为合理的长条矩形状。大型架空冷却塔和底下的储冷罐位于建筑边上,附近是两个为数据中心配套的变配电站。直接采用附近水电站便宜的绿色充足水电来给数据中心供电,空气质量很好。

位于芬兰 哈米纳的谷歌数据中心(邻近波罗的海)

另外谷歌在北欧国家芬兰的一个哈米纳(Hamia)地区修建一座数据服务中心。该地理环境下能够为数据中心提供两大优势——也就是寒冷的气温和极低的电费。该数据中心选址在废弃的造纸厂,邻近波罗的海,可以充分利用自然冷气对数据中心进行降温。更为重要的是,谷歌的这个数据中心其隧道引用的海水冷却,并未对其温度有太高影响。也就是说,对数据中心进行冷却的海水温度从引入到流入到大海,其温度相差不大,从而减少了对环境的影响。

谷歌数据中心利用隧道将海水引入数据中心进行散热

Facebook的第一个欧洲数据中心建在瑞典,也就是谷歌所在国芬兰的东北方的邻国。这里靠近北极圈,可以更好地利用自然冷却资源——寒冷空气即可对数据中心提供全年的自然冷却。

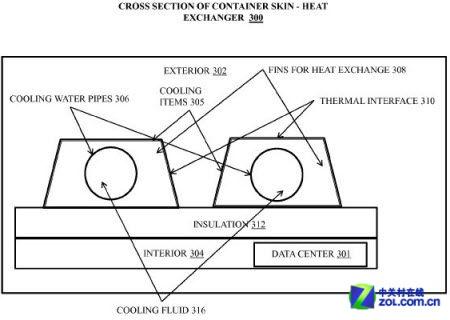

四、数据中心“散热器”

和前面介绍的基本都是通过风冷、水冷等介质对数据中心进行降温制冷。而这里,我们还介绍另外一种更为独特的解决方案——将数据中心视作大型“散热器”。

这项奇思妙想来自IBM与美国专利商标局提出的专利申请,将整个数据中心所在的建筑物视为巨大的散热片。水冷系统安装在数据中心的墙壁上,并通过利用“导热材料制成的波纹板”从而更快地吸收管道中的热量并提高散热效率。想象下,其实就有点类似传统散热器的功能,利用“自然冷却”的效果来实现移动数据中心的散热制冷。

数据中心“散热器”工作原理示意图

五、高温环境也胸有成竹

一直以来,人们都在议论美国采暖,制冷和空调工程师协会(ASHRAE)所描述的冷却要求过于保守。在2008年间,服务器环境中的散热要求推荐为65至81华氏度。

英特尔现场模拟演示高温数据中心负载应用

而目前数据中心的温度通常为68至70华氏度。根据现有大量的研究数据表明,数据中心完全可以支持更高的温度,也就是说可以在更高温度环境下运行,甚至有些设备还能承受高达122华氏度的高温。据此,数据中心冷却的方式可以摆脱基于特定位置的特定温度。目前市面上的很多服务器也都采用了支持高温环境的设计,可以在95华氏度的环境下正常运行。

编后语:

而在目前步入的云计算时代来说,数据中心在其中扮演的功能与角色也愈发重要了。日益严重的数据中心能耗问题,也将会基于这五大方面展开不断创新,包括液冷、热量转换、自然冷却、散热器设计和高温环境。这五大有利于数据中心 冷却的方案领域或各自或结合发挥作用。

但我们普遍认为,在可预见的时期内数据中心不会遇到高功率密度问题,每个机架的平均功率密度仍然在机房空调系统可以承受的范围内。只是随着能耗的增加会给运营商带来成本压力,但这种压力会通过传导给市场带来技术和方案的创新。

而对于未来数据中心制冷趋势来说,除了高性能计算中心和其他基于互联网数据中心(IDC),大部分数据中心将会迁往低价更便宜、电力成本更低的地方,充分利用市场“无形之手”调节并结合制冷技术,不断优化并降低数据中心运维成本,提高能效。