全球超级计算大会(Supercomputing Conference)是全球超级计算产业的顶级盛会,该会议迄今已有28年历史。每年公布两次的TOP 500榜单也被誉为高性能计算领域的“奥斯卡”。

今年的SC16放在了美国盐湖城举办,除了备受关注的“中国”话题之外,在SC16上,可以发现众多超算公司也正在围绕深度学习、HPC云化、高性能数据分析(HPDA)等领域正在做大量的布局和投入。

可以说,这些新方向是未来超算行业的发展趋势,也必将引爆超算行业的下一轮爆点。我认为,这才是本届SC16大会上,我们需要认真学习和关注的新领域和新趋势。

所谓深度学习,就是用多层神经元构成的神经网络,以达到机器学习的功能。这些多层的电脑网络像人类大脑一样,可以收集信息,并基于收集到的信息产生相应的行为。

从技术上来讲,要实现人工智能,就需要数据中心中的机器进行具备大量的计算能力和机器学习能力,应该说目前已经有了初步结果,比如字符识别、语音识别,图像识别等,但也还未完全穷尽,而更高维度的认知探索,业界现在才刚刚开始而已。

在这个过程中,深度学习的重要性就突显出来了,这是因为深度学习是实现机器学习的技术,机器学习则是实现人工智能重要的方法。目前,业界在加速深度学习方面主要采用有两种方式:

第一,优化处理器技术。如在同一个芯片中集成多个处理单元 ,根据集成方式的不同,可分为多核处理器或多路处理器。

第二,优化GPU计算能力。相比之前在游戏、视觉效果中的应用,GPU正在成为数据中心、超算中心的标配,并广泛应用于深度学习、大数据、石油化工、传媒娱乐、科学研究等行业。

可以说,GPU强大的并行处理能力,可以让超算科研人员顺利去设计深度神经网络,轻易的模仿人的思维结构。同时,由于GPU具备强大的经济性,也能让更多的超算科研人员设计出在每一个单元榨取更多性能的机器。

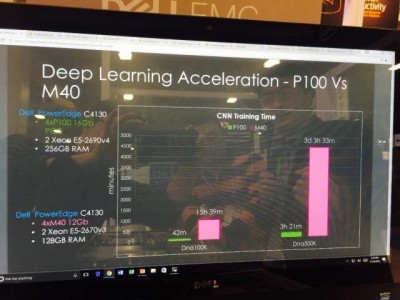

例如,在跑Dna100K时,配备M40 GPU的服务器需要15个小时39分钟,而配备P100 GPU的服务器,仅需要42分钟;同样在跑Dna500K时,计算时间分别为3天3小时33分钟和3小时21分钟。

由此可见,GPU之于深度学习算法的重要性。目前,越来越多的大中型公司,尤其是互联网企业都在将深度学习各个应用领域,这意味着高性能计算和深度学习,将极大的推动人工智能的落地。

爆点二:HPC云化

众所周知,短短几年时间,云计算就以其弹性扩展、资源聚合、快速交付等独有特性改变了创新的思维模式,进而再创出了一个科技新世界。

对于超算供应商而言,云计算也是不得不重视的一个新方向,因为越来越多的客户正在将自身的超算服务以云计算的方式,对外再提供给更多有需求的用户。

与此同时,很多中小公司由于资金的限制,无法购买价格昂贵的高性能计算服务器,这时候HPC的云计算服务就显得十分的重要。

例如,一个动画公司,接了一个单,要在三个月之内以很大的计算能力来完成动画的制作,当然在三个月之后他就不需要这些能力了。那怎么办?购买设备来维护的话,成本很高,这时候就可以到云服务提供商处申请一些HPC的资源,就能完成工作。

再如,HPC云化服务在高校科研计算领域也有很大的需求,如今高校中HPC的相关应用场景越来越多,数值计算、工程仿真、航空航天、大数据处理、材料科学研究,生命科学。

但是,多年来高校现行的IT建设体制,造成了资源冗余、系统分散、软件部署难度大等诸多问题,而如果采用云超算服务,就可以实现云中交付集群应用,大大减轻了高校的计算和科研压力。

目前,在美国,亚马逊AWS、微软Azure,都已相继推出了各自版本的HPC集群服务。在国内,前不久阿里云也推出了HPC并行计算服务,从这些云计算服务商的选择来看,也说明HPC云化的趋势已经十分明显了。

不过,HPC云化也有很多需要解决的难题,那就是不管使用哪一种模式上云,特别重要的是确保基础架构,都需要同时利用物理资源和虚拟资源的管理层,因为HPC应用程序仍主要放置在物理机器上。

所以,在理想情况下,HPC云化的关键因素,是要能够把虚拟机管理程序环境和物理环境合并为一个动态共享的基础架构,既支持多种操作系统,又支持异构环境。

此外,对于不使用VMware虚拟化管理软件的HPC客户,戴尔则提供Cycle Computing软件以及面向云编排及高性能计算工作负载管理的相关服务,目前已经可以支持亚马逊AWS、微软Azure与谷歌云的服务。

实际上,HPC从科学计算走向商用化、民众化已经是可见的事实,因此“HPC in Cloud”把高性能计算与云计算结合,利用云数据中心普通X86服务器构建高性能计算集群,无疑也是大势所趋。

爆点三:HPDA

高性能数据分析(HPDA)并不是超算领域最新鲜的话题,但是HPDA市场发展一个重要原因就是大数据分析、云计算等互联网新应用的驱动,反过来又促进了超算行业的发展。

可以说,HPDA如今不仅广泛应用于机器学习和人工智能领域,在很多商业和工业领域也大有用武之地,如互联网应用中的消费者行为分析、搜索排名分析,传统行业中的医疗保健、物流分析、金融欺诈检测,以及工业应用中的产品设计、质量分析等等。

IDC高性能计算研究副总裁Earl Joseph在SC16上的专题研讨会表示:“HPDA是大数据和HPC结合起来发挥最大优势的新应用,大数据毫无疑问将对HPC的发展有重大影响,我们预计它将成为HPC增长的主要动力之一。”

IDC预计,在未来6至18个月内,超过33%的工作负载将用于HPDA;在制造和科研领域,HPDA工作负载预计分别为20%和16%。预计到2020年,HPDA市场将在新的商业分析细分市场中增长26%。

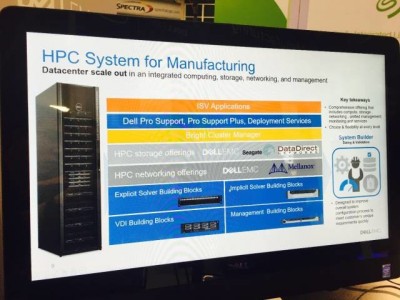

同样,针对HPDA市场的爆发,可以看到戴尔今年向HPC市场推出了一系列的“HPC Systems”家族,在生命科学、制造及教育科研领域向客户提供“开箱即用”的HPC系统,也可以称之为“HPC即服务”。(参见《软硬兼施两翼齐飞 解码戴尔HPC新策略》)

此外,戴尔的HPC系统还增加了对精准医学领域的特别支持,这是因为戴尔认为下一个新的HPDA新应用领域无疑将是精准医学,这是因为大量患者的基因组,病史和症状数据,都需要靠高性能计算得出结果。

通过SC16释放出的新信号,不难发现超算正在经历转型,现在的超算尽管也一直在助力科学的进步、研究,但是它也在助力工业和商业领域的新创新。因此,深度学习,HPC云化和高性能数据分析这三大新方向,无疑将带给超算更大的增长空间。