用户HPC选型,最重视什么?毫无疑问是性能。用户部署HPC就是需要超高的计算性能。当然,HPC系统的高可靠性、易维护性以及价格和功耗成本,也是用户会关注的重要因素。

超算的核心目的:极致性能

集群的规模、互联架构和集群的效率是决定性能的三个关键因素。

集群规模,也就是CPU、内存等硬件的数量,是决定性能的重要因素。同时,集群的架构,也即总线连接和网络架构,也是决定了整体性能的高低。最后,集群的效率,也是影响HPC系统性能的关键因素之一。

12年曙光做的星云(Nebula)超级计算机曙光5000A,发布的是星云系统峰值为每秒3000万亿次(3PFlops)计算性能,但效率其实只有40%左右。目前,业界对CPU、内存等硬件的利用率,已经能够到80%左右。

在从用户视角来看:集群规模受限于机房空间,虽然目前出来很多立体机房,机柜可以叠加,但空间仍然有效。在机房空间固定的情况下,集群规模是受限制的,CPU等硬件数量无法持续提升。同时,用户的预算有限制,同时,存储有限制,硬盘可以用8T,未来用10T12T,但最终空间也是有限。

大部分用户都会使用风冷的技术,风冷比较简单。这时机房的PUE能够1.5-3左右。而在空间有限、节点有限的情况下,其实利用水冷,可以做到更高的密度,更好的效率。

同时,机房有功率的限制,同时机房里还有大量的和能源相关的设备,比如UPS,因此从功耗的角度来设计,去除UPS等附属硬件,PUE值能够大大缩减,做到1.1-1.25。

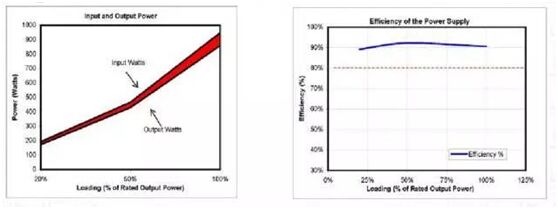

效率和使用的处理器、主板都有关系。但我们必须从另外的角度来考虑,也就是从电源使用的角度。目前,有效使用电能(50%负载最优)需控制计算队列。水冷的目的是更多将电能用来进行计算处理,来提高计算性能!

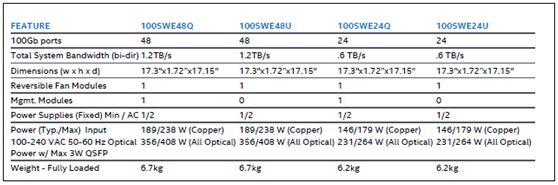

如果把某一些端口,直接换成铜缆,传输率是一样的。但可以极大降低功耗,比如每个交换机节省100w,16个交换机的节省,可以达到额外增加4个节点,极大的提高性能。

什么场景下可用水冷?

用户以提升计算性能、计算效率为核心需求。也就是关注性能,而不是关注价格。毕竟水冷会比风冷更贵一些。

同时,用户有室外空间来放置水冷设备,同时,机房基建与计算集群同步建设的环境。如果已经有风冷的设备了,再拆掉重新布置水冷,就有些不值了。

使用水冷的用户,大部分都是机房空间有限、供电有限的用户。因为水冷可以大大提高密度,同时降低电力消耗。

在水冷的项目里面,目前有很多国外的经验可以借鉴。

比如无冷凝水冷的温水二次利用。对于高校、政府等用户来说,水冷可以变成供暖的水。在集群规模够大的情况下,水冷系统可以产生高于65摄氏度的热水,在循环之后,当水温低于45度,又可以再次利用。

另外,利用Absorption Chiller吸附式冷凝机。水冷主机不需要供电,也即是零功耗,就可以实现温水的二次循环散热,而且整个系统能够达到50KW的大功率。

联想水冷技术应用全球

联想是HPC最先走出国门的企业,为众多世界级超算中心提供产品方案和技术支持。比如在欧洲最大的学术性数据中心之一——莱布尼茨超级计算中心里,联想帮助他们打造了11000个节点的SuperMUC直接水冷超级计算集群。该集群峰值计算速度达到9千万亿次每秒,向整个欧洲的研究人员提供超级计算资源,研究领域包括天体物理、生命科学等。

除了在性能上的提升以外,因为采用了联想首创的45度温水水冷技术,新的集群系统实现了1.1的PUE值,远低于1.5-3的业界一般水平。联想让客户5年整体电费下降37%——从2760万欧元降至1740万欧元,节省了超过1000万欧元。

(SuperMUC占地示意图,图中橘黄色管线是水冷管)

除了莱布尼茨超算中心,联想在欧洲也帮助西班牙巴塞罗那、意大利博洛尼亚CINECA等众多客户搭建了世界级超算系统。在全球高性能计算Top500排名中,联想以99套连续两年保持中国第一、全球第二的位置。我们的超级计算机,服务全球各个国家的客户,在高能物理、生命科学、气象、海洋、环保,航空航天、石油勘探、智能制造和互联网等众多领域,助力客户业务创新。

最近,联想利用水冷技术,最近中标了北京大学的超算中心项目。这是全国第一个应用水冷技术的超算中心,它不仅仅能够提供超级高的计算性能,同时也将为学校和国家节省大量的能源。

结语

如果简单来看,HPC系统性能和功耗很多时候是对立的。因为功耗低了,往往性能会受到影响。但通过水冷,不但做到了节能环保,更是对于计算性能的极致提升。