如今人工智能 (AI) 的发展迎来了令人振奋的时刻。曾经只有具备深厚专业知识积累的公司才有可能使用人工智能,但短短几年后,随着软件工具、生态系统和硬件开发的日趋成熟,越来越多的公司开始应用人工智能,英特尔的众多客户通过人工智能技术在各种行业案例中取得了变革性的成功。同时我们也发现,并不存在某个单一的“最佳”硬件能够运行各种各样的人工智能应用。因为人工智能的形式是多种多样的,不同的应用也决定了从数据中心到边缘再到设备所需的硬件能力都会有所差别,因此我们需要更加多样化的硬件产品组合来满足不同的需求。英特尔人工智能产品能够满足多种多样的人工智能应用需求,在各种应用场景中都将为英特尔客户带来最高的回报。

从擅长对大量非结构化语音和文本数据进行训练和推理的英特尔至强可扩展处理器,到为实时推理提供出色吞吐量和低延迟的英特尔FPGA,再到为摄像头提供超低功耗推理的英特尔Movidius视觉处理单元 (VPU),以及即将推出的英特尔 Nervana神经网络处理器(英特尔NervanaNNP),无论数据是存在于设备还是边缘,是数据中心还是在云上,英特尔提供了一个深度硅芯片基础,来实现数据中心的创新。除了硬件平台,英特尔在软件上也在进行大量投资,让不同的产品组合之间可以转换功能,从而不受限制地将人工智能带到各种应用程序中去。例如nGraph™这样的开源项目,降低了在不同硬件平台对不同深度学习框架(TensorFlow、MXNet、PyTorch等)进行优化的难度,使得开发人员可以向其客户提供最佳的体验。

采用英特尔至强可扩展处理器进行高级深度学习训练

挑战:通过自动分析显微镜图像中数千个不同的个体特性发现新的治疗方法,这些图像尺寸远大于传统深度学习数据集中的图像尺寸

解决方案:利用基于英特尔至强可扩展处理器平台的大内存容量和高性能计算能力

高内涵筛选是药物研发的重要工具,这是一项极具挑战且极耗时的工作,需要从图像中提取数千个预定义特性。在英特尔以数据为中心创新峰会上,我们谈到了诺华正在与英特尔合作,利用深度学习技术来加快细胞培养显微镜图像的分析,以研究各种治疗方法的效果。由于使用了完整的显微镜图像,本评估中的图像尺寸比普通深度学习基准中使用的图像尺寸大得多,是ImageNet数据集中图像尺寸的26倍以上。

由于训练模型中的参数数量多,所用图像的尺寸大、数量多,便对计算和内存能力提出了更高的要求。研究团队使用了英特尔至强可扩展处理器、英特尔Omni-Path架构和TensorFlow v1.7.0搭建的系统进行训练,把训练时间节省了20倍。英特尔硬件可支持卓越的内存容量,支持每秒处理120多张3.9兆像素的图像。

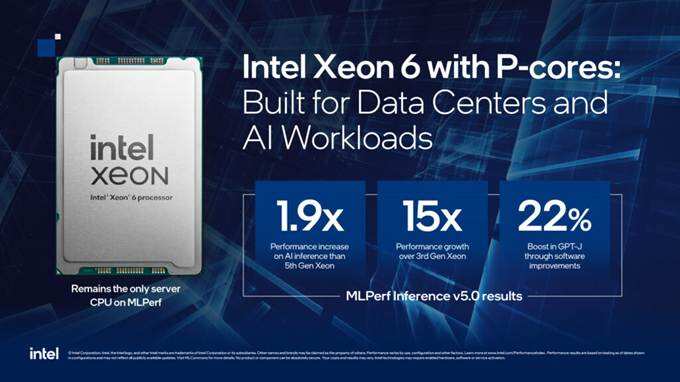

正如案例所示,CPU架构更能满足很多现实情况中的深度学习应用需求,基于英特尔至强可扩展处理器的平台性能通过持续地投资也在不断增强。自平台推出以来,其针对流行框架的训练速度提升了1.4倍以上,而INT8推理速度则提升了近5.4倍。随着新一代英特尔至强可扩展处理器的推出,推理速度更有望提升至11倍。未来对英特尔傲腾™ 数据中心持久内存的平台支持,还将扩展CPU附近的内存容量,以支持对更大数据集的训练。在创新峰会上,我们还宣布推出英特尔DL Boost,这是一套旨在加快人工智能深度学习速度的处理器技术。Cascade Lake还将采用矢量神经网络指令集(VNNI),以前需要采用三条指令,而现在只需要一条指令即可实现。Cooper Lake是继Cascade Lake之后的又一款英特尔至强可扩展处理器,将整合英特尔DL Boost功能(Bfloat16)以提升人工智能/深度学习训练性能。

正如英特尔精选解决方案,我们致力于简化客户对英特尔至强处理器的全栈部署。Apache Spark*上针对BigDL的全新英特尔精选解决方案配置是我们与阿里巴巴、亚马逊、中国电信、微软和Telefonica等行业领先企业合作的成果,这也是我们从数百次部署BigDL中获得的重要经验,旨在提供配置让客户能够在现有数据湖快速部署人工智能功能。该解决方案涵盖硬件和软件组件,是我们第一个面向人工智能的英特尔精选解决方案。

采用英特尔FPGA进行实时深度学习推理

挑战:开发可灵活扩展的实时深度学习平台,可跨多个微软用例

解决方案:利用英特尔ArriaFPGA的微软Project Brainwave*硬件架构

微软Project Brainwave是一个深度学习加速平台,它是基于自适应、节能、高通量的英特尔FPGA构建的。由于其经济性和极低延迟等特点,Project Brain-wave能够实现实时推理。在不断发展的人工智能环境中,FPGA能够重新编程以获得最高性能,是搜索、语音识别、视频分析等很多深度学习应用中的重要工具。

微软最近推出由Project Brainwave提供支持的Azure机器学习加速硬件。这项服务让开发人员和数据科学家能够在Azure和边缘计算中运行实时模型,应用领域涵盖制造业、零售业和医疗保健等。

微软还将Project Brainwave应用于新的必应*搜索功能,以缩短搜索时间并让搜索结果更加智能化。必应通过机器学习和阅读理解能快速提供智能化答案,帮助用户更快地找到想要的答案,而不是提供链接列表让用户去手动检查答案。英特尔FPGA能让必应将模型的延迟缩短到10倍以上,同时将模型尺寸增加10 倍。

采用英特尔Movidius Myriad视觉处理单元,在边缘端实现视觉智能

挑战:自动捕捉和管理家人、朋友和宠物的动态照片,在边缘设备完成视觉处理

解决方案:搭载英特尔Movidius Myriad 2视觉处理单元 (VPU)的Google Clips*无线智能相机

借助英特尔Movidius低功耗、高性能的VPU,谷歌实现了对Google Clips相机的构想。使用英特尔Movidius Myriad 2 VPU,可以直接在相机上实时运行高级机器学习算法,这可以帮助谷歌完善相机功能,降低功耗,并支持离线使用。

英特尔Movidius VPU的目标应用包括嵌入式深度神经网络、姿态估计、3D深度感测和手势/眼睛跟踪等。随着“相机互联网”的爆炸式增长,英特尔Movidius VPU为创新应用带来了多种功能。此外在设备上直接进行人工智能处理也更符合隐私和安全保护的规范。上述设备以及未来的英特尔Movidius VPU将继续为视频分析、机器人和增强现实等应用领域带来价值。

采用英特尔Nervana神经网络处理器进行新一代训练和推理

挑战:利用全新构建的架构打破当前的系统瓶颈,支持新一代突破性深度学习解决方案

解决方案:即将上市的英特尔Nervana神经网络处理器

随着人工智能的发展,模型的复杂度不断增加,对内存的需求也越来越大。深度学习的进一步发展需要解决内存限制的问题,而当前的解决方案无法利用所有可用的计算,数据科学家和研究人员逐渐意识到我们需要专用的芯片来支持深度学习训练和推理。英特尔Nervana神经网络处理器提供了一种全新的解决方案,它专门为支持深度学习设计和构建,目的是为了解决内存的问题。

英特尔Nervana NNP首先考虑内存,它采用了大量高带宽内存和SRAM,更靠近实际进行计算的位置,也就是说芯片上能够存储更多的模型参数,可以有效节省功耗并提升性能。英特尔Nervana NNP支持大多数深度学习基元,同时让核心硬件组件尽可能高效的工作,确保其他应用(例如图形)不会从深度学习应用中占用内存。此外,英特尔 Nervana NNP的高速片内和片外互连支持大规模双向数据传输,能够在多个机箱之间连接多个处理器,可以作为一个更大的高效芯片来容纳更大的模型,从而获得更加深入的洞察。

英特尔与Lake Crest软件开发工具(SDV)方面的主要客户合作进行NNP 开发、测试和反馈。在推出第一款商用Nervana NNP时,以上功能都能够实现。随着人工智能领域的进一步发展,我迫不及待地想从这些突破性芯片中看到英特尔客户的创新和更多见解。

简化异构部署和加速人工智能创新的软件

框架和库对于推动人工智能的发展至关重要,硬件需要同软件结合来发挥最大的效用。英特尔致力于通过普遍适用的多架构解决方案,将所有人工智能都集成到一个软件集合下。比如开源nGraph编译器等项目是非常重要的,因为我们无需把时间浪费在重新发明工具上。

我们认为,英特尔有责任优化软件,提供工具,让硬件发挥最佳性能,并简化模型开发和现实部署之间的流程。利用英特尔开源性能库,可以从深度学习的直接优化中获得更多洞察;深度学习编译器nGraph已经开源,能够跨多个框架和架构运行训练和推理;使用OpenVINO™可以快速优化预训练模型,并将视频神经网络部署到各种硬件上;BigDL 是运行在Apache Spark和Hadoop*集群上的分布式深度学习库,通过BigDL 可以处理大量数据。

针对数据时代提供优化的客户解决方案

英特尔正在帮助客户更好地处理每天生成的大量数据并从中获得价值。我们致力于提供全面的硬件和工具组合,实现人工智能愿景。在实际应用中,人工智能的复杂性要求我们将正确的硬件和软件结合起来从而实现成功部署。英特尔拥有业内熟知的全栈实力技术生态系统,提供不同功能工具,推动人工智能的发展。