4月23日,以“软件定义存储未来”为题的首届软件定义存储峰会在深圳正式召开。在下午的超融合论坛上,Mellanox解决方案营销总监张辉发表了《智能网络全面加速超融合到企业云的升级之路》主题演讲,为我们带来企业级存储及数据中心网络趋势,并分享了智能存储网络技术如何助力超融合以及企业云的发展。

以下为演讲文字整理:

大家下午好,我今天讲网络,但实际上我是做存储出身,在EMC十余年。因此,今天会从网络角度看存储的变化,以及从网络层面如何应对。

主要从三个方面来讲——企业级存储及数据中心网络趋势;智能存储网络技术亮点分享;迈向企业云之路。

关于存储架构的转变趋势。第一个是横向扩展架构。传统架构的都是往上加,控制器到后面有了四控八控之后到十六控其实也已经到极限了,我想说的是整体IT支出比较大,随着整个技术的发展我们开始做软件定义,以前基本都是横向扩展架构,大家都见证这个发展的过程。

之后是闪存架构的出现。我们第一次销售闪存是2008年,从最早的SAS到速度更快的闪存其实都是性能更高了。

第三个趋势就是超融合架构。之前的嘉宾有介绍,在此不再赘述。第四个是云计算架构。我们以前讲存储的时候都是把自己局限为一个存储,把数据沉淀之后你用就可以了。但现在大家发现不是了。还有公有云,私有云以及混合云,存储本身不是简单存储数据的问题,而是和云的融合。

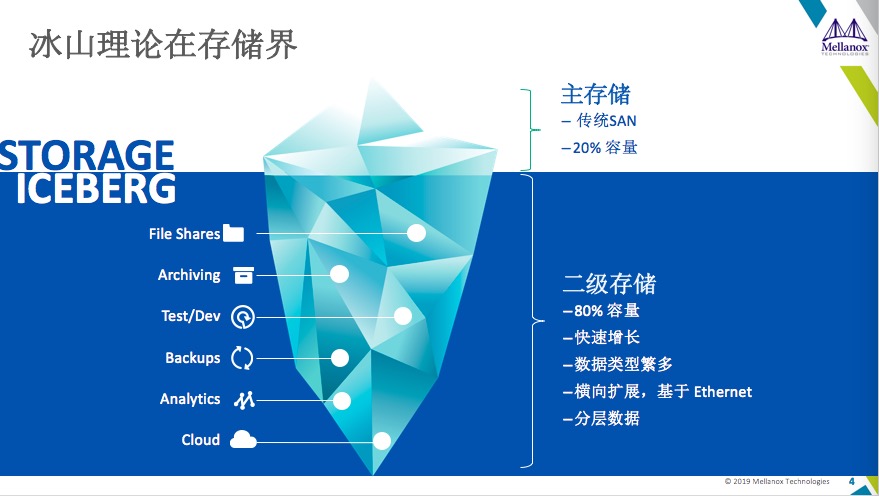

尤其是多云情况下,大家现在的共识是未来是一个多云的状态。我们看一下存储其实承接的都是二级存储,二级存储市场给了我们很多的想象空间,也给了我们很多去试的东西,但它的数据量增长和想象空间其实不在这里,你会发现做存储的厂商几十家是有的,甚至还在不断的增加。

回到今天的主题。我们说网络其实也在变化,做存储的可能不太关注网络,传统网络核心是一个大机放在里面,可能一个机房就那么一个大东西,早期状态都是集中式,我的计算节点到核心层再下来之后其实都是中心化的。

随着现在分布式存储发展,大家会发现首先小机应用更加广泛,相对来讲大家对IT的依赖比较高,一些保守行业也开始做分布式架构,并且都是去中心化——所有的节点之间是平等的,计算和计算之间,存储和存储之间都是平等的。从前的传统架构南北向,但分布式架构,就变成了东西向,节点监控比较多,要求你不能这么玩了。

所以这里就有了一个分布式架构,任何联络节点之间的通讯可以做到更快,但在核心接入的网络里,由于下面连接太多,很难做到无堵塞状态,你会发现核心到了这个地方有了一个趋势就是东西向流量的增加和变化会导致结构的增加。

以前只是说做计算间的通讯,网络间的通讯不多,以前不是带宽的问题,是重协议,导致效率不高,现在的变化就是你的协议优化之后,我们会让以太网作为未来构建存储架构的核心网络,因此这里我提了一个词是发挥以太网的存储网络。

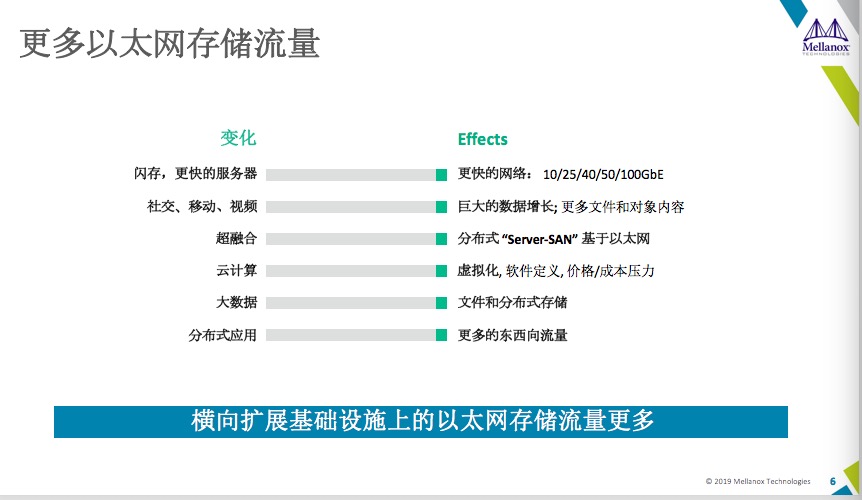

我们看一下这横向扩展基础设施上的以太网存储流量变化和影响,第一个就是闪存的增加,还有CPU的核心带宽,当然我们各种应用的数据增长已经到了你无法预测的程度。还有就是超融合,云计算。但是我们都知道这两者会导致你基于以太网存储的流量会越来越大。

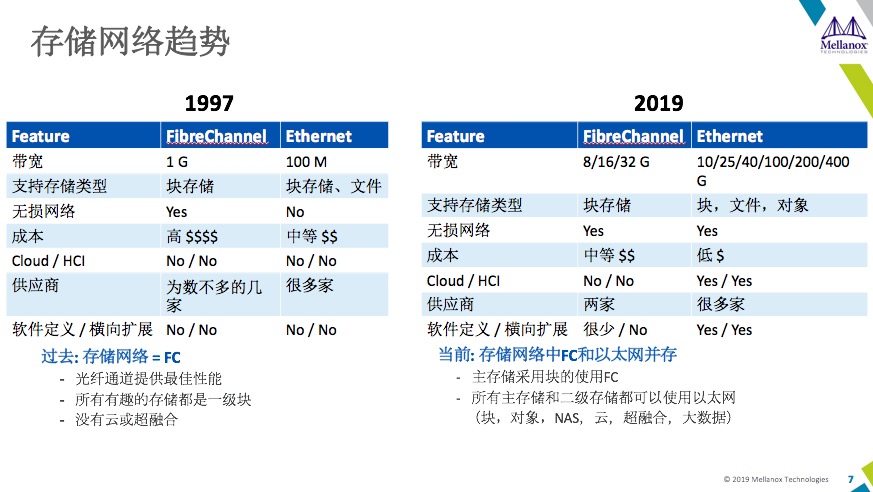

回顾一下存储网络的情况,左侧1997年,右侧2019年。其实在20年前看的时候,很明显就是FC(光纤通道)带宽高,网络又好,成本可能高一些,在过去存储网络=FC,而现在是存储网络中FC和以太网并存。

2019年,FC发展似乎有点止步不前,但我相信很多人还是用FC,但端口速率不会太高,而以太网是400G,以现在最快的32G带宽对比,可以差出10倍。

对于存储类型早期是有对象存储概念,但现在二级存储越来越多,包括我们看到投资领域看到二级存储或者是偏备份类拿到的融资更多,所以这基于文件和项目来说,早期网络成本明显更低。

供应商其实也很明白,无论是企业用户还是制造类小用户都在担心被锁定,这个需求变化非常痛苦。以太网对比很简单,就是谁更带宽好一点,但迎合一级和迎合二级的区别非常大,只有一两家的时候很可能就形成垄断。

整体来看,未来趋势一定是以太网更多,FC也会有自己的市场,就和多云一样是并存状态。

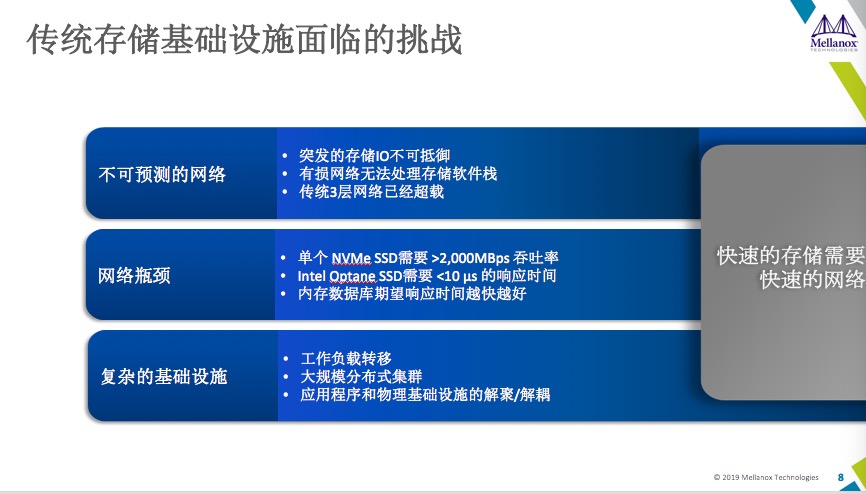

我们再来看一下传统存储面临的挑战:

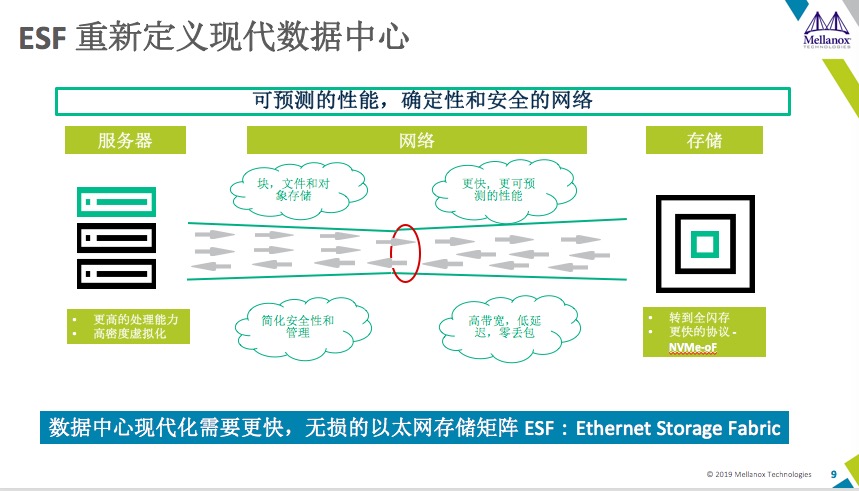

基于网络流量不可预测,网络瓶颈(所需高吞吐量,低延迟和快速响应时间)以及复杂的基础设施要求在现代数据中心采用基于以太网的专用网络结构进行横向扩展存储。因此,“以太网存储架构”,即“ESF”出现以应对挑战。ESF可在内部部署,云端或远程后端/DR站点及所有类型的存储(块,文件和对象)上提供可预测的性能和安全性。

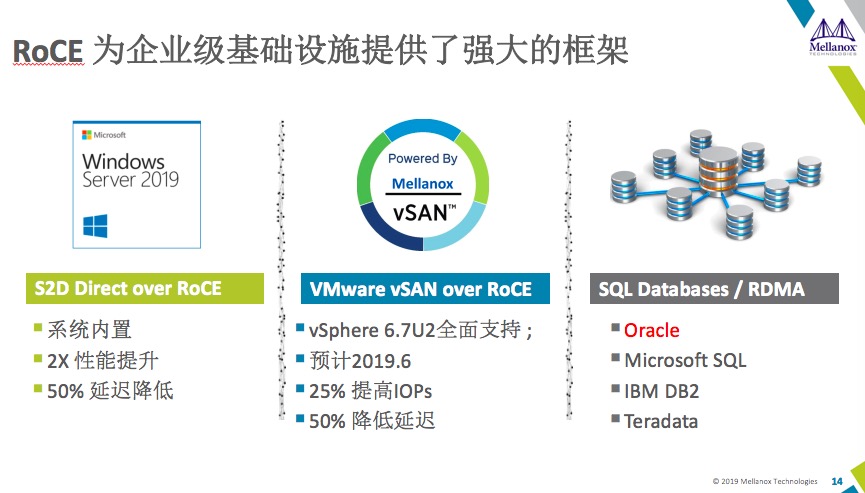

高速的网络需要高效的延迟,RoCE必不可少。

前面我做了很多的铺垫,我们看一下超融合对于网络的诉求,当然有很多,我简单说几个,也未必全,大家可以和我交流。

第一是理想的端口数和尺寸。其实我们实施项目的过程当中,我发现超融合规模其实没有那么大,绝大多数是10个节点以内,这个时候你发现用传统的以太网,10个节点的超融合用一个1U的交换机,你的端口数浪费了一大半。再一个就是功耗,因为现在节能减排,包括数据中心本身的功耗都让你减少散热。

因此如何在满足规模性的情况下尽可能满足自身运营成本的需求。第一个就是合理的端口数。第二个是始终如一的高性能。存储其实不太接受网络本身的波动,因此早期我们说基于性能的管控,FC不会有太大的波动。

还有一个就是自动网络调配,并且你要进行监视和故障排除。最后一个是灵活扩展,以上是超融合的几个基本网络诉求。网络想要发挥自身作用还需要很好的支持——网络要可靠,要优化,要低延迟。

关于智能网络助力企业云之路。基于 BGP-EVPN 的 DCI是从跨多个云的底层物理网络基础架构上抽取网络控制层面。因此我们可以通过集成二层-三层网络管理与云解决方案的网络虚拟化和安全管理层面,进一步简化多云运营。

智能交换机的高级管理软件提供对网络配置和实时状态的深度可见性,让数据中心操作员只需点击几下鼠标,就能配置、监控高速端到端以太网网络,并进行故障排除。并要能够与第三方管理软件无缝集成,进一步简化了一个云的本地网络和多云环境中的数据中心互连 (DCI) 的网络设计、预配置、运行和故障排除。

在多云环境中,业务连续性是当务之急。随着应用程序因扩展或灾难恢复而在云之间移动,联网通常仍是确保业务连续性的重大挑战之一。这需要超融合厂商和网络解决方案上紧密配合,自动实现网络预配置,作为工作负载生命周期管理的一部分,并允许工作负载在故障转移到目标站点时保留其 IP 地址,从而在部分或全面故障转移过程中实现业务连续性。这些功能借助 VXLAN/EVPN 叠加得以实现,允许跨主站点和辅助站点透明地延伸网络。

(文章根据现场速记整理,未经本人审核)