“您好,京东,您的快递到了,麻烦取一下!”听到这句话可能大多数人的心情都会很愉悦。

网购已经成为国人现代生活中不可或缺的行为之一,京东是中国首屈一指的B2C电商平台,以商品种类繁多、当天下单当天送达、正品保证以及退换无忧等等优点成为网上购物的首选平台,用户的青睐也使得京东的营收蒸蒸日上。据京东提供的数据显示,在2018年京东全年交易额超过17000亿元,年均复合增长率接近140%。在今年(2019年)的618活动中,其交易总额超过2000亿元。

自2014年5月上市以来,京东集团每年的交易额都飞速增长,这背后是京东超过17.9万名员工的不懈努力,如身着红衣脚踏电动三轮的“京东小哥”,还有声音甜美圆润的京东客服,以及不善言辞闷头苦干的工程师团队……等等。除此之外,还有一批特殊的“员工”,它们支撑起了京东商城每天成百上千万次正常访问——数万乃至数十万台IT设备,典型如服务器。

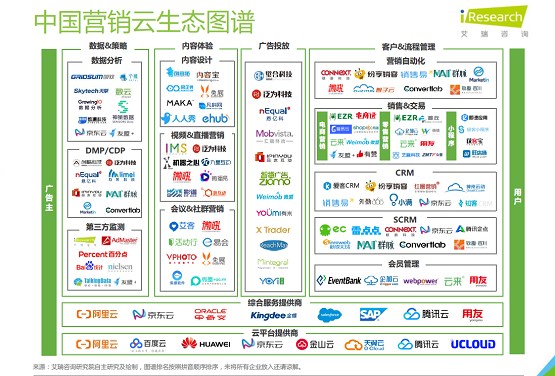

这数十万台设备分布在全国各地的数十个数据中心内,形成以华北北京、华东上海、华东宿迁、华南广州为核心的4大区域总计10个可用区的整体布局,再辅以数十个遍布全国的小型IDC机房,由此成就了京东云——为京东集团业务提供IT支撑,并对外提供云服务,为合作伙伴数据中心转型提供帮助。

为探寻互联网企业高速发展背后的秘密,考察其在数据中心方面的技术探索与成果,由E企研究院发起的“数字中国万里行2019”活动华东区首站选择了京东云最大的数据中心——位于江苏省宿迁市骆马湖畔的京东云华东数据中心——这也是京东云首个自建的数据中心园区:总投资35亿元,占地200亩,相当于19个标准足球场面积之和;整体由4个云数据中心模块和1栋综合大楼组成,单个数据中心模块约有4.5万台标准服务器安装与部署能力。目前一期已于2016年投产运营,除了为京东商城提供支撑之外,还为京东数科、宿迁市政府、中国联通与中国电信等客户提供云服务。

挑战与收益:为何巨头青睐自建数据中心

数据中心是一个重资产行业,仅建设就需要投入数十亿元,如京东云华东数据中心仅一期建设就投入了15亿元,这还不包括建成后的服务器等IT设备的采购成本以及投产之后的运营成本,以单个数据中心4.5万台服务器容量计算,每台服务器300W(瓦特)为例,再加上冷却系统的耗电(以年均PUE=1.3计),每年仅电费支出就以亿元为单位(按江苏省大工业用电价计算)。

但自建数据中心却是迈入“巨头”行列的入场券,纵观国内外的互联网巨头,无一不拥有自建数据中心,且随着数字化进程的加快,他们也都在加速自己的数据中心建设。自建数据中心虽然投入巨大,但却有其独有的优势,作为IT的基础设施支撑,自建数据中心所有环节都由自己掌控,可以按照IT的需求而设计建设。

仅就机柜供电来说,不同业务场景对供电的要求是不一样,比如冷存储场景单个机柜可能只需要3~5KW(千瓦)的供电就能满足,计算密集型应用单个机柜可能需要5~8KW的供电,现在火热的AI技术所需服务器则要求机柜更高的供电能力。传统租赁数据中心内的机柜供电大约在3~5KW左右,供需之间的不平衡,必然造成不便和资源浪费。而京东云华东数据中心在机柜供电方面就有多种选择,比如4KW供电能力的标准模块、8KW的高密模块以及12KW的微模块机房,这为应用部署提供了灵活性,同时又起到合理利用资源的作用。

IT在现代社会中所发挥的作用已经毋庸多说,尤其是对于以京东为代表的互联网企业而言,IT就是核心竞争力,如何保证IT不停顿、业务不中断是头等大事,尤其是数据中心规模日趋增大的情况下,一旦数据中心不可用,意味着其所承载的多个IT系统都将面临中断,对于云数据中心而言,还将影响大批用户,其后果将是灾难性,几乎无法用数字来衡量。

发展多年的传统数据中心在可用性建设方面多个标准可以参考,但这可能并不完全契合互联网云数据中心的可用性特点。以常见的美国数据中心行业Uptime机构制定的Tier 4标准为例,其要求数据中心符合2N和物理隔离设计,这对于传统数据中心而言,具有很好的指导作用。但并不太契合云数据中心的特点,云数据中心在单体数据中心之上再有“可用区域”的概念,通常由相隔数十公里的多个数据中心组成一个可用区,当某个数据中心故障后,其业务可由同一个可用区内的另一个数据中心接管替代。这实际上在单体数据中心更高一级的层面实现了2N可用性。

互联网巨头们自建数据中心是“新(需求)旧(标准)冲突”下为契合自身业务需求而进行的探索实践,公有云提供商的云数据中心通常符合Tier 3标准,部分系统使用Tier 4中的2N和物理隔离设计,也许从单个数据中心来看可能并未达到最高可用性,但从“可用区”层面来看,其实际上超越了Tier 4标准,在一定程度上而言,与最高可用性等级的金融级数据中心“两地三中心”理念颇有相似之处。

云数据中心建设:自上而下,以业务为前提

传统租赁数据中心建设,除了极少数之外,大多是先有基础设施,再对外承接业务,所以同样是为了满足业务需求,但传统租赁数据中心考虑到不确定的多种客户需求,通常采用通用、成熟的标准化技术,遵循主流标准进行建设,供需不平衡在所难免。但互联网云数据中心则是自上而下进行建设,即先有业务需求,再自建数据中心。作为IT的承载,要探寻互联网云数据中心的特点,必然要先了解其IT的特点。

喜欢定制是互联网巨头们的一大特点,自建数据中心也可看作是对数据中心进行定制。连数据中心都要定制,位于核心的IT进行深度定制也就不难理解了。京东云从IT硬件底层就开始进行定制,比如处理器,京东云华东数据中心内的服务器就全面采用定制的第二代英特尔至强可扩展处理器,即代号为Cascade Lake的至强处理器。

相比于上一代SkyLake处理器,相同定位等级的Cascade Lake处理器多数拥有更高的主频,即计算性能更好,这也是为什么互联网巨头们喜欢采用新硬件新技术的原因之一,这实际意味着每单位计算成本的下降,即相同的一块钱可以买到更多的计算性能。当然其前提是采购量大。互联网巨头,尤其是公有云服务提供商每年都有数万台乃至数十万台服务器的采购量,其收益自然不言而喻。而京东云不仅承载京东商城业务,还对外提供云服务,服务器需求量越大,从新产品中获益当然也就越多。

而定制处理器的好处在于,可以释放处理器更多的计算性能,比如拥有更多计算核心,或者更高主频,亦或是二者皆有。更多的计算核心或更高的主频通常意味着更高的供电能力与更强的散热需求,这也是自建数据中心的一大优势,能够提供满足IT所需的供电与散热要求。

与定制处理器联动的是对服务器的重新设计。互联网与云业务都要求IT基础设施能够快速部署以满足业务高速扩张的需求,也就是说可能在短期内需要大量的服务器上线。如何缩短服务器上架时间?京东云采用了微模块数据中心技术。

京东云华东数据中心内部署的微模块,采用地板下送风,并封闭冷通道

微模块数据中心,通常是将数十个机柜相对而立,封闭中间的冷通道,然后按预先设计的机柜位置整体部署,以缩短部署周期。

从上图可以看到,京东云微模块数据中心依旧采用地板下送风方式,这可能部署时间较早的缘故。实际上,在参观第二个机房模块的时候,我们发现京东云有更进一步的微模块技术,不再使用地板下送风方式,而是在微模块内集成了精密行间空调,冷冻水管直接进机房供给行间空调;同时微模块内集成电源列头柜。微模块顶部布线,底部垫高,用于铺设冷冻水供回水管道。

这样的好处在于,一是可以缩短机房建设速度,微模块内集成了空调与供电,机房建设好之后只需铺设冷冻水管道和主干电源线路,无需额外的施工;二是用现场拼装代替了现场施工,大大降低了项目的复杂程度,同时避免出错导致的重复施工;三是冷源(行间空调)离热源(服务器/网络设备)更近并可灵活增减数量,可以满足更高的功率密度。

对于京东而言,光有计算能力是远远不够的,还需要高性能的存储。在存储方面,京东云率先大规模使用了英特尔公司的Optane系列SSD产品。SSD是当代企业的共同选择,但对于每天要承载数千万乃至上亿次访问量的京东商城而言,只用SSD是远远不够的。普通的企业级SSD通常读写性能不均衡,且写性能相对较弱,还有全盘写入次数限制,并不能完全满足在线事务处理类应用(即OLTP,典型以数据库应用为代表)。为了提升性能,京东云采用了Optane,虽然也被称之为SSD,但Optane却使用的是全新的材质,拥有更好的、更均衡的读写性能,且更低的响应时间,无需担心寿命等优点。

供电与制冷:高可靠保证与绿色节能

建设数据中心的目的是为保证IT的持续安全稳定地运行,除了数据中心选址要尽量避开地震、火山等地理位置,以及建筑本身的避震避灾能力设计之外,供电与冷却系统设计成为关键。京东云数据中心采用一主一备两路市电+UPS供电系统设计。

京东云华东数据中心内的供电系统:变压器及配电柜。两排供电设备间的巡检通道有黄线警示,并铺设有绝缘地板

京东云华东数据中心具有专属的110KV变电站,其上一级来自两个不同的220KV变电站专线。在110KV变电站内设2台变压器,容量满足整个数据中心园区的最大用电量。当两台变压器任意一台检修或发生故障时,另一台完全满足园区内所有设备的正常用电需求。

UPS系统平常可以整流,而当遇到市电中断的情况下,可以提供不低于15分钟的供电能力,用以支撑柴发系统启动,直到其稳定运转到既定功率。京东云华东数据中心一期中部署了总计8台柴发并联,以N+1模式待命,以备当两路市电都故障情况下,为机房、冷站及照明系统供电。柴发油罐储油量在无外部支援情况下可满足发电机组超过12小时的正常稳定运行,在此期间,紧急供油协议启动并保证柴发系统能够不限时间运转。

柴发室内的一组4台柴油发电机,在建筑另一端则有另外一组4台柴发

冷却系统设计是自建数据中心的重中之重,因为数据中心冷却系统是IT持续稳定运行的关键因素之一,同时,一个优异的数据中心冷却系统还能带来直接的成本节省。衡量数据中心效率有一个关键指标——PUE,即数据中心的总能耗与用于IT的能耗之比,这个比值总是大于1的,越接近于1意味着其能效越好。

以京东云华东数据中心为例,数字中国万里行团队抵达宿迁正值“秋老虎”肆虐之际,室外气温约为34℃,据京东云数据显示,综合全年来看,华东数据中心一期的年均PUE低于1.3。这个PUE 1.3可简单理解为,每当包括服务器、存储与网络在内的IT设备消耗1度电,数据中心内其他如散热、照明等系统还要同时消耗0.3度电。而在这0.3度电中,绝大部分都用于制冷。这一值也低于原本设计的PUE 1.35,别小看这0.05,对于京东云这种超大规模云数据中心而言,以4.5万台服务器计算,每年可节省数百万元的电费支出。

京东云华东数据中心内的冷站,颜色分明的管道标识,蓝色与绿色分别为冷冻水供回水管道;黄色与红色为冷却水供回水管道

京东云华东数据中心冷站主要由4台700冷吨的离心式冷水机组以3+1形式构成,用于承担整个数据中心的制冷需求。市政补水系统及供回水管道均采用双路一主一备设计,以保证空调的持续稳定运行。为了预防两路水源与冷水机组同时不可用,后备蓄水池与蓄冷罐当然也必不可少。

京东云华东数据中心内的蓄冷罐,共计4个蓄冷罐,总计可容纳180立方米冷冻水

降低数据中心PUE不仅能够实现成本节省,还符合国家节能减排战略。降低PUE的实质在于减少冷却系统的能耗,冷却系统70%以上的能耗都用于冷水机组。所以实现PUE值降低最直接有效的手段就是尽量减少冷水机组的运行时间,而充分利用数据中心所在地的自然冷源。

京东云华东数据中心所在地宿迁,年均气温14.2摄氏度,无霜期较长,室外自然冷源条件充足,且室外设备被冻结故障的可能性小。所以京东云在冷冻水系统中增加了板式换热器(简称板换),与冷水机组并联。

在实际运行中,冷冻水系统在室外日平均温度持续5天以上低于10℃时,开启板换并关闭冷机,日平均温度持续5天以上高于10℃时,再启用冷机。并且,在传统的Free Cooling技术基础上,京东云增加了一套自主设计的气候环境采集控制系统,完全实现了制冷系统根据室内外环境温度、湿度、系统负荷大小、平滑连续的调节各组件运行状态,始终保持系统在最佳的效率区间。据京东云统计,全年可以”免费“使用自然冷源的时间超过180天,直接节约电费数百万元。

在尝到“甜头”之后,京东云华东数据中心一期中的“小三期”中开始实验间接蒸发冷却技术,相比于冷却水系统,间接蒸发冷却技术可直接使用自然冷空气进行换热,不仅节约电费,还节约水费,更好的成本节省。同时,相比于冷冻水系统复杂的管道铺设,间接蒸发冷却设备更符合模块化设计理念,能够加快数据中心的建设周期。

【作者: 曾智强 】