DoSTOR存储分析8月8日报道:如今的存储容量正以指数级数增长。 因此,越来越多的监管法规要求使得各组织必须将更多的数据储存更长的时间。由于需要备份的数据比以前多了很多,而且以后还会继续增加,各组织必须改变它们看待数据保护的方式。

更麻烦的是,这些数据中有很多都是多余的。以你自己的设备为例。 你可以将一个文件的多个不同版本都保存起来,每一个文件都有少许不同,不同版本的文件储存在不同的地方。当你将这个数量与你所在组织中的电脑数量相乘,你就会发现备份它们占用了大量的存储空间和网络带宽。

通过消除多余数据并确保数据归档尽可能地精简,你就可以将更多的数据保持更长的时间在线,而且成本也大大降低。虽然压缩技术有助于将数据量减少一半左右,但是它还不足以有效管理数据的爆炸增长问题。 只有重复数据删除技术可以做到这一点,它可以优化成本效率和存储环境的性能。正确使用重复数据删除可以提高数据存储的成本效率、性能和可缩放性。

如果你正在考虑使用重复数据删除技术,你也许就能将更多数据在网络上保持更长的时间,同时也不用增加存储的占地面积。为了让大多数人明白实行重复数据删除战略决策的意义,需要解决下面这些问题:

它在现有备份环境中将如何工作?

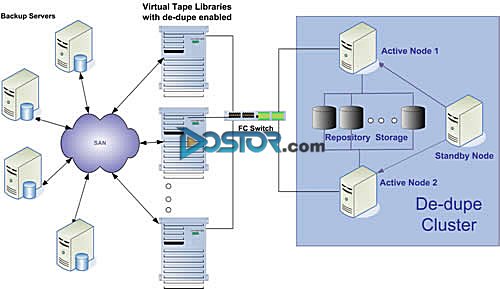

有些重复数据删除技术要求你完全改变你备份的方式。其他一些重复数据删除技术也会调整备份软件中的步骤和进程。 消除重复数据和改善备份质量的最简单、破坏性最小的方法是与虚拟磁带库(VTL)整合。 模仿你现有环境的VTL系统是并入你现有基础结构的最简单的方法。另外,带有重复数据删除功能的VTL系统还非常便于进行磁盘备份/恢复,而且集中于重复数据最大的来源:备份。

重复数据删除什么时候可以发生? 这将如何影响备份性能?

你应该考虑什么时候进行与备份进程有关的重复数据删除。有些解决方案是在数据进行备份的同时进行重复数据删除。 然而,今后这种方法会使备份性能降低60%,对备份系统构成严重影响。那些在备份工作完成之后再进行重复数据删除的解决方案可以解决这个问题,不会对备份性能构成任何影响。

一款重复数据删除解决方案应该不仅限于数据中心。它应该可以等效应用于分部办公室,并能够进行跨站全局式重复数据删除以降低成本、理顺管理任务以及将统一和灾难恢复所需的带宽减少到最低。

因此,一个理想的重复数据删除策略应该包括复制和多级重复数据删除,只要最小的带宽就可以判定那些远程数据是否存在在中央存储上。只有唯一保存在各处办公室的数据才应该被复制到中央存储和灾难恢复存储上。

我们的重复数据删除解决方案在规模上是否与我们的组织相匹配?

由于重复数据删除一般被用于长期数据存储,因此从容量和性能上来说,其可缩放性就成了一个重要因素。一款重复数据删除解决方案应该具备一个经济结构,不管是从最初的执行还是系统长期增长上来说,它的大小都应该是合适的。 例如,如下图所示,这个群集的解决方案可以随需求进行调整,满足容量增长的需求,同时也不会降低重复数据删除的效率和系统的性能。

重复数据删除的“流程”

考虑5年以上的增长预期情况。你希望保持有多少数据在线以便进行快速存取? 解决方案的性能和容量是否都可以进行调整以满足你的长期需求?

我们可以预计什么类型的重复数据删除比率?

你也许已经听说过50:1或者更高的重复数据删除比率。 没有哪个比率是对的或者错的。它取决于实际情况的需求。

重复数据删除比率实际上取决于若干变量,但是从根本上来说是取决于数据的固有特征和保护数据所用的政策。这是目前影响重复数据删除比率的最重要的因素。 数据存储空间越大,重复数据删除所需的时间就越长,重复数据删除比率就越大。

我们的数据存储安全性如何?

由于完成了重复数据删除操作的存储包括了更广泛的原始数据,因此这个解决方案应该能够保护那些数据。理想的重复数据删除解决方案应该包括数据镜像以免局部存储出错。 这款解决方案还应具备failover功能以免出现节点故障。即便一个群集中发生多个节点故障,贵公司也应该能够继续恢复数据并确保数据的全天24小时可用和业务的正常运行。

结论

由于商业应用需求和监管法规要求,存储数据量越来越大,重复数据删除技术已经成为一项重要的技术。 通过了解重复数据删除技术,你就可以逐步采用这种技术并显著降低存储需求和数据保护的成本,让你的公司尽快进入所谓的“备份天堂”。