近日,人工智能行业权威“跑分”榜单MLPerf训练榜出炉,各大AI芯片制造厂商和云厂商都在榜单中竞相角逐。MLPerf是目前国际上在人工智能领域最有影响力的行业基准测试组织之一,由图灵奖得主David Patterson联合谷歌和几所著名高校于2018年发起。

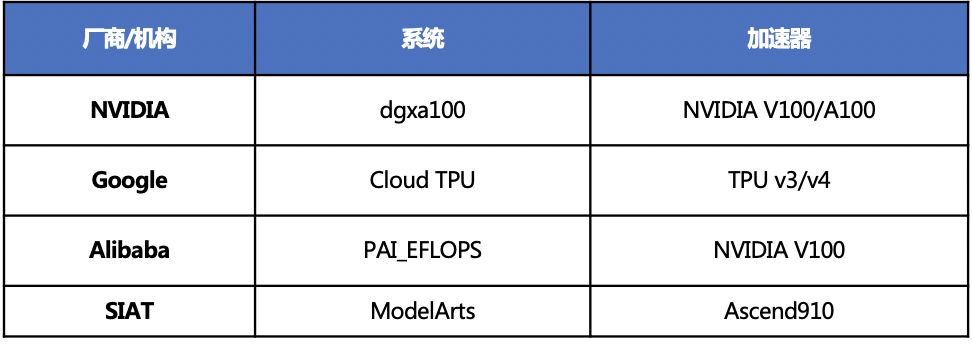

英伟达刚刚发布的A100 GPU和谷歌最新的TPUv4都在榜单中发布了详尽的性能数据,值得关注的是,本次训练榜单中首次出现了中国AI芯片和云平台的身影。中科院深圳先进技术研究所(简称“SIAT”)提供了华为云EI昇腾集群服务的测试成绩,实测成绩显示华为云EI昇腾集群服务性能超越了英伟达同类产品。

ResNet神经网络结构在2015年被提出,在ImageNet比赛classification任务上获得第一名,因为它“简单与实用”并存,其后很多方法都是在ResNet50或者ResNet101的基础上完成的,在AI检测、分割、识别等领域里得到广泛的应用。MLPerf 榜单的一个重要赛道就是基于ResNet50的机器学习任务,任务的训练速度越快则性能越强。

MLPerf ResNet50赛道有两个榜单:close和open,就是两种比拼方式。在close比拼方式下面,各大厂家基于同样的训练优化器和同样的神经网络结构,基于开源可用的深度学习框架来做训练比拼。

从测试数据看华为云EI昇腾集群服务既支持运行自研的MindSpore框架也支持运行开源的TensorFlow框架,并且在两种框架下均有优异的性能表现。从榜单中的成绩可以看出华为云EI昇腾集群服务的性能相比于英伟达和谷歌的丝毫不落下风,在同等规模的集群性能对比时,华为云EI昇腾集群服务的成绩要优于英伟达和谷歌。

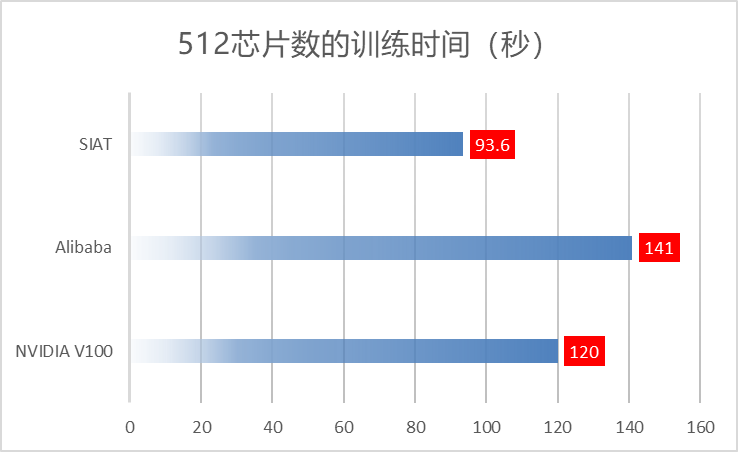

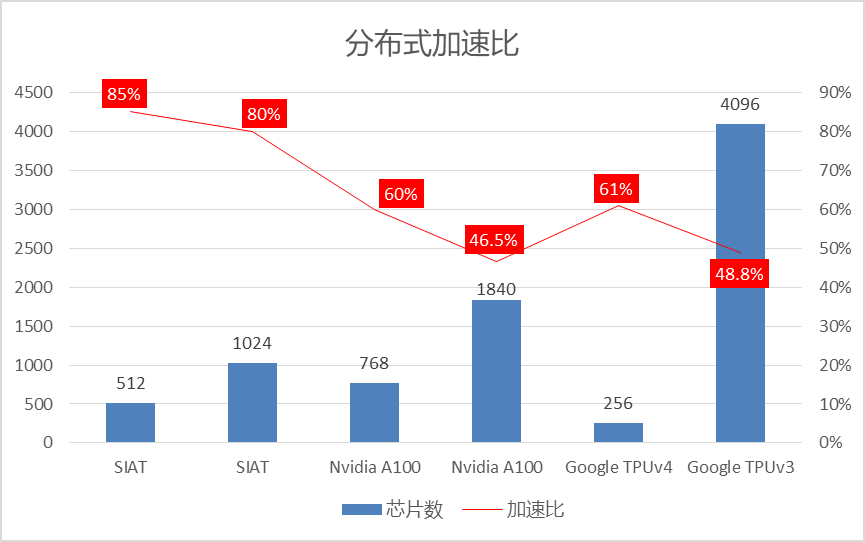

在512芯片的集群规模下,华为云EI昇腾集群服务成绩为93.6秒,优于NVIDIA V100的120秒。据了解,这主要得益于华为云EI昇腾集群服务及华为云ModelArts一站式AI开发管理平台在大规模分布式训练加速比上的优势,其在512和1024芯片下可达到80%以上的加速比,分布式加速比远超英伟达和谷歌,英伟达在768个A100的加速比为60%,1840个A100为46.5%左右,谷歌在4096(8192 core)个TPUv3下为48.8%,256个TPUv4(512 core)下为61%,华为云EI昇腾集群服务的加速比达到了英伟达和谷歌的1.3~1.7倍。

优秀的分布式加速比是大规模集群分布式训练的关键能力,也是促使用户选择使用大规模集群来加速AI业务的关键因素,华为云EI昇腾集群服务领先的分布式加速比能力将大幅降低用户的训练成本并加速其AI业务的开发效率。

而open榜单,更考验AI厂家的软硬件整体能力,因为open榜单没有软硬件的限制,只给任务,根据任务结果看性能。把两个榜单成绩放在一起看,华为云EI昇腾集群服务的软硬件结合的优化能力更加凸显,仅用1024芯片即跑出了32.4秒的成绩,超过英伟达1840个A100 GPU的45.6秒,堪与谷歌4096个TPUv3的28.2秒成绩相媲美。在另两组测试结果中ModelArts使用512芯片跑出46.8秒的成绩,超过英伟达1536个A100 GPU的成绩,ModelArts使用256芯片跑出83.4秒的成绩,超过谷歌256个TPUv4的109.2秒。

据了解,华为云ModelArts一站式AI开发管理平台在分布式加速比优化、大规模异构资源调度、高性能训练优化器、超参数自动优化以及神经网络模型优化等方面有较多的研究成果,而这些技术上的能力累积,也很好地体现在了本次的榜单成绩当中。