汶川强烈地震已过去了一百多天,灾备系统在恢复重建过程中所起到的关键作用备受瞩目,也使各界对其作用有了更直观和充分的认识。

为了有效减轻和抵御自然或其他突发灾难对企业生存和发展造成破坏,业界曾经要求区分业务连贯性(Business Continuity)和灾难恢复(Disaster Recovery),但随着技术的发展和研究不断深入,这两个概念已经逐渐融合,相关措施一般统为业务连贯性计划(BCP,Business Continuity Plan),国内则习惯性称之为“灾备计划”。

灾备计划的实施中,核心是数据。当前,企业的发展和成功越来越依赖于对数据信息的掌握和管理,数据已经成为企业最重要的财富;灾备系统的部署也正是为了在发生灾难的时候实现数据的恢复并维持相关应用。然而,在目前的技术条件下,建立完善的灾备系统还需要解决数据处理和安全中的一些让人头疼的问题。

1. 灾备系统的数据处理和安全问题

数据量急速增长

根据IDC 2008年3月的报告,2007年各种新增数据的总量(281 ExaByte)较上年增长了约75%,已经超过所有可用存储介质总容量(264 ExaByte)约6%,预计2011年数据总量将达到2006年的10倍。在企业中,除了一般应用的数据急速增长,各种新兴的信息化技术(如ERP、CRM、电子商务等等)在提高效率的同时,也同样会产生大量数据。

急速增长的数据量给灾备系统带来的最直观的问题是存储空间不足,需要购买更多的存储介质(磁带或磁盘)。随着系统总存储容量的增加,除了购买介质本身的支出外,设备部署空间、降温、电能消耗等等附带需求也随之迅速增长。

另一方面,数据量增长也给系统的处理能力带来了巨大压力。与存储介质不同,系统的处理能力(如CPU、I/O总线等)一般较难扩展,通常只能通过硬件整体升级完成,如果不能通过技术手段有效平抑数据量增长对系统处理能力的压力,系统可靠性将面临频繁硬件升级的严峻挑战。同时,对系统的投资也不能得到充分利用。

此外,灾备系统通常都需要异地部署。数据量的增加要求远程数据传输具有更高的带宽;由于传输带宽的限制,传输时间的延长可能会降低系统运行效率,甚至无法及时完成异地数据传输,造成灾备系统不能发挥功效。

保护敏感数据

完整的信息安全保护需要遵循AIC三原则,即对保护数据需要同时关注可用性(Availability)、完整性(Integrity)和机密性(Confidentiality)等三个关键特性。尽管不同的应用场景会有不同的要求,但在系统的设计时必须对这三个特性都予以足够的重视,而目前国内的灾备系统往往仅将视线主要集中在可用性上,对完整性和机密性都缺乏必要的关注。

部署灾备系统是为了能在灾难发生后及时恢复应用,保证相关业务的有效运行。因此数据有效性是系统设计中首要关注的内容,而与此同时,随着信息技术的应用越来越广泛,敏感数据被泄漏甚至篡改的风险也越来越大,一旦发生意外,企业将在激烈的市场竞争中受到沉重,甚至毁灭性的打击。

2. 现有解决方案及不足

为了应对上述问题,存储业界分别提出了相应的解决方案:数据缩减技术可以有效减少备份数据的总量;对敏感数据的严密保护可通过采用加密技术实现。

目前广泛应用的数据缩减技术主要有重复数据删除(Data De-duplication)和数据压缩(Data Compression)。重复数据删除技术通过删除存储过程中重复出现的数据块来降低数据总量,数据缩减比通常可达10:1到20:1,即应用重复数据删除技术后的总据量将减少到原始数据量的10%到5%;数据压缩技术通过对数据重新编码来降低其冗余度,从而实现数据量的减少,一般数据的压缩比约为2:1,即数据可被压缩到原大小的一半左右。这两种技术具有不同层面的针对性,并能够结合起来使用,从而实现更高的数据缩减比例。需要注意的是,如果同时应用重复数据删除和数据压缩技术,通常会先应用数据删除技术,然后再使用数据压缩技术,从而尽量减少对系统处理能力的占用。

为了对存储系统的数据进行有效保护,业界于今年初正式通过了IEEE 1619/1619.1存储安全标准。 IEEE1619采用一种新的加密算法模式XTS-AES,有效地解决了块导向存储设备(例如,磁盘驱动器)上的数据加密问题; IEEE 1619.1则主要是针对大的磁盘驱动器,可以采用CBC、GCM等多种AES加密和验证算法模式;其他如密钥管理等后续相关标准的制定也正在有序进行。

然而,尽管有这些方案能够分别应对灾备系统面临的大数据量和安全性问题,在实际的系统设计和部署中仍然存在一些麻烦,分散的技术实现会带来资源占用过多、系统运行效率低、复杂度太高、可靠性低等等各种问题,业界迫切地需要一种新的高集成度的总体解决方案,来全面解决所有的这些问题。

更为突出的问题是,数据保护所引入的加密处理将从根本上限制数据缩减技术的应用,这几种技术之间存在着根本的矛盾:重复数据删除和数据压缩技术的基础是大量数据中存在相似或相同的特性,而加密处理后数据中的相似或相同都将被完全破坏。

3. Hifn Express DR融合技术方案介绍

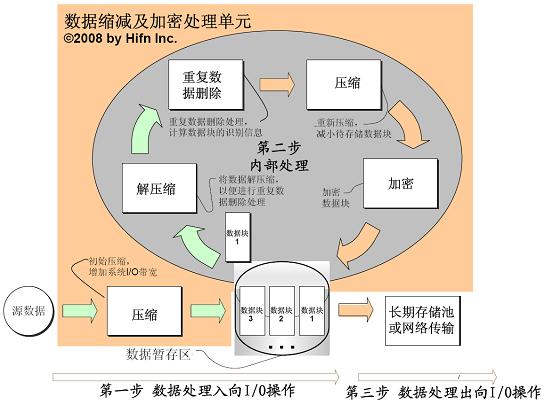

要想充分利用上述数据缩减和安全保护技术,构建完善的灾备系统,就必须仔细协调这几种处理。作为存储和网络创新的推动者,Hifn凭借对数据缩减和加密处理技术的深刻理解,以及对灾备系统存储应用的准确把握,提出了全新的Hifn Express DR解决方案,如图所示。

基于Hifn Express DR解决方案,数据将在被压缩后再提交进一步处理,以增加系统I/O带宽,从而使现有系统的硬件投资得到最大限度的利用和保护;在内部处理过程中,从I/O模块得到的源数据将首先被解压缩,然后使用特定的算法(一般使用SHA-1/2)计算出数据块的识别信息,以便进行重复数据删除处理;重复数据删除处理的元数据块将会被压缩,以进一步减少数据量。为了实现全面的数据保护,还可以对压缩后的数据块进行加密,加密算法和处理方式严格遵从IEEE 1619系列标准。整个处理过程都将由相关硬件处理单元自动完成,从而极大提高系统处理器和存储单元的工作效率。

通过对重复数据删除、数据压缩和加密技术的综合运用,基于该架构的新一代Hifn Express DR系列加速卡可以帮助客户将灾备系统的数据量减少到原始数据的5%以下,并实现数据的全面安全保护,其处理性能也将达到创纪录的1,600MB/s。