4月21日,欧盟公布了首个针对人工智能(AI)的立法框架,以及与会员国的协调规划,明确定义AI的风险,并将禁止或严格限制高风险AI应用,并且所有的远程生物辨识系统全都被欧盟列为高风险,只能在限定状况下使用。以便在欧盟境内加强AI的采用、投资与创新时,确保人员乃至企业的安全及基本权利。

欧盟执行副主席,Margrethe Vestager表示,对于AI,信任是必要的,借由这些规定,欧盟将带动制定新的全球规范,以确保AI值得信赖,它们将设定标准,在欧盟公民的安全与基本权利受到威胁时出手干预。

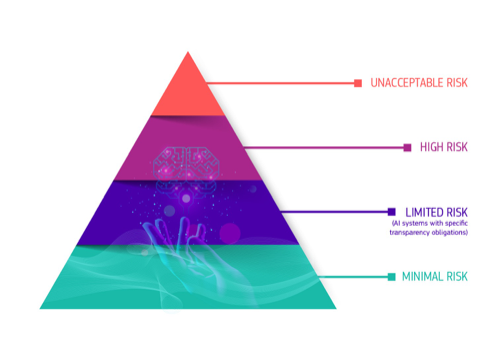

欧盟先是定义各种AI风险,从不可接受的风险(Unacceptable risk)、高风险(High-risk)、有限风险(Limited risk)到最小风险(Minimal risk)。其中,任何明显会威胁人身安全或人们生活与权利的AI系统将被绝对禁止,包含那些能够操纵人类行为以违反人类自由意志的AI系统或应用,例如那些以语音来鼓励未成年人进行危险行为的玩具,或是政府用来进行社会评分的系统。

图片来自网络

只要是被应用在重要架构的AI系统都被视为高风险,从重大的基础设施、教育/职业训练、产品的安全配件、招募/员工管理系统、必要的私人与公共服务、执法、移民/庇护/边境管制管理,以及司法与民主程序等。

在这些高风险领域嵌入AI系统时,都必须遵守严格的义务,包括经过适当的风险评估,拥有高品质的训练数据集,记录活动利于追踪,详细的文件,适当的人为监督,以及高度安全与精确性。

此外,所有远程的生物辨识系统,都被列为必须符合严格限制的高风险应用,原则上禁止执法机构于公共场合中使用相关系统,少数的例外则可能出现在找寻失踪儿童、避免紧急的恐怖威胁,或者是用来侦测与定位已确定或涉嫌重大刑事案件的犯人,在使用前必须获得司法机构或其它独立机构的授权,且必须限制使用时间。

有限风险的AI应用则具有透明化义务,例如使用者必须知道自己是与聊天机器人对话。最小风险的AI应用包括AI影音游戏或垃圾邮件过滤机制等,欧盟表示,绝大多数的AI系统都落在这个类别,而该类别亦允许人们自由使用,不会受到新法规的规范。

相关法案将会在欧洲议会及欧盟会员国采纳之后实施。