FCoE和融合增强型以太网(CEE)代表了网络技术的融合,而且是三个此前分别服务于数据、存储和服务器网络市场的厂商群体的共同方向。我最近调查了三个有关FCoE的问题,以了解业内对FCoE的普遍看法。今天,我们来看看来自Mellanox的回复。Mellanox是一家InfiniBand厂商,是InfiniBand市场的领导厂商,也是先行开发10-Gbit/sCEE融合网络技术的领导厂商。

FCoE是否将带来网络融合?Mellanox的回答是“是”,但是Mellanox认为不会只有一个技术,而是有两个技术可以融合:以太网和InfiniBand。Mellanox营销副总裁John Monson认为FCoE的设计就是为了带来融合,因为这样数据中心就可以在10-Gbit/s的光纤架构速度下支持大部分的应用程序。Monson预计像低延迟性RDMA(远程直接内存存取)这样的以太网功能将被加入到CEE。

但是Monson很快又指出一些基本情况在发生改变,并这将使得InfiniBand也将成为融合的光纤架构。例如,Mellanox认为每台服务器的处理器核数将增加至32个。持续密集型计算节点的使用也将解决从服务器到网络的瓶颈。在数据中心中,对于I/O密集型应用程序,比如大型数据库CRM(客户关系管理),或对延迟性非常敏感的金融类应用程序,只有InfiniBand才能够提供这些环境所需的融合网络性能。

我的观点:Mellanox是CEE网络开发的先锋;从RDMA技术来和产品的实际使用经验来说,Mellanox比许多其他厂商更具有优势和发言权。我也认为,比起10-Gbit/s以太网,InfiniBand可以提供4倍的带宽和10倍的低延迟性。如果经济形势并没有使得许多大型金融机构和企业削减预算的话,那么融合的InfiniBand光纤架构在企业级数据中心中将体现出优越的性能。通过融合的InfiniBand光纤架构,这些企业级数据中心可以部署集群,支持最大的和最业务密集型的应用程序,并利用IT来为他们的公司提供竞争性优势。

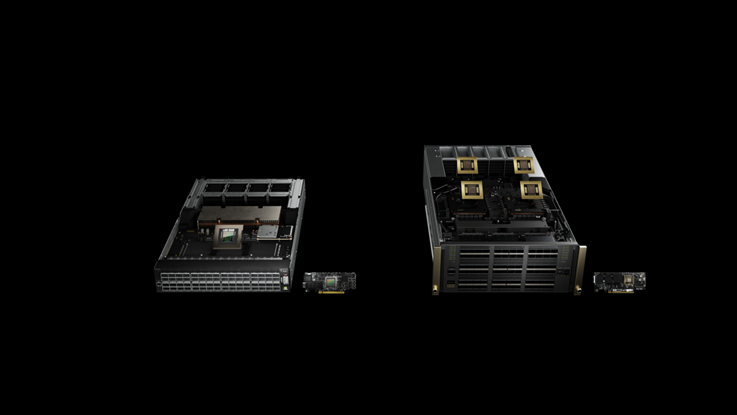

Mellanox已经做了哪些准备以应对未来向融合型光纤架构的过渡?Monson解释道该公司的产品可以同时支持InfiniBand和以太网上统一的数据、存储和服务器网络。我的观点是Mellanox还需要继续同企业级数据中心的主要用户协同合作,并利用该公司强大的OEM(贴牌生产)关系网络来走出高性能技术计算领域,并进入高性能业务计算领域。我认为企业级数据中心可以采用那些先进的融合光纤架构网关,以便为InfiniBand、以太网和光纤架构之间提供具有极低延迟性的桥接。Mellanox ConnectX和Brige X产品可以支持目前还不常见的数据中心桥接(Data Center Bridging)增强功能,比如优先级流控制,增强型传输和堵塞管理。

Mellanox预计融合存储网络要成为主流还需要一定时间。Monson补充道Mellanox预计大部分客户SAN(存储局域网)将采用光纤通道和iSCSI(互联网小型计算机系统接口)。

Monson同时还提醒我说增强型以太网仍然还处于标准制定过程中,而且该标准还要经过数年时间才能得到广泛实施,特别是在这个非常保守的存储市场上。Monson的回答有两点让我感到非常有兴趣:一是Mellanox有可能在主流的以太网市场上站稳脚跟,二是InfiniBand有可能成为第二个融合的光纤架构。InfiniBand技术具有很大的性能优势,在技术计算领域也有自己的一席之地,此外新的数百万IOPS(每秒输入/输出)的SSD(固态驱动器)和极度密集的多核服务器也需要有更快的连接性。依我看,InfiniBand将在融合网络中拥有一席之地,该技术将在高端HPC(高性能计算)细分市场和主流的企业数据中心市场间扮演一定角色。