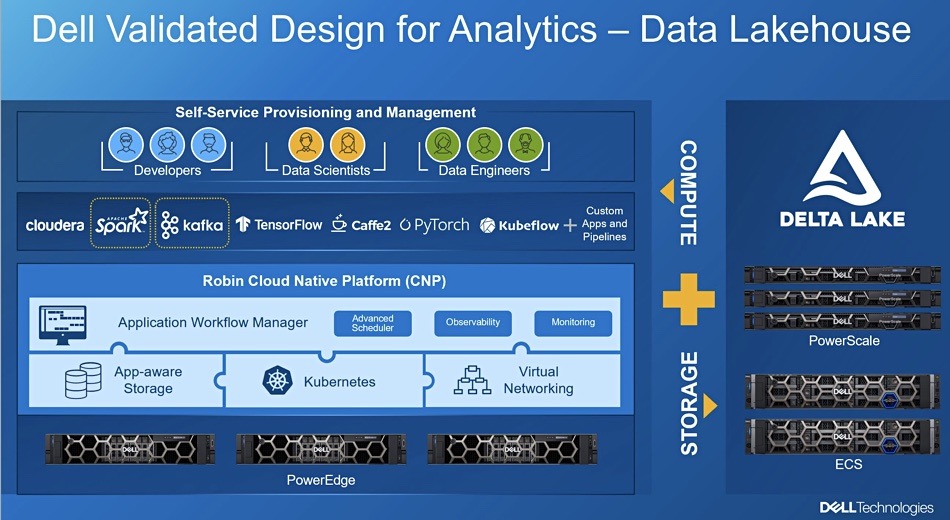

最近,外媒传出消息,说戴尔推出了一个整合了数据湖、数据仓库的参考架构,参考架构采用的是戴尔自家服务器、存储、网络硬件和来自第三方的软件,比如Databricks、Dremio、SingleStore还有Snowflake的软件。

戴尔设想的是一个单一的数据湖仓架构,有一个单一的、通用的底层存储,不用ETL就能将原始数据转换为适当的形式,然后就能在数据仓库里使用,看起来就好像在数据湖里有一个虚拟的数据仓库一样。

戴尔ISG解决方案营销总监Chhandomay Mandal在博客里说:“传统的数据管理系统,如数据仓库,几十年来一直用于存储结构化数据,并使其可用于分析。然而,数据仓库设计之初并不是为了处理越来越多的数据。”

他看到,许多企业都用了数据湖和数据仓库,先把数据存储在数据湖中,然后把数据复制到数据仓库里,使其更便于访问,但这么做会提高分析的复杂性和分析的成本。

他认为,企业需要一个平台来完成所有操作,戴尔经过验证的数据湖仓架构就是干这个的,它支持商业智能(BI)、分析、实时数据应用、数据科学和机器学习。

参考架构的硬件部分,利用了戴尔的PowerEdge服务器、PowerScale统一存储和ECS对象存储以及PowerSwitch交换机。

而软件组成部分中,包括Robin(被Rakuten收购了)的Kubernetes云原生平台,Databricks的开源项目Delta Lake,Delta Lake包括Apache Spark、Kafka。最近,戴尔还高调宣布了与Snowflake的合作,这也是数据湖仓架构的一个补充。

上图是戴尔的一张图,看起来还是比较复杂的。

很显然,这还不是一个现成的方案,用户在真正采购前,还需要进行大量仔细的调查和选择。

有意思的是,HPE也推出了一个类似的方案叫Ezmeral Unified Analytics,这个方案也同样采用了Databrick的开源软件Delta Lake提供的能力。

戴尔和HPE两大传统IT服务商争相转型:

一个是向订阅制的云化转型,HPE的叫Greenlake,戴尔的叫APEX;

一个是与软件服务提供商深入合作,提供整合的数据分析解决方案,戴尔的就是今天说的Data Lakehouse,HPE的就叫Ezmeral Unified Analytics;