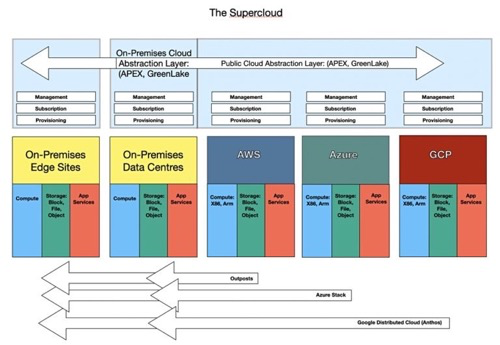

戴尔科技和HPE正在其本地软硬件系统上构建类似公有云的抽象层,并把它们转变为具有公有云配置和消费模式的订阅服务。但APEX (戴尔科技) 和GreenLake (HPE) 显然还可以扩展覆盖公有云服务范围,形成一个一体化的云管理、订阅和配置服务。

研究咨询公司Wikibon称,这个设想正在演变成“超级云”的概念。Wikibon在一份报告中指出,初期的云1.0时代,数据中心以基础设施和计算资源作为服务内容基本完成,然后是2.0时代即改变运营模式,如今运营模式开始延展到本地工作负载。也就是我们谈到的戴尔科技和HPE的做法。”

Blocks & Files对超级云的设想

分析师John Furrier认为,“基本上这是HPE和戴尔的Outposts。在某种程度上,HPE和戴尔在做的就是Outposts应该做的事。我们觉得很有趣,因为Outposts是2018年的一记警钟,也是对传统玩家的一击。他们最初以灵活的财务计划作为回应,但最终我们看到了真正的平台出现。”

Wikibon称,这是在建立云计算3.0时代,或者可以称之为超级云,是构建在云上的一个抽象层,提供跨本地、跨云再到远近边缘环境的统一体验。

我们认为这方面的驱动力来自两个主要的本地系统供应商——戴尔科技和HPE。他们拥有相当完整的软硬件堆栈,可在其上运行传统、虚拟机 (VM) 和容器化应用。通过VMware和Nutanix的努力,虚机可以在本地(私有云)和公有云上运行。采用Kubernetes作为标准,容器化应用也可以在私有云和公有云环境中运行。基于合适的公有云API接口,GreenLake和APEX能在这些环境之间传输应用并提供所需的计算、存储和网络资源。但由于数据重力,传输数据并不容易,这个待会儿再看。

支持混合和多云环境符合戴尔和HPE的利益,因为他们的企业客户正在采用这种模式。戴尔和HPE都可以通过支持保持相关性。他们最初通过为本地(现在的私有云)产品(云计算2.0时代)复制公有云操作模型然后不断升级实现这一点。再加上另一边,单一云服务也确实有锁定用户之嫌。

戴尔和HPE还可以通过在四个环境——私有云、AWS、Azure和谷歌云上提供全局文件和对象命名空间来帮助企业更好地管理非结构化数据。

现在就进入到了Hammerspace的地盘,并直接给独立存储和数据服务供应商出了难题。是与戴尔和HPE竞争还是合作?

戴尔和HPE需要考虑的因素之一是,他们拥有向客户提供的资源,这些资源有服务水平协议 (SLA)。除非这些供应商完全符合APEX和GreenLake的SLA,并且可以得到良好的维护和支持。

这样的考虑将使得这两个主要供应商倾向于有限的合作交易,将这些供应商的服务品牌划入APEX或GreenLake,因此可能会阻止HPE与DDN等企业进行类似合作,这将对独立供应商提出挑战。

关于数据重力

大型数据集无法快速传入/传出公有云,因为花费时间太长了,因此需要计算去处理数据。可以说,数据重力存在的唯一原因是网络太慢了。当10Gbit网络成为常态时,10TB数据集就有了重力。假设扣除开销后,10Gbit/s的速度只等同于1GB/s,然后移动10TB数据集需要10,000 秒,166.7 分钟或刚刚超过2小时46分钟。

现在随着网络速度的增加,数据重力的影响会减弱。如果我们达到800Gbit/s的网络速度,那么10TB传输将需要125秒,2.1分钟。但只要数据集继续增长,数据重力就会一直存在。

原文链接:https://blocksandfiles.com/2022/07/04/cloud-independent-vendor-exclusion/