ChatGPT的爆火引发了全球对于大语言模型(LLM)的关注,但应该注意到,尽管ChatGPT很强,但它所用的GPT-3.5和GPT-4模型都是不开源的。

换言之,现在只能通过网页或者API的方式调用OpenAI托管的大模型在线服务,其最大的问题就是容易造成隐私泄露,韩国某科技公司的员工已经证实了这一点。

所以,关注数据隐私的企业和组织需要的是能自行部署的大语言模型,包括部署在本地和部署在自己信赖的公有云上。

当然,这需要有开源可商用的大语言模型。

过去几个月以来,来自Meta的LLaMa是受关注度最高的开源大语言模型之一(但它是不可商用的),全球各地研究者也都开发了各种新模型,Hugging Face上的最强开源大语言模型的榜单也在不断刷新。

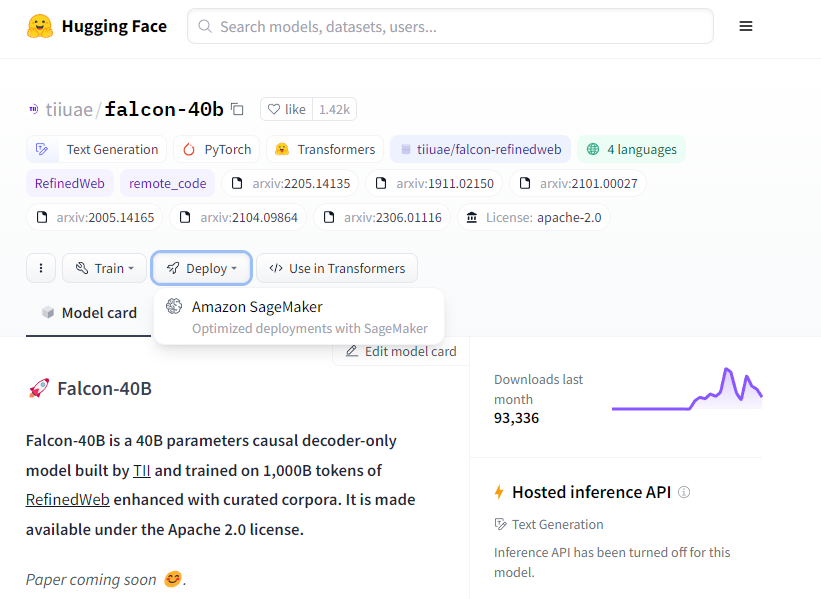

榜单最新冠军是来自技术创新研究院TII(Technology Innovation Institute)的Falcon-40B-instruct,它基于排名第三的Falcon-40B微调得来。

前者是指令优化的模型,类似ChatGPT,可以聊天对话和问答。后者是一个没有微调过的基础模型,可用于进一步训练或者微调,就像GPT-3.5和GPT-4那样。

Falcon-40B在Apache 2.0许可下提供,这是一个自由和开源的软件许可协议,允许用户自由地使用、修改和分发软件,支持在商业环境中使用。

所以,Falcon-40B是目前最强开源可商用的大语言模型。

技术创新研究院TII来自阿联酋首都阿布扎比,研究院最初七个专门的研究中心的研究内容就有人工智能相关领域。

TII 跨AI研究中心执行总监、代理首席AI研究员兼大语言模型项目负责人Ebtesam Almazrouei博士表示,“通过发布Falcon 40B开源模型,我们为研究员、企业和组织提供了在各个行业领域利用Falcon 40B强大能力的机会。

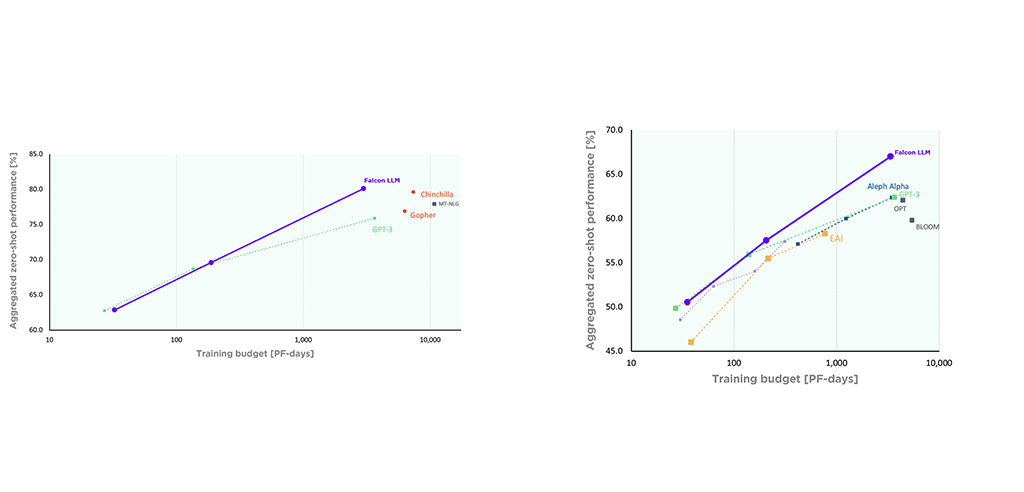

作为一个有40B(400亿)参数大大语言模型,它的表现超过了有650亿参数的LLaMA。

有如此表现大致原因有两方面,一个是训练数据质量更高,另一个是训练方法在不断优化的效果。

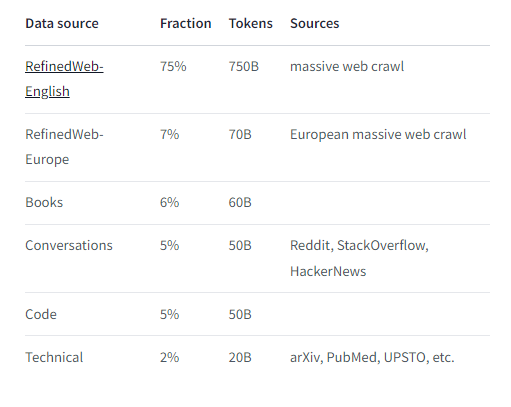

Falcon-40B基于一万亿个字符(token)训练而来,上图展示了Falcon-40B的训练数据构成,大部分是由技术创新研究院TII创建的数据集RefinedWeb,该数据集是从网络上抓取后整理而来的,任何人都可以基于ODC-By 1.0来使用和修改。

Falcon-40B在亚马逊云科技的Amazon SageMaker上完成的训练,使用了384块40GB显存的A100显卡,使用的是P4d实例。训练是从2022年12月开始的,历经了两个月的时间。

Falcon-40B的训练过程使用了优化的并行计算和内存管理策略,这使得它可以在大规模的硬件设备上进行训练,更高效地处理大型的数据集和模型。

Falcon-40B与来自DeepMind的Chinchilla和来自谷歌的PaLM-62B的性能相当,相比之下训练成本要低得多。据了解,训练Falcon-40B的计算量是GPT-3的 75%、Chinchilla的40%,占 PaLM-62B 的 80%。

除了400亿参数的Falcon 40B,同时发布的还有70亿参数的Falcon 7B。前者部署大概需要90GB显存的显卡,后者可降低使用门槛,需要大概15GB显存的显卡。

虽说后者15GB显存就可以运行,但目前大部分显卡还是只有8GB显存。目前较新的显卡,只有RTX 4090/RTX 4080以及RTX 3090Ti和RTX 3090可以满足要求,门槛还是很高。

当然,也可以不买显卡直接用。

从6月7日起,两个开源Falcon大语言模型也将在Amazon SageMaker JumpStart中可用。Amazon SageMaker JumpStar提供了包括Falcon-40B在内的多种预训练模型、内置算法和预构建的解决方案模板,可以帮助用户快速上手机器学习。

用户可以在Hugging Face网站上直接点击部署按钮即可部署在Amazon SageMaker上,可以选择SageMaker Python SDK、Amazon SageMaker JumpStart以及Cloudformation三种方式中的任意一种。

用户也可以在Amazon SageMaker Studio中轻点鼠标就可以部署和使用Falcon模型,或者通过SageMaker Python SDK以编程方式使用。

Amazon SageMaker是一个托管API集合,用于开发、训练、调优和托管机器学习(ML)模型,包括大语言模型。许多客户使用SageMaker处理其大语言模型工作负载,例如Stability AI, AI21 Labs和LG AI。

此外,Amazon SageMaker Training提供了具有用户自定义硬件配置和代码的计算集群。计算作业按运行次数计费,按秒分配任务,这意味着用户在未使用服务时无需为GPU资源付费。

Gartner在《2023 云 AI 开发者服务魔力象限》报告,亚马逊云科技被评为“领导者”,且在执行能力轴上排名最高,很多企业都选择用Amazon SageMaker来训练和推理机器学习模型。

现在,TII正在训练下一代Falcon大语言模型,将在Amazon SageMaker上扩展到3136个A100 GPU(392个ml.p4d实例,每个实例有8个A100)来做训练。