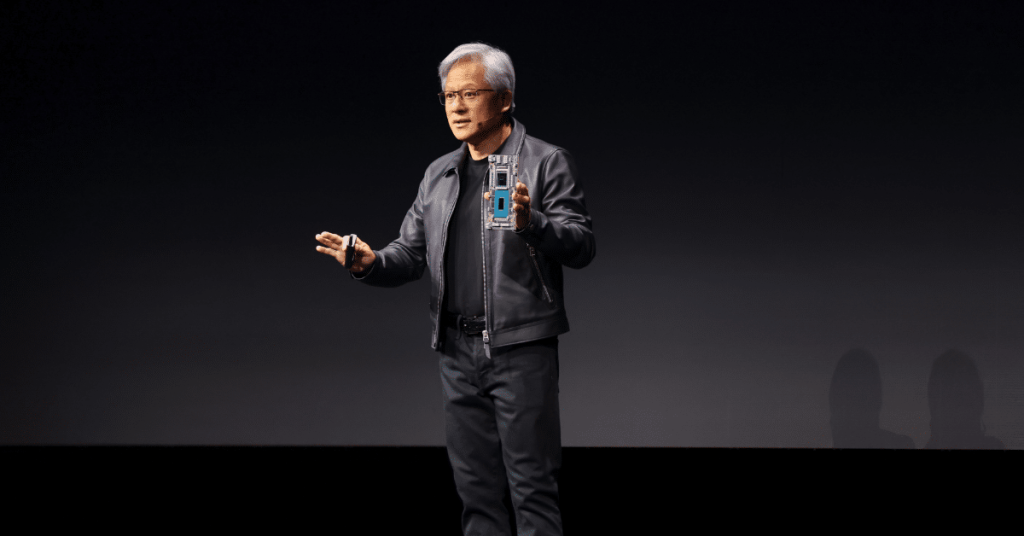

在生成式AI继续爆火之际,NVIDIA创始人兼首席执行官黄仁勋在计算机图形大会 SIGGRAPH亮相。

黄仁勋在SIGGRAPH现场表示,“生成式AI时代和AI的iPhone时刻已经到来”。

黄仁勋发布了GH200 Grace Hopper 超级芯片平台和一个名为NVIDIA AI Workbench的全新统一工作空间。

黄仁勋表示:“计算机图形学和 AI 密不可分,图形学需要 AI,AI 也需要图形学。”他解释说,AI 将在虚拟世界中学习技能,于此同时,AI 也可以用于创建虚拟世界。

AI和实时图形的基础

黄仁勋表示,“五年前在 SIGGRAPH 上,NVIDIA 将 AI 和实时光线追踪引入 GPU ,从此颠覆了计算机图形。不仅如此,在 NVIDIA 通过 AI 重塑计算机图形的同时,也致力于为 AI 重塑 GPU。”

这些努力换来的成果是越来越强大的系统。例如 NVIDIA HGX H100,它利用 8 个 GPU 和总共 1 万亿个晶体管来实现加速计算,超越基于CPU的系统 。

“这就是全球数据中心迅速转向加速计算的原因,”黄仁勋告诉观众。 “买得越多,省得越多。”

为了延续 AI 的发展势头,NVIDIA 打造了 Grace Hopper 超级芯片NVIDIA GH200,该芯片结合了 72 核 Grace CPU 和 Hopper GPU,并已于 5 月全面投产。

黄仁勋介绍说,已经投产的 NVIDIA GH200 将补充一个配备领先 HBM3e 内存的附加版本。

黄仁勋宣布推出新一代 GH200 Grace Hopper 超级芯片,它能够连接多个 GPU,以实现卓越的性能和易于扩展的服务器设计。

专为处理世界上复杂的生成式工作负载而构建的新平台,将提供多种配置,其中涵盖大型语言模型、推荐系统和矢量数据库等。

与当前一代产品相比,双配置的内存容量增加了 3.5 倍,带宽增加了 3 倍,包括一台具有 144 个 Arm Neoverse 核心、8 petaflops 的 AI 性能和 282 GB 最新 HBM3e 内存技术的单服务器。

领先的系统制造商预计将在 2024 年第二季度交付基于该平台的系统。

NVIDIA AI Workbench加速自定义生成式AI的应用

为了加快全球企业对自定义生成式AI的应用,黄仁勋发布了NVIDIA AI Workbench。

该平台为开发者提供了一个统一、易用的工作空间,使他们能够在个人电脑或工作站上快速创建、测试和微调生成式AI模型,然后将这些模型扩展到几乎所有数据中心、公有云或 NVIDIA DGX Cloud。

AI Workbench 大大降低了企业AI项目的门槛。开发者通过在本地系统上运行的简单界面,就可以使用自定义数据对来自 Hugging Face、GitHub 和 NGC 等常见资源库的模型进行微调,然后在多个平台上轻松共享。

虽然目前有成千上万的预训练模型可用,但使用许多现有的开源工具自定义这些模型依然十分困难且耗时。

黄仁勋表示:“为了使这种能力更加普及,我们必须使其能够在几乎任何地方运行。”

借助AI Workbench,开发者只需点击几下就能自定义和运行生成式AI。开发者可以将所有必要的企业级模型、框架、SDK 和库整合到一个统一的开发者工作空间中。

“有了 AI Workbench,任何人都可以做到这些。”黄仁勋说道。

包括戴尔科技、慧与、惠普、 Lambda、联想和超微在内的领先AI基础架构提供商正在使用AI Workbench,在本地设备等开发者想要工作的任何地点提供企业级生成式AI功能。

黄仁勋还宣布NVIDIA将与初创企业Hugging Face一起为数百万开发者提供生成式AI超级计算,帮助他们构建大型语言模型等高级AI应用。

开发者将能够使用Hugging Face 平台内的NVIDIA DGX Cloud AI 超级计算训练和调整高级 AI 模型。

黄仁勋表示,“这将是一项全新的服务,将世界上顶尖的AI社区与顶尖的训练和基础设施连接起来。”

在视频展示中,黄仁勋演示了 AI Workbench 和 ChatUSD 如何将这一切结合在一起:用户在 GeForce RTX 4090 笔记本电脑上启动项目,随着项目变得复杂,可以轻松地将项目扩展到工作站,亦或者是数据中心。

使用 Jupyter Notebook,用户可以训练模型使其生成 Toy Jensen 的太空图片。因为模型从未见过Toy Jensen,如果此时模型提供的结果不理想,用户可以使用 Toy Jensen 的八张图像微调模型,然后再次训练它以获得更准确的结果。

最终,通过 AI Workbench,可以将新模型部署到企业应用程序中。