Fabarta 是一家 AI 基础设施公司,通过探索和联结数据资源,帮助企业实现智能驱动的持续创新。

近日,Fabarta AI算法专家邱道明在2023中国数据与存储峰会-数据驱动业务创新应用论坛发表主题演讲,分享大语言模型在企业场景中的应用与实践,多模态大模型领域热点话题。邱道明老师在虚拟机、云原生、人工智能等方面具有丰富的实践经验,以下为演讲实录:

我想演讲的是《企业场景中大语言模型的应用实践探索》。分几部分来探讨:企业数据的演进、大语言模型相关概念、大语言模型企业场景应用的问题、Fabarta产品和解决方案、大语言模型企业场景应用案例。

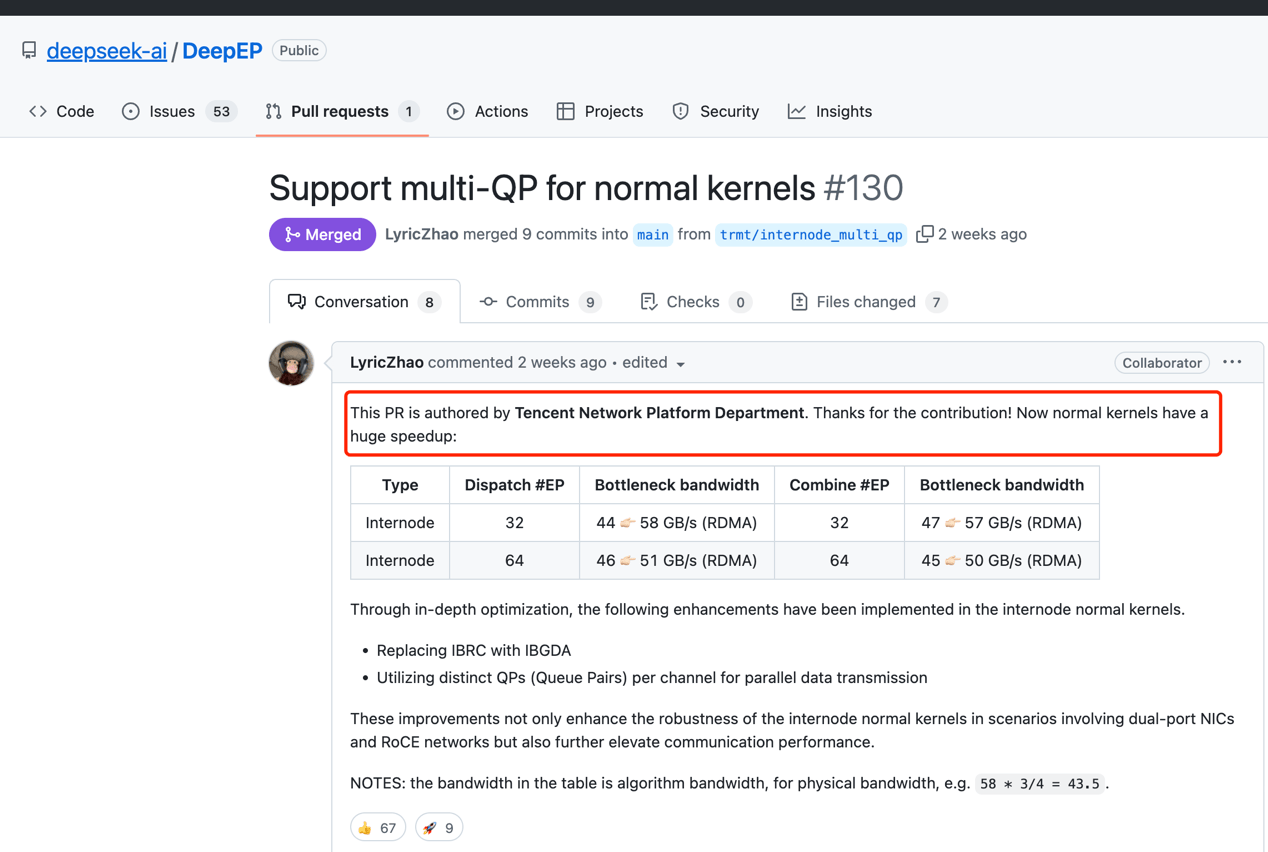

这张图中总结过去几十年企业数据相关的技术,最早技术出现在文件系统,60年代开始出现数据库,70年代出现关系数据库,80年代出现数据仓库的概念,90年代出现个人电脑的时代,2000年是互联网火爆,所以当时出现云计算和大数据。2010年移动互联网的兴起,当时也出现数据服务的概念和云原生和分布式流处理,这些都非常的热门。2020年之后是分布式图和向量,应该是比较热的方向。

这张图描述今后几年数据发展的趋势,来源于IDC预测。蓝色表示结构化的数据总量,单位是EB,紫色是非结构化数据的总量,所以从这个图中可以看到今后几年全球数据总量年增长率在21%左右,这个远超过GDP的总量。

在结构的总量中,90%都是非结构化的数据,比如说文档、图片、语音、视频等等。在这里面去年中国数据产量,大概在全球居于第二位,而且预测相关的增长率与全球增长率也在20%多。对于企业来说,我们现在有海量而且多模态数据的需求。

我们再看目前人工智能相关的概念,这张图中是人工智能将近70年的发展历程。1956年人工智能的概念被提出后,当时迅速走向一个高峰,大家认为技术能够解决所有人类的问题,其实也出现多层神经网络的架构。但是过了十几年发现,计算机、人工智能的能力非常弱,可能只能解决很简单的问题,所以当时人工智能遭遇到第一次的寒冬。

80年代确实能够帮助解决一些问题,包括日本推出一个计划,相当计算像人一样推理计算,能够解决生活的很多问题。但是过了几年之后,人工智能的进展还是非常的缓慢,包括五代机后来计划也是失败,所以人工智能到第二次的寒冬。80年代如果有人要去读人工智能或者神经网络,都会被人家笑话的,觉得这条路遥遥无期,或者没有什么前途。

后来2000年之后随着互联网的发展,包括2016年阿尔法狗战胜人类围棋冠军,特别是去年GPT的出现,使得人工智能大模型达到前所未有的高峰,为什么会出现这种情况?

一是数据出现爆发式的增长,互联网和物联网高速发展,互联网积累大量的数据。

二是算力的增长,我们采用GPU高度并行的架构。

三是算法上的突破,包括深度学习算法的突破,所以2019年研究深度学习算法的专家获得当时的图灵奖。

我们觉得从数据到算力和算法的高速增长,所以导致这十几年来人工智能的高速发展。大语言模型是自回归的深度学习算法,经过海量数据训练能够识别和生成文本和内容。它基本的原理就是根据前面窜入到后面的token,它有重要的属性是规模法则,它有几种说法,这是相对比较认可的说法,它认为大语言模型的能力表现是关于它模型的参数规模和训练数据集规模的可预测函数,而且没有上限的限制。

通俗来讲,模型的参数规模越大,那么它需要训练的数据集数量规模也就会越大,而且这样会导致模型的表现就会更好。当模型规模超过一定的阈值就会出现智能涌现的现象,有一些小模型中没有大模型中突然出现,所以右边的图是这几年参数模型规模的情况,所以在去年是1000多亿,GPT4大概是1万多亿,明年据说到10万亿的规模。

它的训练和推理一般会分为三个阶段,预训练是用海量的数据,大量的GPU运行四五个月得到基础的模型,以及用微调使用人工标注的高质量问答进行训练。人类反馈的强化学习用对模型的很多问答进行打分声称奖励的模型,用强化学习方式微调大模型,最后得到自己的模型。

推理阶段吞吐量是关键的指标,可以用优化的手段进行优化,一个是智能体希望智能系统自主的使用工具完成人交给他的任务,以及多模态理解和生成图片、视频、语音的内容,这不仅仅是文生图,也要图生文。

AGI通用人工智能,把它定义为绝大多数有经济价值的任务上能够超越人类的高度自治系统,比如说开车就有经济价值,而且要在绝大多数上超越人类。AGI是人类最终极的目标之一,而且我们一直觉得是遥遥无期,根本不知道到底往哪一个方向去做,这两年大模型突破能使得人们发现好像这是一条通往AGI的一条路,所以有些人可能说过十年或者二十年。而且一旦这个任务达到这个状态的话,可能会对人类的伦理产生根本性的动摇,比如说人类并不是地球上最聪明的物种。

我们碰到的实际问题,包括大模型训练当中达到的截至到今年的四月份,以及模型回答问题的时候会胡编乱造,如果像不懂的人会被它欺骗。

不可解释性,模型中的参数太多,无法从数学上对它进行证明。比如哪一部分的神经原在起着哪部分的作用,以及数学逻辑推理能力弱。

我们是一家AI基础设施公司,通过探索和连接数据资源,助力企业实现智能驱动创新。产品矩阵称为是一体两翼的,底下是多模态的智能引擎,包括图的引擎、图数引擎和向量引擎,以及AI模型的推理加速和训练,左边是多模态的数据平台,通过数据治理和盘点的功能,使得传统的数据治理向智能的数据资产管理迈进。

右边是企业的智能分析平台,包括低代码分析平台,把低代码的方式暴露给客户应用端,以及大模型工作平台进行调优。

整体上来说,左边编制品牌主要是把数据进入到引擎当中去,由引擎进行推理。右边是以智能分析平台,我们也是一个创业公司,也是纯自主研发的产品系统,我们也和国产进行绑定。

刚才说的大模型,在产品解决方案上做了一些解决,当然无法从根据上解决问题,我们通过把图中的确定知识补充和校大模型,能够做约束,比如说数据时效的问题,把本地支持装数据库当中,让大模型从本地支持中产生价值,利用图的能力做更好的召回、校验、补充。

几个实际的应用案例。制造业方面项目背景是某一个大型的信息制造企业的管理系统,核心场景是生产设备报修工单的流转,以前在生产线上的设备一旦坏了,工人要打电话或者发短信给服务中心,说这个设备怎么坏了?维修的主管就会分派维修工人过去察看分析,解决之后这个问题就解决了。

功能报帐非常的烦琐,维修人员的经验和故障匹配很困难,以及故障的现象无法判定,维修人员经验无法提供支持。我们的解决方案通过大语言模型,开发一个手机的APP,功能把语言的方式汇报故障,我们通过大语言的模型理解语言数据,引导用户一步步进行信息的输入,形成一个结构化的工单,作为资产沉淀下来。

根据工单的信息推荐相应的维修工,以及相应操作的流程。当维修好了之后,他的维修工可以通过语音的方式把维修的总结发送过来,通过大语言模型进行结构化,并且形成新的维修标准操作流程。对于设备工单进行建模和分析异常,对今后的设备整改提出建议。

经过我们用了这些方案之后,人工填写效率提升70%,减少人工的成本,通过自动对话的系统使维修工实时得到我们的服务。

第二个案例是金融业,这个客户是合规部门,合规部门其实是非常核心的部分,他们的员工需要学习上万个法规,比如说刑法、商业银行法,他们自己银行的内部也会制定规则,他们需要把内规和外规对立匹配,避免有不一致的情况。

希望能够在关联到行政处罚和司法判定,我们的解决方案是通过大语言模型构建生成相关法规标签,以标签为中心构建法规知识图谱,存在图数据库当中。把法规的条款,存在向量的数据库当中,我们使用多种的算法,结合图中关系构建精准合规的领导。

对内外的匹配,通过向量的比较以及大的语言模型,来很好的进行内外部的匹配,经过我们的解决方案,相应合规问答的准确性比以前老的至少提升80%以上,员工积极性也显著的提升,同时减少银行合规的风险。

第三个案例IT业案例,以我们自己作为一个背景,员工需要花大量的时间阅读自己内部文档,所以我们希望有一个智能系统能够检索自己的内容,而且给员工提供回答,我们的解决方案首先把私有的数据,文档的关系图和内部的组织架构图转换并且存储数据库,把技术文档存入到向量数据库,把代码也要相应的提交也存储向量库,机制能够自主的去查询图和向量数据库,这里面有好几个向量库,所以你要自主的生成查询计划去查询。

亮点是支持多种格式,通过这一套系统把员工技术能力有很好的提升,员工的满意度也会提高,我们把它叫做Arc42企业智能助手,我想演示一下和向量的融合能够避免一些问题,比如说问一个问题2.0数据库是否有切换的功能?它的回答是在当中做单纯的向量召回会回答说是的,我们支持相关的功能。为什么呢?代码的提交当中有关键字,把这个提交给大模型产生幻觉。

这里是查询计划,首先判断是宏观查询,从代码库当中照相馆的代码提交。也同文档库当中去找区块链相关的文档,而且确实也发现了,发现写作文档的人是销售部门的员工,我们再把这两个结果汇总一下,得出来一个结论说在研发部门中没有区块链相关的设计文档,虽然有区块链相关的代码提交。我们把这个信息提交给大模型,会说对不起我们并没有区块链的模型,这里面进行图文向量融合查询,得到避免大模型幻觉。

总结一下,大语言模型是颠覆性技术,正在快速发展,在企业场景中有极大的应用空间。Fabarta公司提供图和向量融合的AI基础设施,帮助企业更好的实现大语言模型的应用。