AI和HPC技术的发展,推动了基因组测序、地震预测等领域的进步,改善了人类生活。

然而,其技术背后都需要处理大量数据并使用复杂的算法。这些对于计算能力都提出了非常高的要求。

为了应对高并行和高复杂的工作负载。英伟达即将在2024年第二季度发布NVIDIA H200 Tensor Core GPU,它将帮助企业优化AI和HPC工作负载。

常见的AI工作负载其实包括数据收集与预处理,模型的选择、训练、测试与优化,模型部署和推理,其中,GPU在模型训练、调优和推理环节都有关键作用。

GPU的并行能力更强,适合处理大量重复的相对简单(相对CPU而言的简单运算)的数学运算,这些数学运算刚好是开发AI模型所需要的能力。

英伟达的H200有更强的计算能力和更强的高带宽内存,它能进一步降低训练和运行AI模型所需的时间,从而提高效率和生产力。

H100大幅领先于A100,而H200大幅领先于H100,即将于第二季度发布的H200备受瞩目。H200使用了HBM3e内存技术,提供141 GB的显存容量和4.8 TB每秒的超高带宽速度。

与A100芯片相比,H200的显存容量翻倍,带宽也提高了2.4倍。与H100相比,H200 GPU的带宽增加了1.4倍。

总之,H200在性能和能效方面都有显著提升。

AI推理性能上的提升

H200将会把AI推理的性能提升到一个新的高度。所谓AI推理,就是让模型用自己的知识来处理此前没有见过的数据,基于特定上下文输入来产生相关的输出。

我们知道,GPT-3达到了1750亿参数,Llama2也有最多700亿参数。随着参数规模的不断增长,模型对更强硬件的需求也更迫切。

我们看到,H200对GPT-3 175B模型进行基准测试时,在性能方面的表现是A100的18倍。相比之下,H100的性能是A100的11倍。

英伟达的GPU芯片配备了新的内置大型语言模型——TensorRT-LLM,这是一个工具包,在对GPT-3和Llama 2这样的大型语言模型进行推理时,它能提供一些优化。

当运行Llama-70B时,新的H200在吞吐量性能方面比使用旧版本TensorRT-LLM的H100芯片实现了1.9倍的提升。

而在推理Llama 2-13B模型时,H200的吞吐性能达到了H100的1.4倍。

Stability AI,就是开发了Stable Diffusion的那家公司,通过使用英伟达的TensorRT显著提高了文生图的性能。

通过在H100芯片上使用转换后的ONNX模型,性能显著提升,仅在1.47秒内就能生成高清图片,实现了性能翻倍。

下图总结了各个芯片在用Stable Diffusion XL 1.0生成图片时候的吞吐性能,Stable Diffusion XL 1.0是Stability AI最新的文生图大模型。

这里生成的图片都是1024×1024的尺寸,另外,生成时都选择了30 Steps的配置,步数越多,对算力要求也就更大。

通过在芯片上使用TensorRT库,Stable Diffusion XL 1.0在使用H100芯片时,获得了70%的性能提升。

而如果使用H200,配合新一代的TensorRT,Stable Diffusion XL 1.0的性能必然还会实现进一步的提升。

高性能计算方面的提升

要面向大数据集来进行复杂运算,经常需要用到HPC的能力。MILC项目是研究亚原子物理中的强相互作用理论的,是典型的HPC负载,H200在MILC项目中比双路x86服务器的性能高了110倍。

H200在HPC方面的性能整体比A100芯片高出100%,而H100相较于A100芯片提升了大概70%。

能效方面的提升

H200 在能源效率和总拥有成本(TCO)方面达到了新的水平。尽管H200带来了巨大的性能提升,但其功耗与前一代产品H100相同。

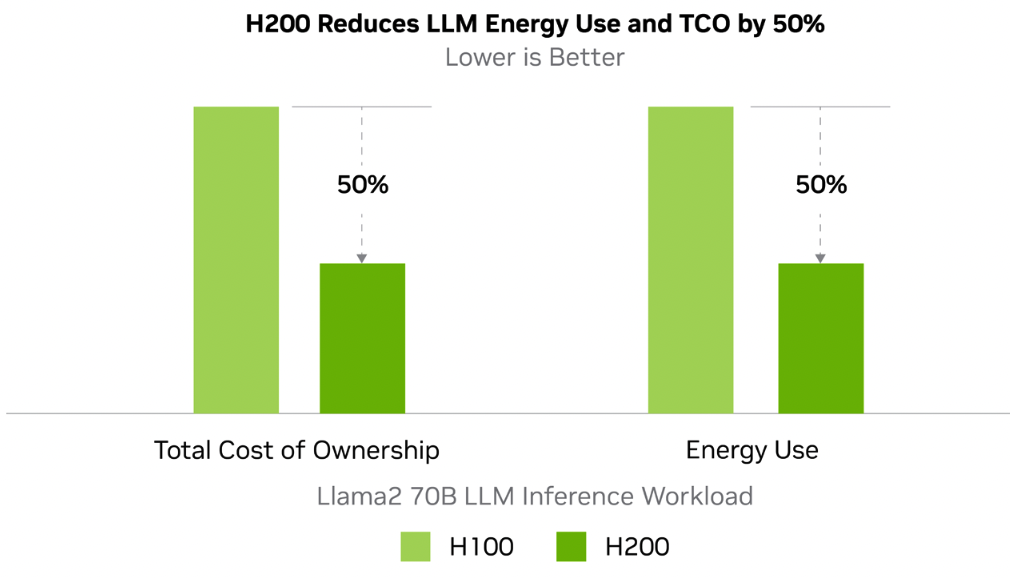

与H100相比,H200 在能源使用效率和TCO效率方面提高了50%。这意味着H200不仅性能更高,能耗不变,而且实现了更高的成本效益。

H200在能效方面的提升主要得益于优化的Hopper架构,当然,这也是性能提升的主要原因之一。

全新的H200将进一步提高AI和HPC方面的性能表现,帮助企业更轻松地创建数据密集型应用。

美中不足的是,H200的成本可能会更高。但是,成本高是老黄的问题吗?