在生成式AI的技术浪潮下,算力不足的问题非常突出,高性能的数据中心级GPU成了备受追捧的计算资源。然而,英特尔更希望让用户看到至强可扩展处理器在生成式AI方面的就业前景,为用户提供除了GPU以外的另一个方案。

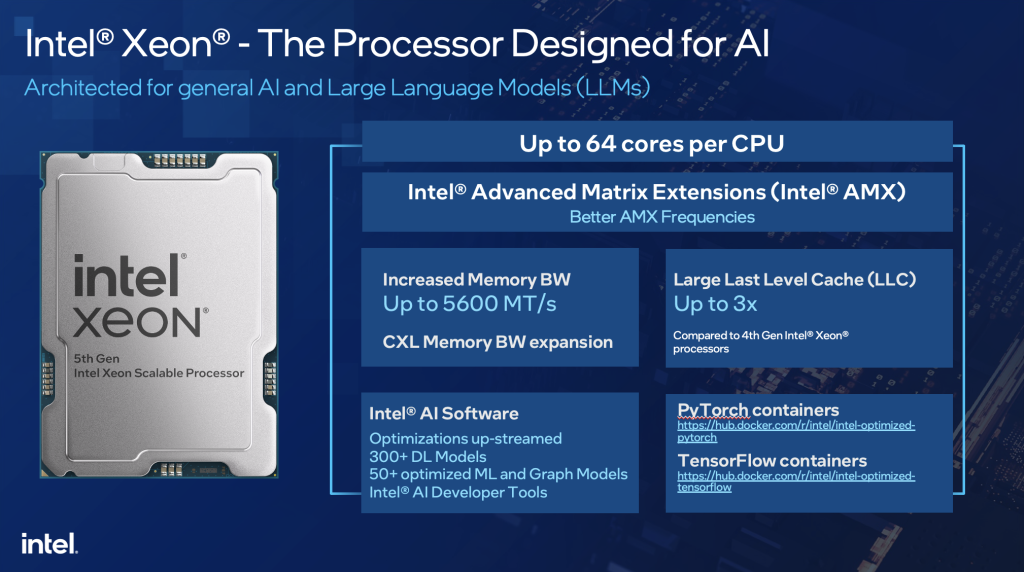

2023年12月,英特尔发布第五代英特尔至强可扩展处理器,对微处理器架构进行优化,从四个芯片拼接方案改成了两个芯片拼接,访问延迟大幅减少。最大核心数提高到了64核,内存带宽也提高到了5600MT/s,三级缓存提升了将近3倍,这都是硬件层面上的主要创新。

虽然第四代和第五代都支持AMX和AVX-512指令集,但第五代英特尔至强可扩展处理器,因为硬件规格的提升,包括内存带宽和三级缓存容量的提升,最后让AI推理性能显著提高了42%,使得它成为更适合AI的服务器处理器。

除了硬件的提升,英特尔人数众多的软件团队还在x86架构上进行持续优化。英特尔对开源软件的支持素来属于行业模范,对于TensorFlow、PyTorch这类主流开源机器学习框架的支持自不必说。

英特尔市场营销集团副总裁、中国区数据中心销售总经理兼中国区运营商销售总经理庄秉翰表示,英特尔在软件生态上有很大投入,随着第五代至强的发布,英特尔向社区上传了300多个深度学习模型,支持50多个面向第五代至强优化过的模型,这些都可以供开发者调用。

此外,自家推出的OpenVINO可用于优化深度学习推理在各种英特尔硬件,包括CPU、GPU、FPGA等芯片上的性能表现。当然,想要让CPU来跑大语言模型就不得不提oneDNN和oneCCL。

oneDNN(oneAPI Deep Neural Network Library)是一个开源的跨平台性能库,专为深度学习应用而设计。oneDNN简化了开发者优化深度学习应用的过程,同时最大化利用英特尔硬件的计算能力,提升深度学习模型在这些平台上的性能。

oneCCL(oneAPI Collective Communications Library)是专为分布式和并行计算设计的一个库,它能使计算节点间的数据传输和同步变得简单高效,是HPC和大规模深度学习场景中不可或缺的组件,它使得基于CPU的大规模分布式推理成为可能。

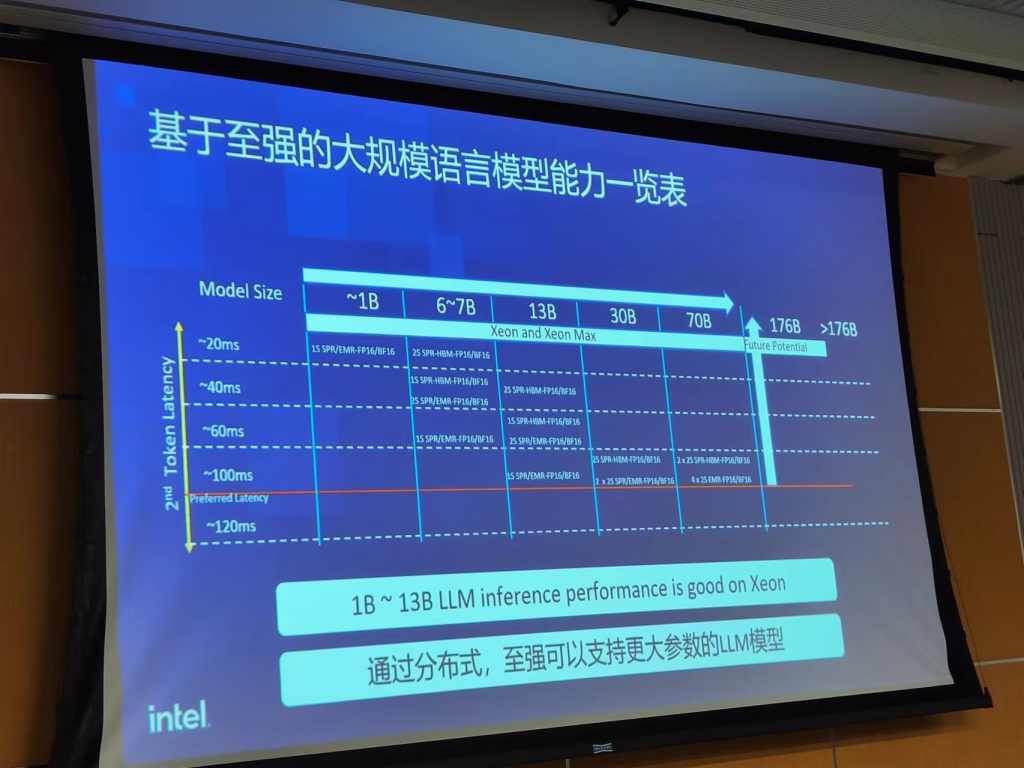

谈到大语言模型的推理就得介绍一个叫Token Latency的参数,Token Latency指的是从输入第一个token到模型生成第一个token的延迟。它是衡量大模型响应速度的指标,也是考验CPU推理性能的指标。

从英特尔专家的介绍中了解到,100ms是客户业务的阈值,大于100ms时业务体验会比较差。所以,只要至强处理器能把大模型的Token Latency控制在100ms以下,那就能用来推理大模型。

从英特尔公布的测试数据来看,当使用一台基于第四代或者第五代至强的服务器来推理10亿参数模型时,Token Latency能控制在20ms以下。同样是这台服务器,如果用来推理60-70亿参数模型时,延迟就提高到了60ms左右,推理130亿参数就达到了100ms。

如果想要推理300亿参数的模型,同时想把延时控制在100ms以下的话,就需要两台基于第四代或者第五代至强的两路服务器。当然,如果选择至强Max的方案,则只需要一台两路服务器即可。看来,在推理性能上,一台至强Max大概等于两台至强可扩展处理器的方案。

最后,英特尔至强在推理700亿参数模型时,想要控制在100ms以下,就需两台基于至强Max的两路服务器,或者4台基于至强可扩展处理器的两路服务器。英特尔给出的结论显示,英特尔至强在推理130亿参数以下的大模型时,性能表现良好。

实际落地中,英特尔和百度一起,使用四台基于第五代英特尔至强可扩展处理器的双路服务器,支持了70B参数的模型,服务器间的互连采用了oneCCL和RDMA网络,并将延迟可控制在了100ms以内。实际操作证明了GPU并不是大模型推理的唯一选择,CPU也行。

英特尔专家表示,对于业务仍处于起步阶段的公司而言,可以在综合考虑各种方案的表现,方案的成本,考虑资源是否能够充分利用的前提下,再做出采购选择。此时,用户可以发现,使用至强做推理是一更很稳妥的选择。

在实际落地中,百度云上使用四台基于第五代英特尔至强的云主机来推理Llama2 70B时,可以达到87.5ms的推理延迟。百度也表示,考虑部署和运维等成本,一般企业导入基于至强的生成式AI服务,能大幅降低初期投入成本。

从庄秉翰的介绍中了解到,英特尔有很多OEM伙伴都推出了基于第五代英特尔至强可扩展处理器的一体机,用来推理7B、13B,甚至34B的大模型,这些通用处理器都支持AMX、AVX-512指令集,可以用来满足推理大模型的需求。