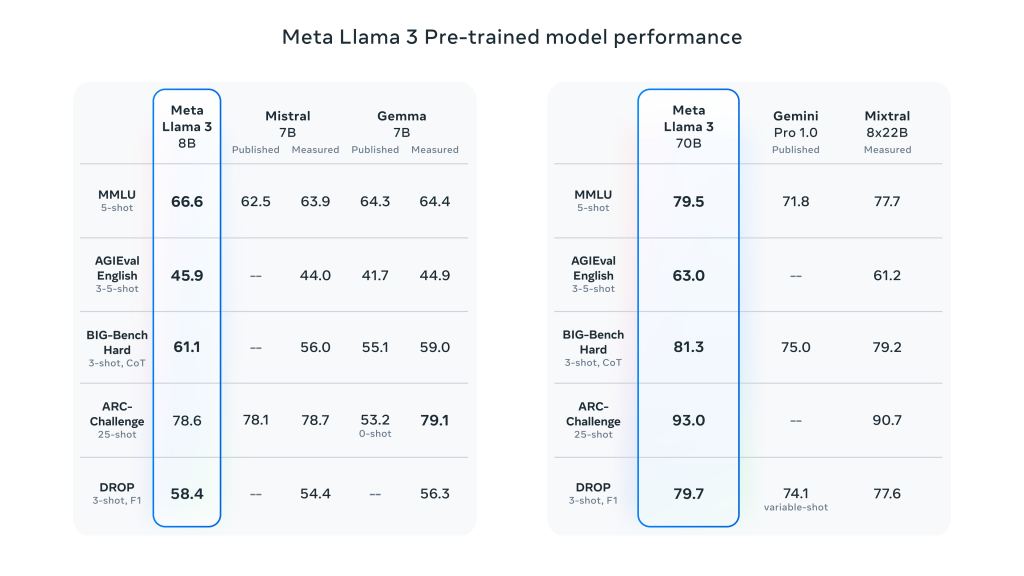

美国当地时间4月18日,Meta发布了备受期待的开源大语言模型Llama3,Llama3提供了8B和70B参数两个尺寸的模型,未来还会发布400B的版本。

Meta在博客中提到,得益于训练技术的改进,在同等参数规模的模型中,Llama3 8B和70B的模型都是最强的。

如上图所示,Llama3 70B的表现甚至超越了谷歌的Gemini Pro1.5以及Anthropic的Claude 3 Sonnet。

Llama3显著降低了错误拒绝率,提高了模型的对齐性,增加了模型响应的多样性。此外,它在逻辑推理、代码生成和指令跟随等方面的能力也大幅提升,整体的可控性也更强。

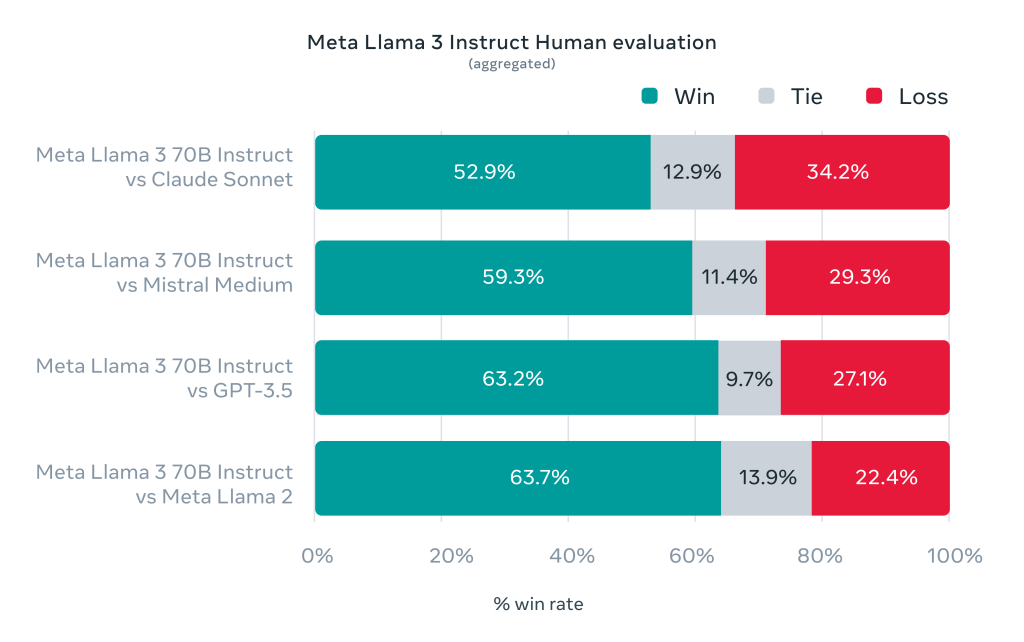

除了常规的跑分以外,这次Meta还开发了一个更接近真实体验的测试。

Meta的测试中整理了1800个提示词,把这些提示词给到Meta3,Claude Sonnet,Mistral Medium和GPT-3.5这些模型,然后由人来评估这些回答的结果。

结果显示,Llama3 70B指令优化版比Claude Sonnet、Mistral Medium、OpenIA GPT-3.5以及Llama2都要更强一些。

看得出来,Llama3还是很强的,那么,要如何才能体验到这款更强的新模型呢?

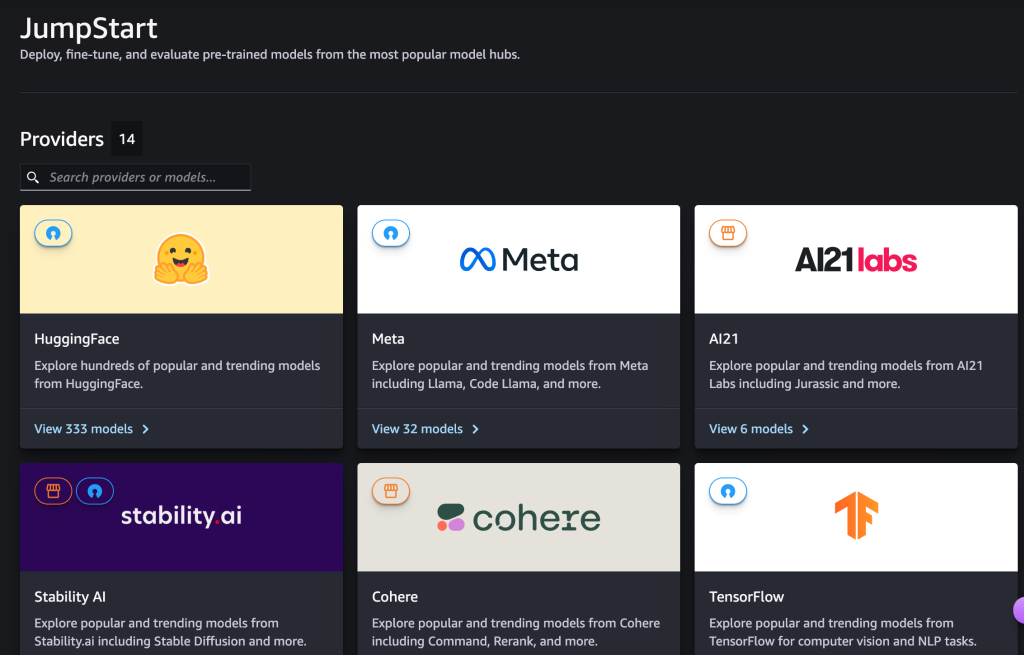

在Llama3发布后不久,亚马逊云科技就发布了新闻稿,与此前几次上架到Amazon Bedrock的不一样,这次是上架到了Amazon SageMaker JumpStart上。

Amazon SageMaker JumpStart是亚马逊云科技专门构建的一个机器学习服务,提供预训练的模型、内置算法和预构建的解决方案,帮助用户快速了解评估模型,快速开发AI项目。

通过Amazon SageMaker JumpStart部署Llama 3,过程会相当丝滑。用户在JumpStart后台能看到包括HuggingFace、Meta、Stability.ai等开发商的模型。

Meta标签下提供了多个Llama模型的版本,点击查看Llama3 70B指令优化版,这里有模型的介绍页面,右上角还有显眼的“Deploy”部署按钮。

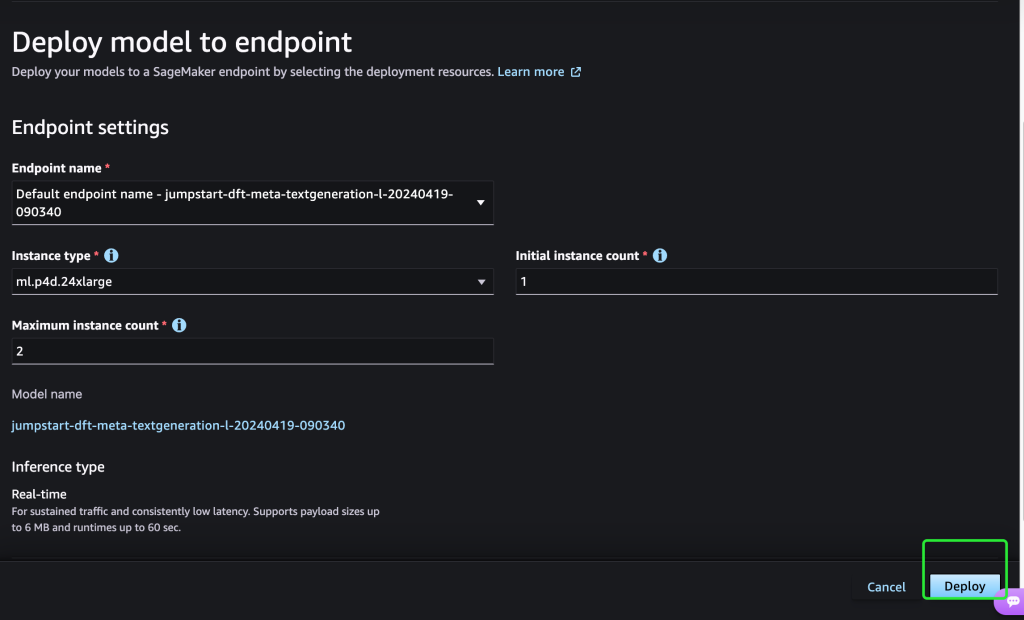

点击“Deploy”按钮之后,这里可以选择云主机的规格,进行一些主要的设置。最后,就可以点击部署来将其部署到对应的实例上了。

模型部署操作非常简单直白,部署后,用户就可以用自己习惯的方式来进行开发了。

开发过程中,可以使用SageMaker Pipelines、SageMaker Debugger或容器日志等功能,来提升模型性能和并实施MLOps控制。

由于以上这些操作都是在亚马逊云科技的平台上完成的,无论是模型本身,还是涉及的相关数据,都出于亚马逊云科技提供的安全措施的保护之下。

如果想亲自上手试试如何部署、开发,可以查阅一下亚马逊云科技的技术博客:

Meta在博客中表示,未来还将开源更大的400B的版本,目前400B的还在训练中,如果未来某一天Llama3 400B突然发布了,也可以考虑来Amazon SageMaker JumpStart在第一时间上手。

眼下,各种新的更强的大模型还在不断出现,今天的最强可能明天就会被超越,面对大模型技术跃跃欲试的同时,又总会感到迷茫和焦虑。

对此,亚马逊云科技CEO Adam Selipsky说:“事情发展得如此之快,在这种环境中,适应能力是您可以拥有的最有价值的能力。不会有一个统治一切的模型,也肯定不会有一家公司能提供所有人使用的模型。”

既然新技术不断出现,就应该试着去了解更新的技术。

过程中可以考虑利用亚马逊云科技提供的便利的平台和工具,亚马逊云科技一直在做的事情就是让各种技术的使用变得更简单,在大模型面前,Amazon SageMaker JumpStart和Amazon Bedrock都是很好的开始。