在AIGC多模态技术浪潮下,企业存储系统面临诸多挑战。腾讯云作为在业界率先发布AIGC存储解决方案的公有云厂商,今年其解决方案全面升级,针对AI大模型的数据采集清洗、训练、推理、数据治理全流程,腾讯云提供了高效的云存储支持,不断增强产品能力以应对大模型对当前数据存储的巨大挑战。

近日,腾讯云存储解决方案总监温涛受邀在2024数据基础设施技术峰会-“智算中心技术创新论坛”分享了腾讯云的数据智能生态创新之路,剖析腾讯云数据湖在赋能AIGC多模态大模型方面的应用实践。

去年年底到今年年初,很多客户开始致力于在视频方面的训练,我们直观感受到多模态大模型的冲击,也带来了一些机会和挑战。一旦进入到多模态,有了图片和视频之后,数据量特别大,现在原始数据量有的客户达到百PB级别,训练数据也到了几PB、几十PB,数据的流动、读取要求高很多,算力也是成倍增长,系统成本很高,我们的解决方案一方面解决性能问题,另一方面也要解决成本问题。

我们把AIGC的业务流程分为数据采集、数据清洗、数据训练、推理、内容治理。我们认为AIGC生成物里面有很多内容价值可以进一步挖掘,我们也有很多产品能力和解决方案创新的重点,也放在最后这个阶段。

在这五个不同的阶段,对存储数据的处理和存储其实有不同的要求:

对于采集来说需要非常高效灵活的数据采集接入的协议和接入的节点,另外数据采集阶段原始数据量很大,我们能承接EB级数据的存储,这是采集的要求。

清洗的要求主要支持多种文件协议,这里面有HDFS、S3。海量的吞吐能力,达到Tbps级别。

训练阶段要求就比较高了,无论是吞吐量和时延要求更高,我们认为需要亚毫秒级的时延。

内容治理,一方面是要有一个合规的要求,需要溯源,所以现在很多客户越来越关注内容的合规。

数据检索,为什么在第五个阶段很关注,当你生成的数据越来越大,很重要的一点是怎么把这些数据检索出来,能随时高效地找到你想要的数据,这个能力以后会备受关注。

总体来说,多模态大模型对存储系统提了五个方面的要求,低成本、高性能、海量存储、高可用、安全。

这五个阶段有不同的数据要求,也有不同的存储的数据,他们之间数据的流动就成为一个问题,如果是每个阶段有独立的存储系统不现实,无论是成本还是效率都是问题,就非常适合于用一个数据湖的统一存储平台,去实现数据的底座,减少数据无畏的流动。腾讯云COS Data Lake向智能数据湖演进,打造一体化AIGC多模态存储解决方案

腾讯云通过在数据湖原来的基础上增加了数据的加速能力,增加了AI能力之后,就可以把数据湖系统的业务范围扩展到AIGC、数据的智能检索,还有数据的资产管理,我们认为存储系统不只是要存数据,一定要把数据管起来,而且数据价值的挖掘逐步会变成企业资产,数据挖掘的越多,无形资产就越多,这个是能给客户带来一个新的增值的价值,这就是我们的思路,向智能数据湖演进。

架构分为四部分,底层是用对象存储,因为对象存储是低成本,五大要求第一个要求就是低成本,基于COS之上有三个子系统,包括数据的导入,因为数据量越来越大的时候,原始数据越来越大,原始数据会分散在全球各地,数据如何高效地导入进来是一个很大的问题,无论是成本还是效率,我们也做了很多事情,我们提供了数据迁移MSP的迁移服务,还有全球加速的能力,因为数据从全球各个地方收集的,如果没有加速能力,时间和网络成本是非常高的。

还有数据加速,数据湖通常是基于对象存储,但对象存储传统定位是低成本的海量的存储类型,强调就是低成本,低成本往往就代表性能也不可能太高,如果让对象存储能做对接AI,做AI的数据底座,一定是要有数据加速的支撑才行,所以在数据加速这个地方做了很多方面的开发。有五个组件,包括GooseFS-Cache,包括GooseFS-lite、GooseFS–x,还有一个元数据加速,还有AZ的加速器,不同类型解决不同的问题,总之是为了让对象存储跟得上计算的速度,不要成为整个计算系统里面的关键路径。

数据的分析和洞察,这是我一直强调第五个阶段的事情,这里面是基于数据万象的服务的集,里面功能很多,前不久新发布了一个服务能力Metainsight。

GooseFS数据加速服务,提升数据预处理、模型训练、推理应用效率

腾讯云如何将数据快速导入,从全球范围内快速收集数据。重点介绍一下缓存加速,也就是GooseFS缓存能力集,重点看两个,一个是GooseFS-Cache,GooseFS-Cache以前简称GooseFS,后来把GooseFS的能力扩展了一下,我们管它叫GooseFS能力集,以前的GooseFS现在只对应的叫GooseFS-Cache。

Cache是利用计算侧本地的资源,可以用内存,可以用SSD,甚至可以用GPU节点的HDD做本地化加速,这样能够减少网络的传输,实现低延迟和高带宽,特点是近计算侧,可以用于大数据、AI、HPC、基因测序、渲染这些场景,配合COS既实现低成本同时达到高性能的存储能力,它支持多种协议,同时可以支持容器化的部署,也可以跟Hadoop做集成,缓存的类型也可以很多,可以分级,可分好几级的缓存,来实现不同的性能要求。实际测算过使用不同的缓存介质,性能提升可以到2到10倍之间。

一站式内容审核、智能检索服务,为数据安全合规保驾护航

介绍一下关于数据分析和数据共享,数据万象能力的应用场景,包括内容审核、图片、视频、音频和文档的处理能力,既是服务于AIGC,也是基于AIGC,用AI对AI进行支持,这里面包括影像、图片、音频、视频里面的一些智能的标签,智能的搜索,包括评分,能力有很多,大概有100多种,而且在不断地持续。

最近围绕着AIGC,数据万象发布了新的能力,一个是一体化的内容安全方案,刚刚有嘉宾也讲了,数据安全非常重要,因为监管很严,我们这个方案在两个点去重点做内容安全的管理,一个是用户的输入,原始数据的输入和用户的输入都会做检查,给训练计算为了数据就是干净的,安全的,第二个是对于大模型生成的对象,这里面有时候可能也是因为AIGC生成的,有时候比较发散,没有那么严格的规则,要在生成物这个地方做一次内容审核的管控。

包括对违禁违法等内容的审核,同时提供了一些维权方面的能力,比如盲水印,以前看一些网络电视和视频在某一个角有一个水印,是明水印,后来出了一个暗水印,水印不是一个新的东西,水印有技术门槛,技术门槛就体现在防攻击能力上,有很多能力解决水印的问题,客户不但要加水印,还要去水印,目的就不深究了,有这个能力,去水印相当于一个攻击能力,想把水印做好防攻击是非常重要的参考因素,很多客户没有这个理解和认识,我们的防攻击能力是比较强的,我们要把盲水印能力作为一个重点。还有对数据进行格式转换、内容标注,都是在万象的一体化安全方案里面。,时长02:12数据万象MetaInsight演示视频

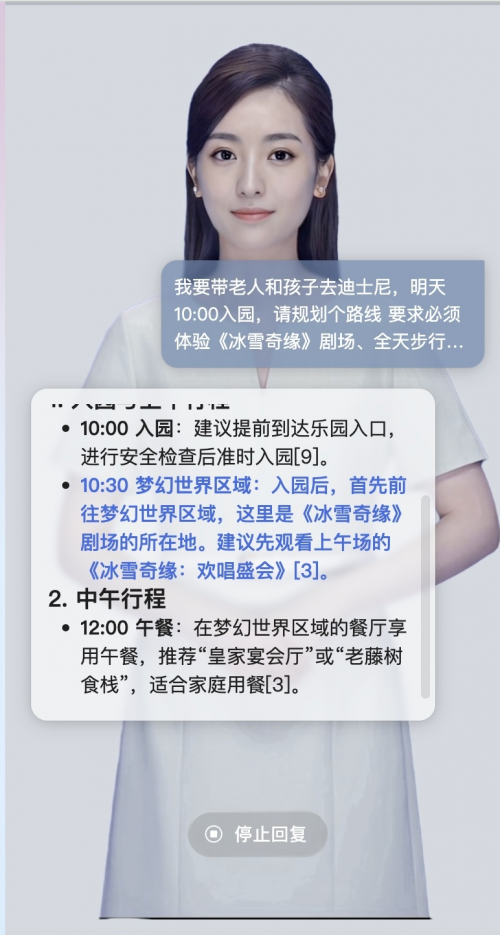

举一个例子,可以用两种输入方式,一种是文本输入,可以输入穿着红色长裙的舞者,还有可以导入一个图片,可以根据输入的要求,在后面的媒体库里面找最相近的,匹配度最高的图片,不仅是单纯的一个界面,界面像是一个ToC的服务,我们提供的是一个API的接口。

通过API进行数据的输入和输出,有两个数据流,一个数据流是把原来的媒体库,把用户要做内容搜索的媒体库,当然可以在AIGC把推理出来之后的生成的文件作为媒体库的内容,通过万象的API导入到里面,接下来是万象图文的大模型,这个大模型是我们自己训练的,基于公司内部的通用大模型,我们做了一个进一步的调优和训练,专门用于图文内容搜索模型的模型。

通过我们自己的图文大模型之后,就把导入的这些文档变成了量化,保存到腾讯云的数据库里面去,用户展示搜索的时候,我们把搜索请求通过图文大模型做向量化,从向量维度,在向量数据库里面进行搜索,找到匹配度比较高的,在向量空间匹配度比较高的对象,返回给用户,这就是一个技术原理和主要组成部件,当然数据是基于中间的对象存储,就是COS。

刚刚我们讲的MetaInsight的应用场景主要在推理,我们在AIGC的过程中在推理,对于一个生成的数据进行一些管理和检索,其实还有另一个应用场景,我们可以把它用作训练前数据的筛选,可以在数据清洗那个地方,让它发挥作用,为什么呢?

因为原始数据量很大,这里面质量很难得到保证,尤其是基于内容的时候,如果想生成一个特定场景的,垂直行业的小模型,或者是调优的模型,这时候你的内容相关性越强训练的效率越高,训练的效果越好,怎么喂质量更高的数据?可以用MetaInsight的能力,先过一轮,按照内容的要求把匹配度比较高的挑出来,再去喂给模型进行训练,这样的好处是可以大幅度减少训练的数据,也可以减少训练所需要的算力,也能提升整个训练过程的时间,所以效率和成本会带来很大的提升,当然里面也会结合GooseFS的加速,MetaInsight的能力一头一尾都可以用。

总结一下,腾讯云智能数据湖的方案针对AIGC场景提供了一系列的能力,包括数据迁移的能力,包括GooseFS缓存加速集的能力,还有数据万象集的能力,共同支撑AIGC的5个业务流程,一起提供一个低成本、高性能海量存储、高可用和安全合规的数据基座、数据平台。

(演讲内容详见会后专题)