2024年虽被外界普遍认为是“大模型应用落地元年”,但至今仍有很多声音,质疑大模型在具体行业的应用落地效果。大模型究竟如何更好发挥自身作用,助力企业实现AI转型,促进创新增长,也一直是媒体和行业的热议话题。

8月21日,在2024火山引擎 AI 创新巡展(上海站)期间,火山引擎发布了豆包大模型的一系列产品升级,并携手多点DMALL等零售巨头,成立了零售大模型生态联盟。联盟首批成员包括物美集团、抖音电商、抖音生活服务、百胜、麦当劳等。

火山引擎总裁谭待表示,企业要真正做好AI转型,是一件非常有挑战的事。希望通过大模型生态联盟,与更多企业伙伴一起探索,共同促进零售企业的AI转型,让大模型更好地为企业发展服务。

火山引擎智能算法负责人、火山方舟负责人吴迪则以《豆包大模型,助力企业AI转型》为题,现场分享了大模型如何在具体行业应用落地的细节。

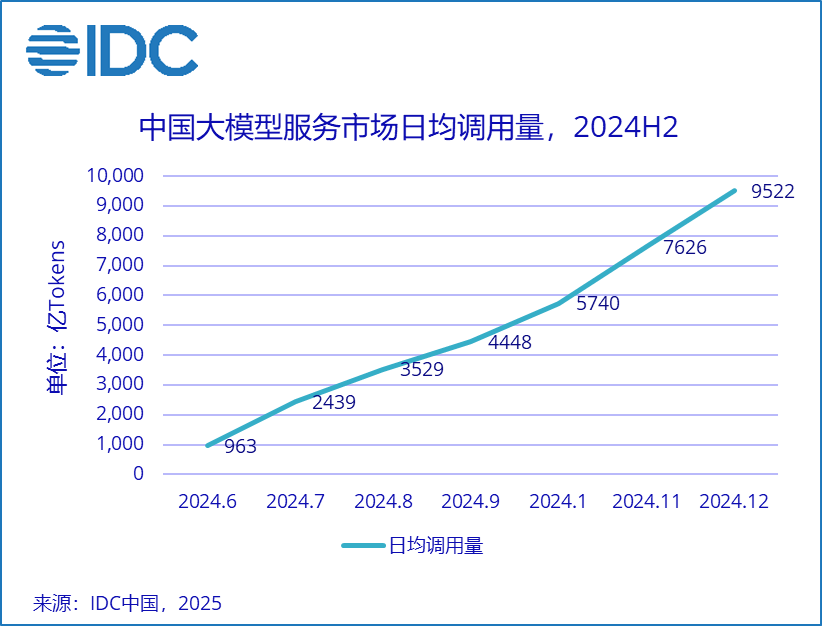

吴迪表示,自今年5月15日豆包大模型发布以来,60天时间里云计算客户总调用量增长了三倍左右。随着处理的问题越来越多,火山引擎对市场挑战的理解也越来越深刻,并将AI大模型落地具体行业所面临的问题总结为“三大挑战”:

一是基础模型是否足够“聪明”;二是价格和成本;三是落地过程中所面临新工作范式和企业原有IT系统之间的改造,以及兼容成本等具体问题。

而对于这些问题,豆包大模型则以更强模型、更低价格、更易落地的解决方案加以应对。

吴迪表示,目前在字节跳动企业内部,包括抖音、剪映、头条、豆包APP、飞书、懂车帝、猫箱、河马、番茄等约50余个业务线在使用豆包大模型,在外部每天则有30余个行业客户在使用。

而在价格方面,豆包通用模型pro的推理输入为0.8厘/千tokens,输出为2厘/千tokens。之所以能够把价格做到这个水平,背靠的则是强劲的系统承载力、充沛算力,以及积累多年的推理算法、系统优化及系统调度能力。

首先,火山引擎拥有海量GPU资源,目前在豆包大模型和火山方舟平台,已投入多达数万张不同型号GPU算力。

同时,造成算力枯竭的一个重要原因,是很多企业做不到灵活调配GPU算力,从而造成2/3甚至更多时间里,算力出现闲置或低效率表现。而火山引擎通过极致调度,避免浪费,则可以进一步将成本优势控制到同行的1/3甚至1/10。

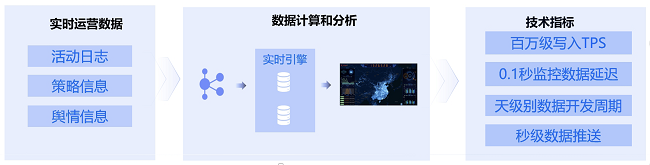

第三则是极致弹性。火山引擎可以做到分钟级完成数千卡伸缩,有效支持突发流量和业务高峰。而火山引擎推出的多种批量推理模式,则提供了业界领先的TPU初始额度。

除此之外,火山引擎还配备了优秀精干的算法工程师团队,支撑企业客户需求以及疑难问题的解决,用抖音内容、抖音搜索、知识库等插件,配合Coze扣子平台,打造更易使用的开发者环境,并利用安全沙箱,使客户可以更加放心地使用大模型。

在安全方面,首先通过TLS和安全沙箱实现双向身份认证和加密,建立互信连接,保证用户访问的安全。

其次则通过全链路数据加密,确保用户的使用安全。

第三则是通过安全沙箱技术,杜绝内外风险入侵和数据泄露的风险。

第四是“信息无痕”,做到“全链路”、“全内存”、“零日志”,在任务结束时安全沙箱自动销毁,用户画像全程无痕。

第五是操作可审计,对沙箱系统及用户流量的访问均有日志记录,客户也可以自行通过token API的方式对日志进行审计。

目前,火山引擎新升级的内容和联网插件提供包括金融、旅游、影视、生活服务等27个行业垂直内容的数据源,并新增抖音百科类型数据。

吴迪表示,升级后的知识库,在文档解析和检索能力方面都有了大幅提高,可以应对包括图片、多列表格、PPT、Markdown等更丰富的文档类型,并更具性价比,支持向量库的语义检索以及类似传统搜索引擎的准确检索等。

在活动现场,火山引擎还公开发布了全新的Coze扣子专业版,用于企业开发智能体。吴迪表示,火山引擎将在Coze扣子专业版上提供企业级稳定性保障,以及一键式接入火山方舟模型的能力、更高的tokens配额。

作为零售行业大模型生态联盟的发起者之一,多点DMALL创始人、物美集团创始人张文中博士也来到现场,并从具体的操作层面,与在场与会者分享了大模型如何在零售行业中具体落地。

张文中提出,目前AI大模型已经可以广泛应用于包括超市智能防损、智能补货、智能客服、以及折扣出清等多个方面。由于豆包大模型tokens定价极低,很多以往很难解决的难题,现在都有了很高性价比的解决方案。

张文中最后表示,AI时代,零售企业再也不能“单打独斗”。大模型时代,行业更需要携手共进,希望与火山引擎一起,向零售界发出呼吁,通过全面拥抱AI,一起努力共创智慧零售的新未来。(作者:梁芸)