与技术内容相比,我们更加关注的还是技术应用。结合GenAI应用,我们一直有一个疑问,就是CXL正其中,是否可以扮演重要的角色,在2024全球闪存峰会CXL分论坛上,MemVerge公司中国区CTO赵玥的主题演讲,很好回答了有关疑问。赵玥指出,GenAI应用能够很好发挥CXL技术的特点。

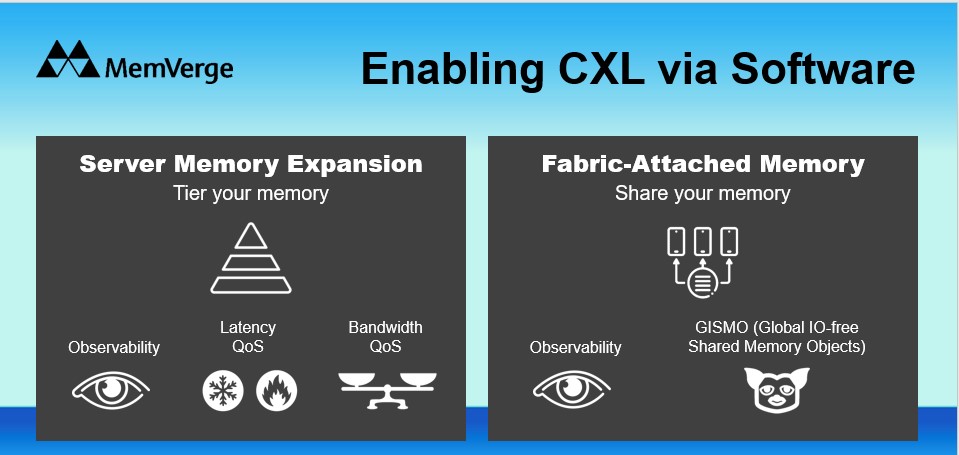

目前MemVerge从软件的角度,对于CXL两种应用模式提供支持,一种是服务器内存扩展;另外一种方式是通过CXL Switch交换机提供的CXL内存共享。在这样模式中,Memverge软件提供的主要功能包括内存监控、延迟以及带宽的QoS,针对第二种模式,除了监控能力之外,Memverge提供称为GISMO(全局免 IO 共享内存对象系统)功能服务,它基于 CXL多服务器共享内存架构,突破了分布式环境中数据访问和协作的界限。通过无缝集成 CXL 技术,Gismo 实现了跨多服务器的实时数据共享,消除网络 IO 瓶颈的同时,也减少了数据传输延迟。

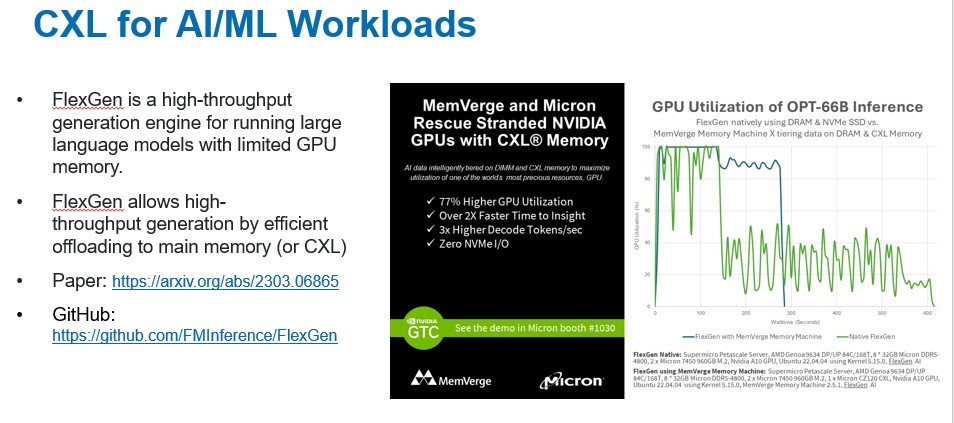

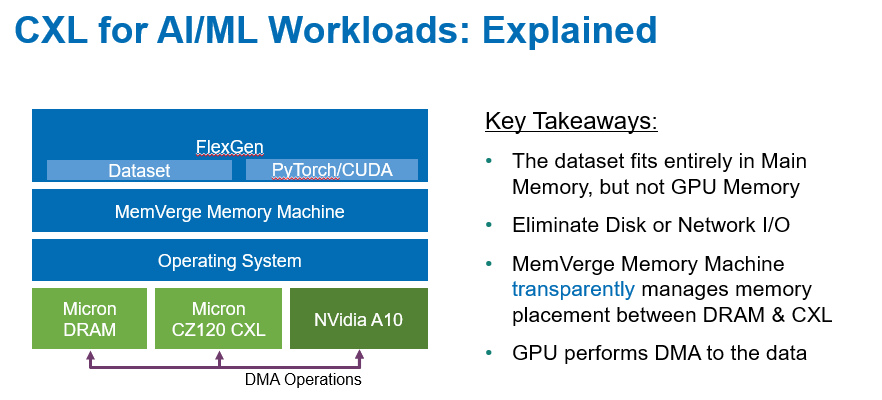

在演讲中,赵玥介绍了FlexGen如何在资源有限的单GPU情况下,处理高吞吐量的语言模型推理任务,其核心就是利用大量CPU内存或硬盘空间,从而解决GPU HBM内存比较小的限制。在FlexGen应用中,使用CXL内存扩展,其效果显著。

CXL对于AI/ML负载的价值,可以归结为几点:一是内存更加适配一些数据集;二是消除存储或者网络I/O的影响。在此,Memverge提供的Memory Machine软件能够透明管理好DRAM和CXL Memory内存。

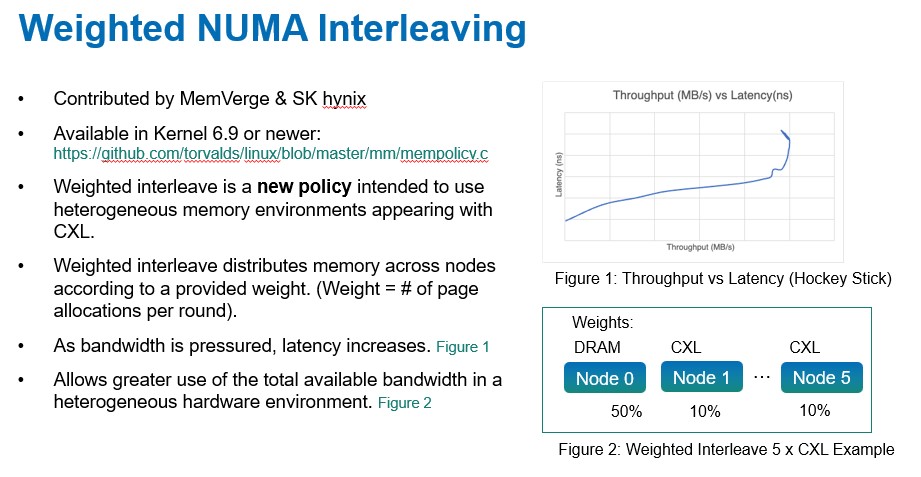

在演讲中,赵玥也介绍了一些CXL Memory内存配置管理的方法和思路。

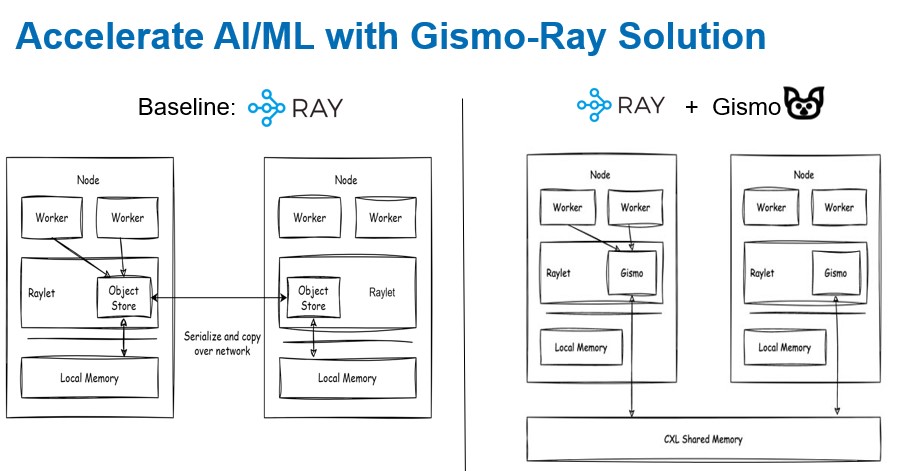

这是Memverge Gismo和Ray的解决方案,其中,Ray 是一个开源的统一计算框架,主要用于扩展人工智能(AI)和 Python 工作负载,涉及强化学习到深度学习、超参数调优、模型服务等内容。赵玥在此分享了很多技术细节,受技术水平的限制,我们没有办法一一展示出来,感兴趣的读者可以通过2024全球闪存峰会的官方网站,回看有关视频内容。

(本文未经演讲人审阅)