2024全球闪存峰会日前落下帷幕,峰会汇集闪存产业链专业人士以及存储技术爱好者,会议当天,大道云行首席解决方案专家陈勇以“全闪SDS构建先进存力基础设施”为题发表深刻洞察,并介绍了大道云行的最佳实践与存储解决方案,为听众带来价值参考。

构建全闪产品矩阵 筑牢存储底座

陈勇从三方面介绍了大道云行近年来重点打造的全闪家族。当前在AI和信创浪潮的推动下,我们看到整个存储行业都在往分布式架构化、高速网络化、NVMe化、信创国产化四个方向发展,同时也看到基于NVMe SSD的分布式全闪可以为各种超算、智算、新型的数据中心提供一个绿色、高效、安全、可靠的存储底座,促进绿色低碳转型。

权威报告显示,2026年HDD和SSD将迎来一个价格拐点,进一步加速SSD替代HDD。这也主要受益于QLC的出现,它推动了SSD向高密度方向发展。同时,再结合存储在去重和压缩TLC、QLC颗粒的数据分层,这些高级特性将进一步地帮助NVMe的分布式全闪在成本和性能之间实现一个更加优化的平衡,所以这几年我们看到全闪存储在中国的市场表现一直是非常强劲的,这个势头还会继续延续下去。

关于全闪架构设计,关于高性能方面的一些设计点,给大家详细地介绍一下我们的全闪产品。首先,大家一直以来都对分布式全闪有一些认识误区,认为NVMe SSD加上一些支持RDMA协议IP的网卡和开源软件,通过这种组合可能就是一个全闪。但是最后发现,这样组合下来的一个全闪根本无法将硬件的性能充分发挥释放出来。这是什么原因导致的呢?其实就是操作系统,操作系统作为存储硬件和软件之间的一个中间层,低效的CPU的内存分配,包括上下文切换、内存拷贝等等,带来多个影响存储性能的一些制约点,所以说真正意义的一个分布式全闪是需要从服务器的硬件到操作系统到整个存储软件栈,来实现一个深度的优化和全新的优化设计。

刚才讲到因为操作系统的原因,带来多个影响存储性能的制约点,所以说真正意义的分布式全闪是需要从服务器硬件到操作系统到软件栈,来实现深度的整合和全新的优化设计。从这个角度来讲,作为一个分布式全闪,首要的核心的设计要点就是要先解决操作系统带来的痛点问题。

为此,我们专门设计一个XPE存储引擎,通过OsBypass机制能够实现一个私有的CPU的调度和虚拟内存的管理,通过进一步优化任务调度和内存的分配,能够解决刚才我们所讲的操作系统带来的一些痛点问题,所以说它能够为存储事务提供一个非常高效的支撑。

对于分布式全闪来说,我们认为围绕着高性能方面的一些设计点,除了刚才前面讲到的一些存储引擎之外,其实还有多个关键的技术能力和核心的设计要素是需要我们考虑的。同时我们也看到,不同的全闪产品之间其实是存在一些共性的设计理念,所以说从这个角度我们并没有独立开发不同的全闪产品线,是从一个统一的产品规划和设计角度,打造一个Suzaku高性能全闪存储平台,这个Suzaku平台已经成为我们一个全闪的基石,我们现在三款全闪家族产品都是通过Suzaku平台来打造的。Suzaku最主要的是围绕一些高性能存储能力、设计要素和一些存储特性,包括一些接口协议,将它们以组件的形式放在这个平台里面。这些组件可以相互作用、灵活组合,从而可以快速地形成一个高度集成的存储解决方案,帮助我们加快开发效率、缩短开发周期。

同时我们也看到,Suzaku这种组件的设计形式,可以根据不同的IO场景来满足数据多样化的存储需求,形成一个快速的存储解决方案,所以它进一步地提高了我们产品的灵活性和可扩展性。

举个例子来说,在Suzaku平台里面,可以非常快速地形成一个全闪存储多协议的支持。当前,我们可以支持全闪块+文件、全闪对象+文件等等组合,所以说基于Suzaku平台,我们得以实现一个真正意义的分布式全闪的解决方案。在这个基础之上,我们打造一个面向AI时代的先进存力基础设施的全闪产品线。

接下来,我将Suzaku平台里面其中的一些设计点做一个展开介绍,首先是一个并行流水线专核专用:无锁多核同步。我们的存储内部会将CPU和内存进行切割和绑定,形成一条条流水线,这些pipeline流水线之后会和不同的任务阶段,像协议解析、IO调度、元数据处理、数据落盘再进行绑定。我们可以看到每一个任务都有相应的pipeline流水线进行配合的,所以它们之间就可以实现一个流畅的无锁的独享的访问。

另外,我们看到CPU有自己的专属内存,所以在资源紧张的情况下,它就不会跨Liuma 去访问内存池。同时,我们可以根据不同业务阶段的重要性程度不同,进行灵活的资源分配,确保一些重要任务可以获得更多的CPU core扩展内存,这样可以更高效地处理存储事务。通过这些设计,可以充分发挥CPU多核能力,将CPU利用率提高,所以在我们整个全闪存储内部会看到我们每时每刻每个CPU core都在非常高效地运行工作。

第二个就是端到端NVMe,我们从NVMe SSD,到基于用户态的存储软件栈,再到NVMe Target,再到NVMe 的客户端,从服务端到传输到客户端形成了一个全通道的NVMe的优化,来提高传输效率,降低延时。

第三个就是Log structure,我们也是结合数据库技术,将我们的写定两个过程,第一个是数据以追加写的形式写到Log区,快速给到客户端,返回写入成功这样一个响应,提高写效率,因为数据是追加写,可以抑制NVMe SSD的写放大;第二步就是数据落盘,我们进行一系列IO合并对齐,将一些离散随机的小IO转化为顺序型大IO,来提高落盘效率。基于Log structure这个技术,我们对EC进行优化,当前我们的EC能够达到一个副本的性能表现,所以目前我们所有的三款全闪产品都是通过纠删码来做交付的。

除此之外,这些设计共同的作用提高了我们全闪产品的存储性能。大道云行是第一批基于SDS 2.0架构进行分布式全闪研发和设计的公司,经过持续多年的探索和创新,基于我们的Suzaku平台,打造包括FASS全闪块、FOSS全闪对象和FAFS全闪文件在内的全闪家族。

最佳实践

我们深刻意识到生态合作的重要性,这么多年一直在多个领域携手不同的厂商,通过联合测试、项目合作,共同打造最佳实践和联合解决方案。

接下来分别介绍一下三款全闪产品,第一个是FASS,也是最早发布的,是一个采用分布式架构的全闪块存储,FASS可以通过并行流水线等技术,能够轻松实现千万IOPS微秒级延迟,FASS可以非常高效灵活地对接各种虚拟化平台、裸金属云、桌面云以及数据库等场景。

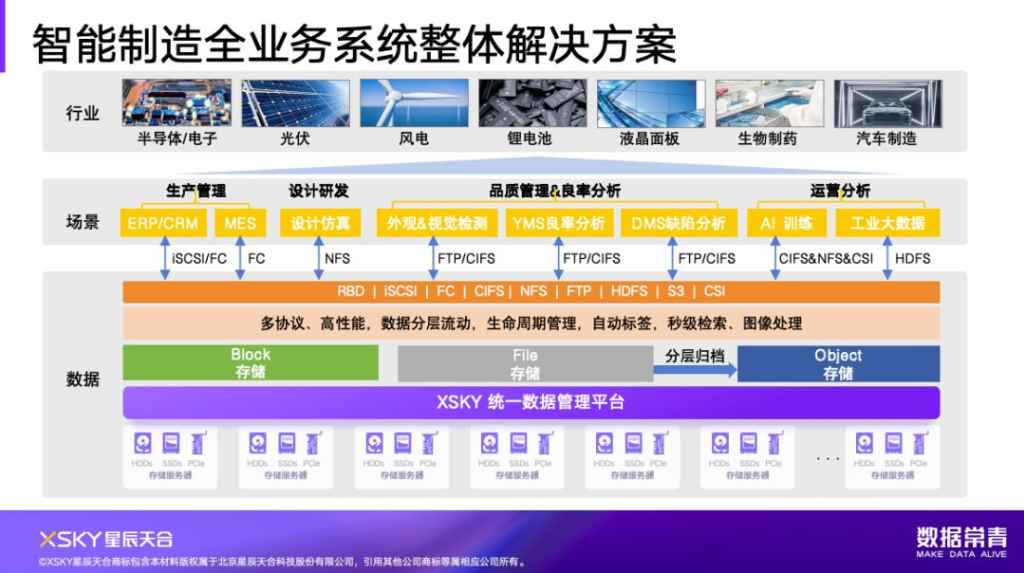

FOSS是一款分布式架构的全闪对象,支持大规模、超大规模的海量非结构化数据的高效存储,支持标准的SAN协议,当前FOSS最主要的应用场景还是助力智能制造、高端制造,实现数智化转型,为新质生产力提供强有力支撑。

FAFS是一款分布式架构的全闪文件,有不同的高吞吐的带宽表现,微秒级延迟,支持多种接口协议,可以灵活高效处理AI/大模型训练、高性能计算、大数据分析、EDA仿真设计,包括海量小文件下文件数据共享访问模式的应用。

一直以来,我们也积极地加入鲲鹏生态建设,致力于推动双方的适配和联合优化。继FASS 1.3产品之后,在今年5月携手鲲鹏,加入了鲲鹏的原生合作开发之中,基于鲲鹏商用服务器欧拉的操作系统,双配的套件,持续发布了性能最优的一个鲲鹏商用版本软件。

目前,FASS分布式全闪存储系统获得了鲲鹏NATIVE认证,未来我们继续携手鲲鹏推动我们全线产品的优化,助力鲲鹏生态建设。

最后通过三个典型解决方案的分享,帮助大家对我们全闪存储在应用场景和优势方面有一个更深入的理解。

大家首先看到的是我们一个FASS全闪块存储,经过持续多年的打磨和优化,目前支持各种标准X86信创的服务器,支持多种协议,也支持多个接口,已经具备了全栈信创+多云支持+vSAN替换的能力。同时,我们也在和一些国内的优秀厂商合作,可以提供一个全过程的从前期的规划设计到中期的部署交付到后期优化的一系列操作的实践和最佳指导,帮助我们的用户实现从计算到网络到存储的这么一个VMware环境的存储提供商。

第二,在人工智能方面,我们可以非常好地对接AI大模型训练这个场景。我们都知道,大模型训练在不同的阶段对于存储的性能提供了多元化的挑战,我们可以通过三个阶段来分别找来看一下,首先是数据加载阶段,模型在训练之前,因为为了避免模型对数据集特定的顺序产生依赖,所以第一步要做的就是对数据集要做数据集的随机打散打乱,我们称之为shuffle, “洗牌”的动作。这个“洗牌”动作,如果说这个数据集是一个海量的小文件,就会涉及大量的随机读,对于全闪存储元数据的读性能提出挑战。第二个阶段checkpoint文件保存,会涉及大量的大文件的顺序读写,考验的是存储的写吞吐能力。最后我们看到在推理和部署阶段会涉及到很多的模型加载,Pika等模型加载工具又会带来大文件的顺序读和随机读两种模式,这两种模式考验的是存储读IOPS和延时能力,FAFS可以通过小文件的优化,能够加速AI的训练进程,缩短AI的训练周期。同时,因为我们有一个全闪家族产品,也将FOSS全闪对象以及XDFS融合到这个过程中,实现FAFS和FOSS数据分层,同时将一些训练的中间结果和一些推理的数据集放到大容量存储里,通过多场景多存储的融合,进一步优化了AI的工作流程。

最后,我们看到的是数据库,其实数据库一直以来是分布式存储应用场景的一个灰色地带。但这几年我们一直在这方面进行一些探索,或者是我们希望一些技术突破,所以说我们就联合了国内的一些国产的数据公司,包括传统的像Oracle这样的厂商,我们通过大量的破坏性测试来验证我们的FASS全闪块做了一个数据库底座,在极端的情况下的性能和稳定性的表现。目前我们的FASS块已经都有相应的项目交付,目前最长的Oracle线上运营时间已经超过三年,目前的性能和稳定性表现也得到了用户的高度认可。

我们在今年又联合了一个Oracle的服务商,在3节点的FASS全闪里做的一个联合测试,从这个测试结果来看也表明了我们目前在数据库加速方面已经取得了一些显著的进展和突破。

展望未来,因为今天也有一些同行友商来参加演讲,我们未来和众多友商共同努力,不断地创新和探索,我们相信分布式存储未来一定会迎来一个新的高度,带来更多价值。