谷歌DeepMind部门上周公布了优化芯片设计的AI模型,正式名称为AlphaChip。

2020年,DeepMind团队在科学期刊《自然Nature》上公布了用于设计芯片布局的增强式学习(reinforcement learning)方法,之后也在GitHub上开源。

上周该团队发表了《自然期刊》补充了说明方法及对芯片设计的影响。本周谷歌公布该模型正式名称AlphaChip。谷歌称自2020年以来已经用AlphaChip模型设计了三代自己的AI加速器TPU,这些芯片让自身可以根据谷歌Transformer架构大规模扩大AI模型。

AlphaChip在一个空白芯片上,每次铺设一组电路,直到完成所有元件,然后根据最后电路布局的质量获得反馈。新的边缘式图像神经网络让AlphaChip能够学习互联的芯片元件之间的关系,发展出泛化到其他芯片的方法,借此逐渐改善每一代布局设计。

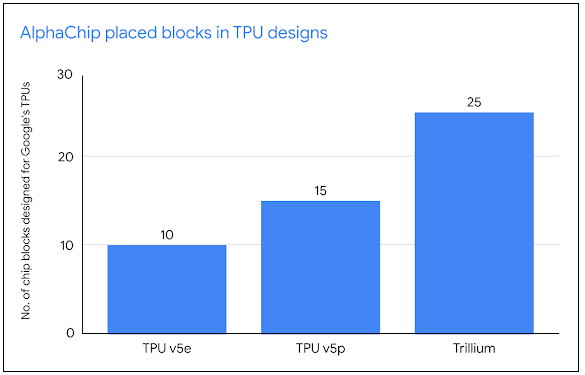

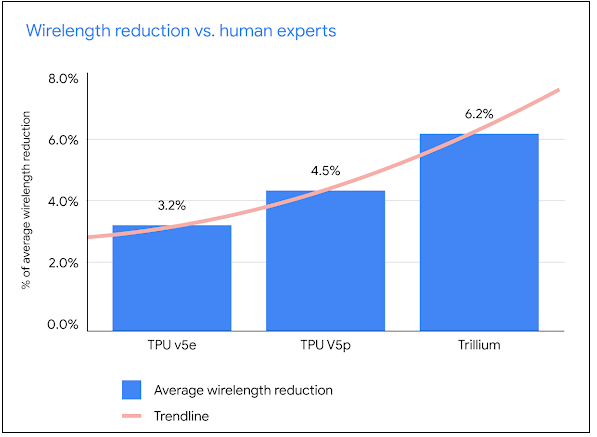

设计TPU布局阶段,经过预训练之后,谷歌在最新TPU block上执行AlphaChip产生布局设计。由于采用了增强式学习,AlphaChip芯片布局能力越来越好,也越来越快。谷歌表示,近三代TPU,从TPU v5e、TPU v5p到第6代TPU的Trillium,AlphaChip的芯片布局品质更提升,整体布局规划贡献比例也更多,布局的块(block)由10增加为25,且减少的线长(wirelength)比例,也从3.2%提升为6.2%,证明能加速设计周期,催生更高效能的芯片。

图片来自谷歌

AlphaChip除了用于设计如TPU等专用AI加速器,也为Alphabet生成其他芯片,像是第一块通用型基于Arm的数据中心处理器的谷歌Axion Processor。使用AlphaChips设计的外部单位包括联发科,它扩展AlphaChip的设计来设计其三星手机使用的5G芯片天玑(Dimensity)系列。

现在AlphaChip涉入的芯片设计阶段也更广,现在扩及逻辑合成(logic synthesis)和宏选择(macro selection)。

为了便于开发人员试用AlphaChip,DeepMind也公布了预训练的检查点(checkpoint)作为共享资源。