引言

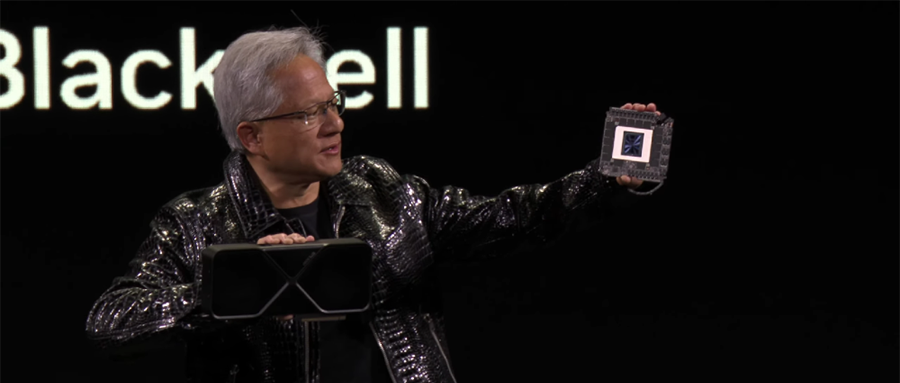

【算力豹导读】10月20日消息,据媒体报道,NVIDIA的最新研究可能彻底改变AI的未来,其研究团队提出了一种名为归一化Transformer(nGPT)的新型神经网络架构。这一架构在超球面(hypersphere)上进行表示学习,能够显著提升大型语言模型(LLM)的训练速度,最高可达20倍,同时保持了模型的精度。

nGPT技术概述

文本越长,加速越快

在nGPT中,所有的向量(嵌入、MLP、注意力矩阵、隐藏状态),都被归一化为单位范数(unit norm)。

输入后的token在超球面表面上移动,每一层都通过「位移」来贡献最终的输出预测,其中位移量是由MLP和注意力模块进行定义的,其向量组件都位于同一个超球面上。

实验表明,nGPT达到相同精度所需的训练步骤减少了4-20倍,具体取决于序列长度:

– 1k上下文,训练速度提高4倍

– 4k上下文,训练速度提高10倍

– 8k上下文,训练速度提高20倍

nGPT架构特别注重数据流的管理与优化,采用先进的并行计算技术,有效减少数据传输延迟,确保了大规模训练过程中的高效率和稳定性。

nGPT架构设计考虑到了广泛的应用场景,其模块化和可扩展性特点使得模型能够灵活适应不同的任务需求,从自然语言处理到图像识别均能展现出色的适应性。

nGPT全新架构,超球面上归一化

毋庸置疑,Transformer架构是现代大模型的基础。

不过,当前基于Transformer搭建的大模型都是计算密集型的,需要耗费大量的资源和时间。

为了改进其训练稳定性、推理成本、上下文长度、鲁棒性等方面,AI科学家已进行了大量的修改尝试。

由此,英伟达团队提出了,在归一化Transformer新视角下,统一该领域的各种发现和观察。

在超球面上优化网络参数

建议将形成网络矩阵嵌入维度的所有向量归一化,使其位于单位范数超球面上。这种方法将矩阵-向量乘法转化为余弦相似度的计算,其范围限定在 [-1,1] 之间。而且归一化消除了对权重衰减的需求。

归一化Transformer作为超球面上的可变度量优化器

归一化Transformer本身在超球面上执行多步优化(每层两步),其中注意力和MLP更新的每一步,都由特征学习率控制——这些是可学习的可变度量矩阵的对角线元素。

对于输入序列中的每个token ,归一化Transformer的优化路径从超球面上对应于其输入嵌入向量的点开始,移动到超球面上最能预测下一个的嵌入向量的点。

更快的收敛

研究证明,归一化Transformer将达到相同精度所需的训练步骤减少了4-20倍。

Transformer简介

Transformer基本架构

自注意力机制原理

自注意力机制是Transformer架构的核心,它通过计算输入序列中每个元素与其他元素之间的关系权重,实现了信息的全局捕获和加权求和,从而提升了模型对序列数据的处理能力。

编码器与解码器结构

Transformer模型由编码器和解码器两部分组成,编码器负责将输入序列转换为中间表示,而解码器则将这种表示逐步转换回目标序列,二者通过多头注意力机制进行信息传递。

位置编码的作用

在Transformer模型中,为了保留序列数据的顺序信息,引入了位置编码。位置编码为每个序列位置赋予唯一的向量表示,使模型能够区分不同位置的输入,增强序列理解。

注意力机制原理

注意力机制是深度学习中的一种技术,它模仿人类的注意力聚焦特性,通过赋予不同输入不同的权重,帮助模型关注到最关键的信息,从而提高处理效率和准确度。

自注意力机制允许模型在处理序列数据时,能够同时考虑到序列中的所有元素,通过计算每个元素与其它元素的相关性,实现信息的全局整合,显著提升模型的表现能力。

多头注意力机制通过并行运行多个注意力层,每个注意力层从不同的表示子空间学习信息,然后将这些信息汇总起来,增强了模型捕捉复杂模式和关系的能力。

多头注意力机制是Transformer模型的核心组件之一,它允许模型在不同的表示子空间中同时学习信息。这种机制增强了模型对复杂数据模式的捕捉能力,提高了处理长距离依赖关系的效率。

将位置编码与多头注意力机制相结合,Transformer模型能够在保持对序列中每个元素位置敏感的同时,有效处理不同位置间的相互影响。这种方法不仅提升了模型的性能,还增加了其灵活性和适用性。

nGPT与Transformer的创新点

动态计算架构

nGPT通过引入动态计算架构,能够根据输入数据的特性和需求灵活调整计算资源的分配,显著提高了模型的运行效率和处理速度。

增强的并行性

nGPT在设计上优化了并行计算能力,通过更细粒度的任务分解和更高效的数据流管理,使得大规模并行处理成为可能,从而大幅提升了模型的训练和推理速度。

自适应学习机制

nGPT内置了先进的自适应学习机制,可以根据不同任务的特点自动调整模型结构和参数,这种自适应性不仅提升了模型的泛化能力,还增强了其对新数据的学习能力。

nGPT跨领域适应性研究

领域适应性的基本概念:

领域适应性(Domain Adaptation)是迁移学习(Transfer Learning)中的一种,旨在解决模型在源域(source domain)和目标域(target domain)之间分布不一致的问题。通过领域适应性,可以尝试建立一个在源域和目标域都适用的模型,以实现知识的有效迁移。

nGPT在跨领域适应性的应用:

nGPT作为一种创新的神经网络架构,其核心在于超球面优化策略,这一策略不仅提高了训练速度,还增强了模型的稳定性。在跨领域适应性研究中,nGPT可以通过调整其超球面优化策略,适应不同领域的数据分布和特征,从而实现知识的迁移和共享。例如,在语音识别、文本处理或图像识别等领域,nGPT可以通过调整其向量归一化策略和位移量计算方法,适应不同领域的特定需求。

具体应用案例:

在语音识别领域,nGPT可以针对不同口音和噪声条件下的语音数据进行有效识别。通过调整其超球面优化策略,nGPT可以适应不同口音和噪声环境下的语音数据分布,提高识别准确率。在文本处理领域,基于新闻数据训练的nGPT模型可以适应博客或论坛等不同领域的文本数据。通过调整其向量归一化策略和位移量计算方法,nGPT可以捕捉到不同领域文本数据的特征和差异,实现有效的文本分类和信息提取。在图像识别领域,nGPT可以针对无背景物体图片进行训练,并将其应用于实际生活中存在背景的物体图片识别。通过调整其超球面优化策略和特征提取方法,nGPT可以适应不同背景下的物体图片数据分布和特征差异。

总的来说,nGPT在跨领域适应性研究方面具有重要的应用价值和研究潜力。通过调整其超球面优化策略和特征提取方法,nGPT可以适应不同领域的数据分布和特征差异,实现知识的迁移和共享。然而,需要注意的是,跨领域适应性研究仍然是一个复杂而有挑战性的问题,需要进一步研究和探索更有效的方法和技术来提高nGPT在不同领域中的应用效果和稳定性。

结语

英伟达的归一化Transformer(nGPT)不仅在技术上实现了突破,而且在实际应用中展现出巨大的潜力。这一创新架构的出现,预示着AI领域将迎来更高效、更智能的发展时代。(文/宋雨涵)