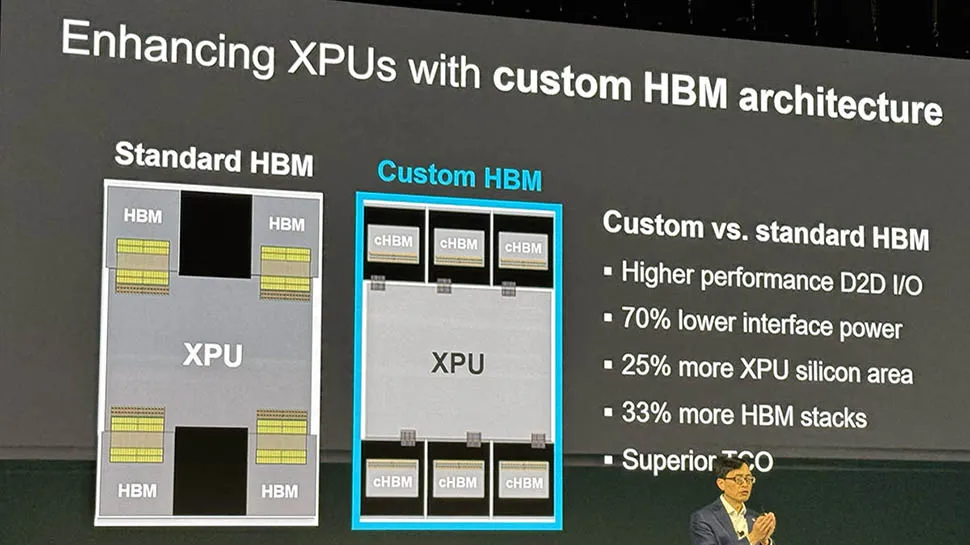

HBM是AI计算架构的关键部分之一,它在GPU核心的附近放置,可以实现超快的数据传输。然而,如果严格遵循JEDEC协议,HBM性能的提升将变得困难。为了加速HBM的发展,Marvell与其他公司正在开发一种定制的HBM架构。

Marvell发布了一种全新的定制HBM计算架构,旨在提高XPU的效率和性能。这一架构是与内存巨头美光、三星和SK海力士合作开发的,目标是通过提供为下一代数据中心量身定制的解决方案,解决传统内存集成的局限性。

新架构专注于优化XPU处理内存的方式。与标准的HBM相比,通过优化AI计算芯片和高带宽内存堆栈之间的接口,可将功耗降低高达70%。

而且,这种做法可减少多达25%的芯片面积,使云计算运营商能够扩展更多计算能力或添加更多内存。这种架构可能让XPU支持多达33%的额外HBM堆栈,从而大幅提升内存密度。

Marvell定制计算和存储集团高级副总裁兼总经理Will Chu表示:“通过为XPU量身定制HBM以优化性能、功耗和总拥有成本,是AI加速器设计和交付方式的新范式中最新的一步。”

传统架构限制了其扩展性和能源效率,而Marvell的新方法修改了HBM堆栈本身及其集成方式,旨在以更低的功耗和成本实现更高的性能。这些都是超大规模数据中心运营商面临的关键问题,他们需要不断应对数据中心日益增长的能源需求。

ServeTheHome的Patrick Kennedy在指出,定制HBM区别于JEDEC标准方案,它不是现成的HBM。他写道:“将内存从JEDEC标准转向为超大规模运营商定制,是行业内一次里程碑式的变革。这表明Marvell赢得了一些重要的超大规模XPU订单,因为内存领域的这种定制不会服务小订单。”

这场合作标志着HBM技术进入了一个新的阶段,为AI驱动的未来提供了更强大的支撑。

原文地址: