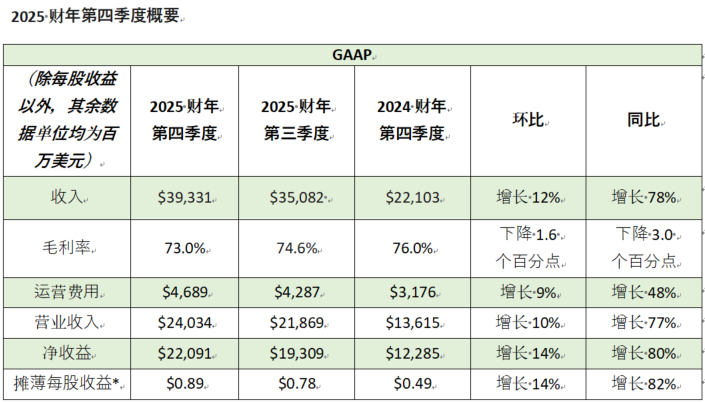

2025年CES上,黄仁勋的主题演讲吸引了很多关注,我也在第一时间收看了在线直播。

不得不说,老黄现在作为全球科技界的顶流,成功让显卡这种东西随着AI的爆火,从游戏玩家的话题变成了大众话题。

本文将带大家看看我注意到的有意思的三个瞬间,并做一点小小的解释。

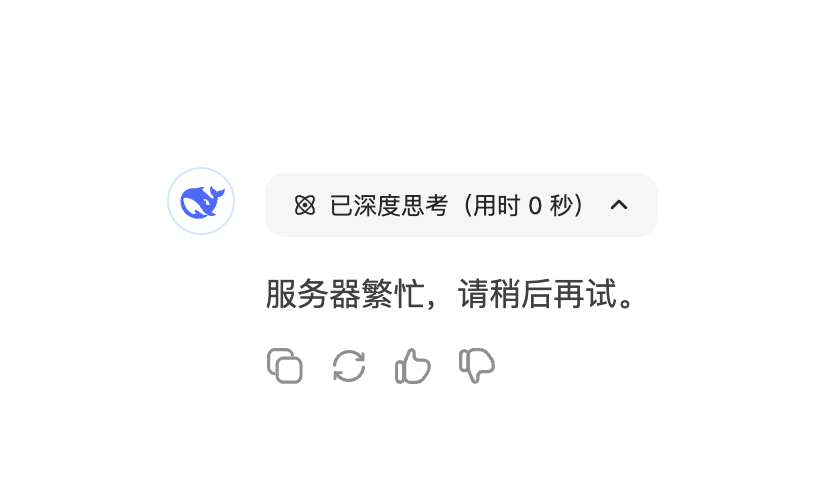

第一个瞬间,继续单手持握的RTX50系显卡。

笔者作为游戏玩家,首先会关注的就是RTX系列显卡了。在当天刚开场不久,黄仁勋就拿出来了RTX50系显卡了,其中5090最为引人注目。

虽然TGP从4090的450瓦提高到了575瓦,但单手持握意味着至少公版的5090不需要特别夸张的散热规格。非公版显卡的三风扇应该可以比较好的压制温度。

虽然5090的散热要求并不是非常过分。不过,1999美元的定价,32G的显存还是有点过于高冷了,显然根本不是给游戏玩家准备的。

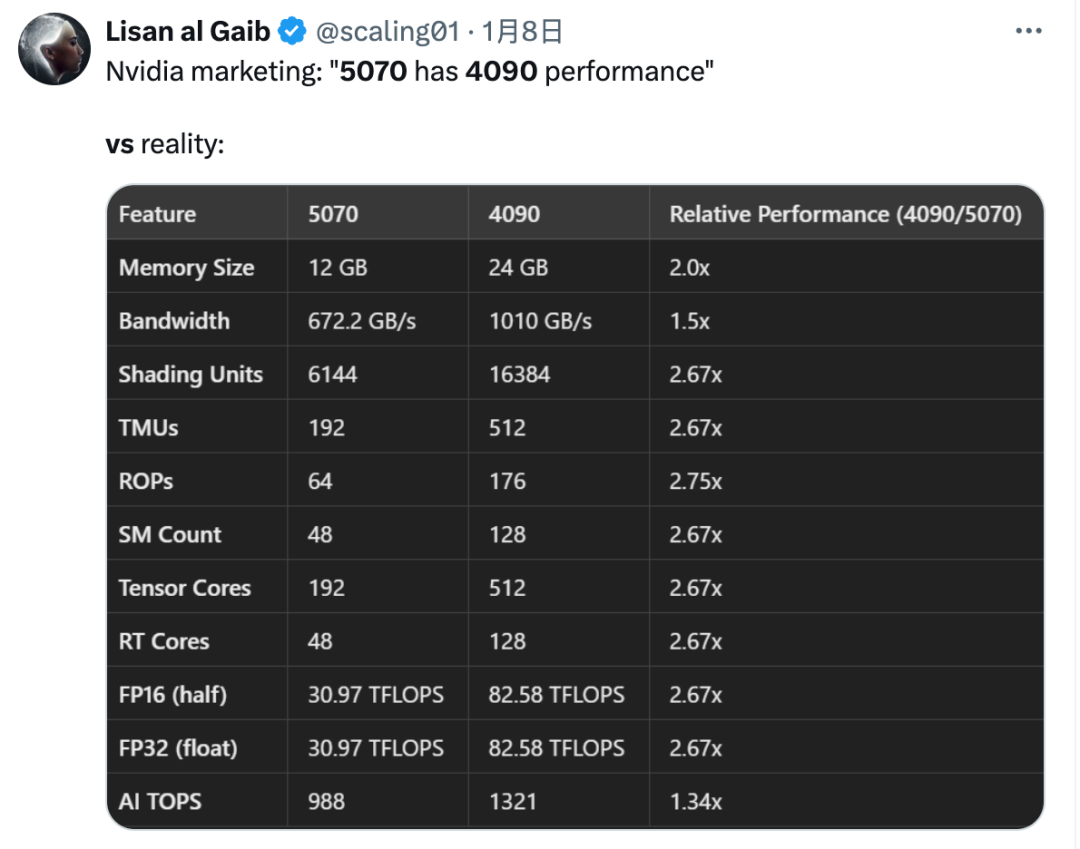

对于大多数人来说,看到老黄说5070的性能等于4090就开始上头了,简直就是看到了捡便宜的机会,不买一张5070比买了A股还难受。

而买了4090的网友听完就炸锅了,直呼:没想到看个发布会,我的4090就只值5070的549刀了?

不过,你一定可以相信老黄的皮衣,老黄的刀法,但对老黄的这类描述一定要谨慎对待。比如,当年就说过3070的性能可以超过上一代旗舰RTX 2080 Ti,实际上根本不是那么回事。

有国外网友列出了两张卡的对比数据,看到这个,你还敢信老黄说的?最多就是部分参数性能能达到一个水平吧。总之别太上头,最好过一阵子看看国行5070的价格再说。

不过,我觉得老黄这次CES上说的RTX 5090倒是还有一个有意思的地方,要不是这位叫Jim Fan的大佬说,我也完全没注意到。

他说,新一代显卡将使用神经网络生成90%的游戏画面的像素,只有10%的像素使用传统的光线追踪算法来渲染像素。使用传统方法渲染的画面像草图,而显卡会根据草图生成其他的画面细节像素,生成速度很快。

这就有点颠覆性了,生成式AI大模型诞生于显卡,又再造了显卡。游戏显卡以前叫GTX,RTX的命名就是在给光追做推广,以后RTX的命名是不是会根据AI再做一次修改呢?

除了生成更多像素,英伟达还支持让显卡生成新的画面帧,传统计算方式生成一个帧之后,用DLSS再生成三个帧。这将大大提高游戏的帧率,提高游戏画面的流畅度。

以后还哪有什么玩游戏的显卡,就算你是在玩游戏,显卡也在不停的做AI推理啊。

第二个有趣瞬间,化身美国队长,展示GB200 NVL72的强大。

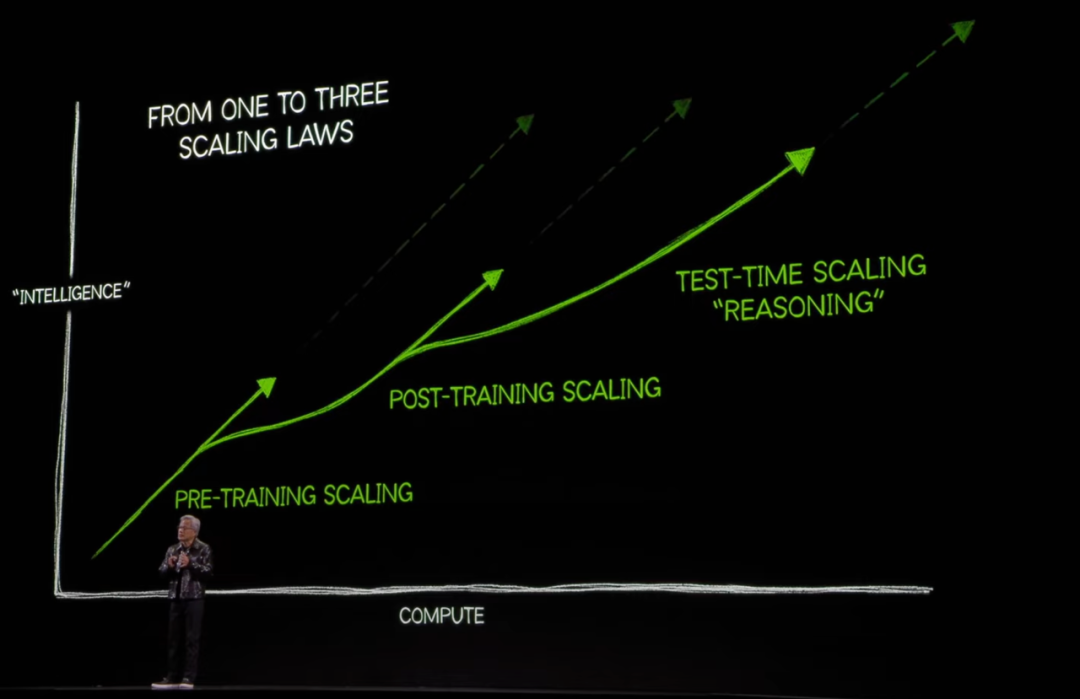

酒过三巡,介绍完消费级显卡之后,在介绍数据中心级B200显卡之前,老黄提到了三个Scaling Law。

第一个是预训练阶段模型会随着数据、算力和参数的提升而提升效果;

第二个是在训练完成后,通过微调、模型蒸馏等各种优化技术进行二次训练来提升效果;

第三个则是在推理阶段,通过多步骤的推理,类似慢思考的方式来提升模型的效果。

为什么强调这Scaling Law呢?因为这三个阶段都需要大量的B200这种级别的高性能显卡。

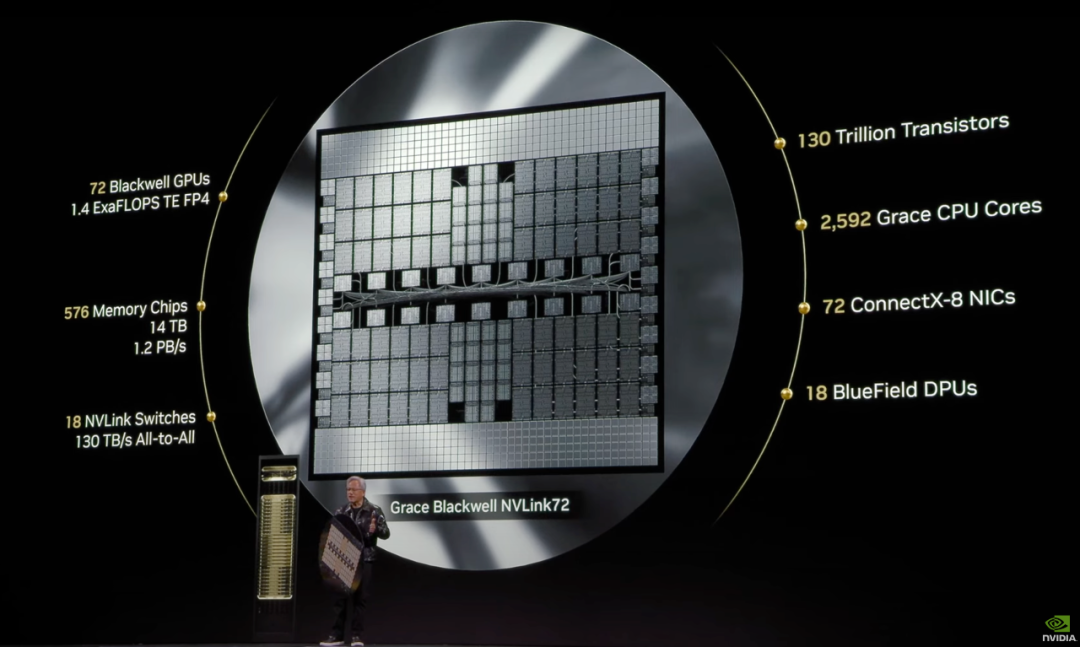

为了帮助大家了解这些有点乱的信息,这里先明晰几个概念。首先,新一代显卡的架构叫Blackwell,所以,显卡代号就是B200。

而常说的GB200其实是同时带有Grace CPU和Blackwell显卡的主板。如上图所示,就是一个超级芯片。严格来说,它叫NVL2,因为它有两个Blackwell显卡。

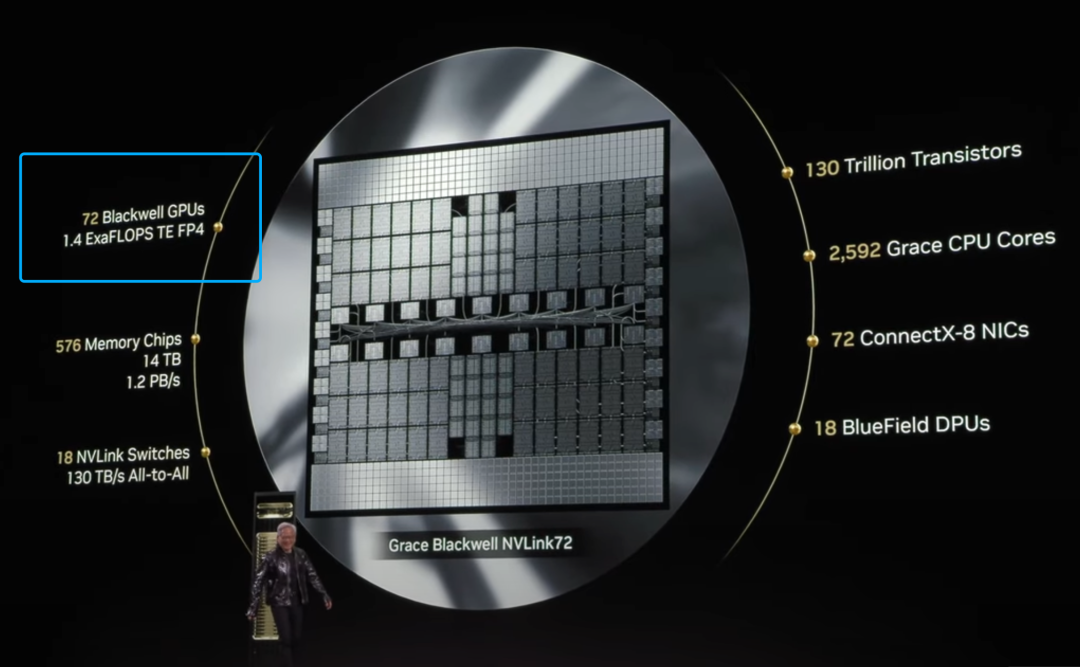

上图是一套NVL72机架系统,NVL72里是用NVLink连接了72块B200显卡,也就是36个NVL2的小的超级芯片。NVL72是史上最强 AI 计算系统,拥有 1.4 ExaFLOPS算力、14TB HBM内存、1330 万亿晶体管。

老黄宣称,目前,各种规格的GB200 NVL系统已经进入全面量产的阶段,主流的云服务商都部署了。新的Blackwell显卡提供4倍能效、3倍成本优化,大幅降低 AI 训练和推理成本,将加速 AI 应用发展。

为了形象地介绍这套NVL72有多夸张,老黄拿出了看着像美国队长一样的盾牌,摆出了美国队长的英雄姿势。

刚看见这块芯片模样的东西,我就直接懵了,这么大的芯片认真的吗?主流的晶元最大才12英寸,这肉眼看着直径至少27寸显示器那么大。

这么大一块超级芯片,散热要怎么弄呢?我发现有这个疑惑的不只是我一个。老黄拿着这块芯片对着NVL72比划,让很多人误以为,这是把这么大的芯片塞到这台NVL72机柜里了。

我也被老黄的这顿意外的表演迷惑到了,有点懵。很多外国网友都有一样的感觉。有网友指出来,老黄手里拿的是一个道具,展示的只是一台NVL72机柜中用到的主要芯片放在一起的样子。

真正NVL72的芯片不是这么制造出来的,更不是这么使用的。广大网友请放心:要真有这么大的晶元,很可能不是台积电代工的,而是宇宙积电代工的,你不考虑一下良品率了,也得起码给他来点液氮做散热标配了吧。

老黄这波模仿美队的操作,总感觉要跟钢铁侠马斯克组CP了。

毕竟马斯克目前的AI公司xAI,还有具有自动驾驶能力的特斯拉汽车,还有人形机器人擎天柱,都需要用到老黄的显卡。马斯克用英伟达显卡就是最好的背书之一,毕竟马斯克是最懂怎么把钱花在刀刃上的。

话说回来,老黄的特殊安排不只是这个道具。他宣称,这一块超级大芯片,也就是一台NVL72,能提供1.4ExaFlops的算力,ExaFlops什么概念?这不就是前几年一直在说的,全球很多超算追求的发展目标吗?

老黄也说了,以前超算数据中心里一整个屋子的服务器加起来才能达到的算力水平,现在一台NVL72就做到了,惊不惊喜。而且1.2PB的内存带宽相当于一整个互联网的带宽,你就说吓不吓人。

确实吓人,不过,我注意到,老黄说的1.4ExaFlops的算力,算力精度用FP4这个超低精度来计算的,要知道,现在的E级HPC超级计算机的单位是FP64双精度啊,老黄你有点不老实啊。

各位看官,不要真的以为一台GB200 NVL72就能顶E级超算了。

第三个有趣瞬间,DGX-1微缩成桌面级电脑。

2016年,老黄当着马斯克还有OpenAI主要创始人的面,把第一代DGX-1交付给了OpenAI,2022年,OpenAI成了带领全球走进生成式AI技术时代的领路人。

老黄直接表示,这样一台机架级别的服务器还是太大了,为了让AI研发者,数据科学家,学生和开发者都可以在桌子上摆放一台超级计算机,必须得把它的尺寸变小。

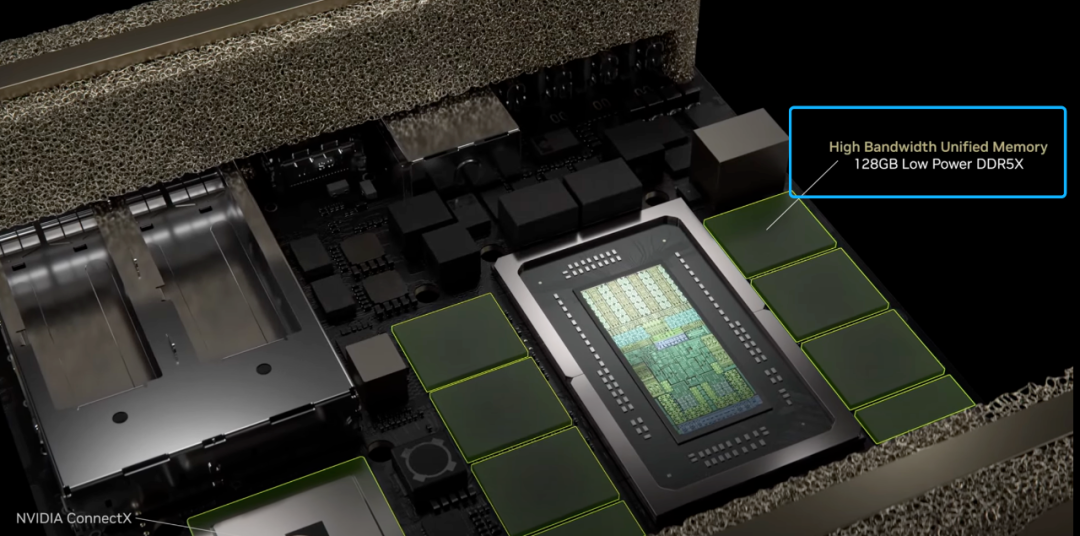

英伟达宣布启动名为DIGITS(Deep learning gpu intelligence training system)的项目,打造桌面级超级计算机,它将基于全新的GB10超级芯片打造,可提供1 Petaflop的AI 计算性能,可推理2000亿参数大模型。

它是做什么用的呢?开发者在本地用它完成模型原型开发后,可以把模型放到云或者其他数据中心进行训练,模型训练完成后可以放到本地进行微调或者推理。

由于本地和云上都采用了Grace Blackwell 架构和 NVIDIA AI Enterprise 软件平台,做到了软硬件的无缝衔接。

这应该是英伟达首次提到GB10超级芯片,它是基于Grace Blackwell架构打造的SoC,在 FP4 精度下可提供高达1 Petaflop 的 AI计算性能。GB10还集成了20核的Arm处理器,两者通过NVLink-C2C芯片互连技术相互连接。

每台设备可提供128GB的共享内存,不过,它既不是GDDR显存,也不是HBM,而是DDR5X内存,所以没法直接跟5090或者B200进行对比。不过,作为一款桌面级设备,功耗和散热并不高,也没法奢望能用上显存。

老黄表示,凭借128GB的共享内存,它可以运行最高2000亿参数的大型语言模型。配合英伟达的ConnectX网络技术,能把两台设备连在一起,这样就可以推理4050亿参数的AI模型。

只不过,它的推理性能会不如预想的那么好。

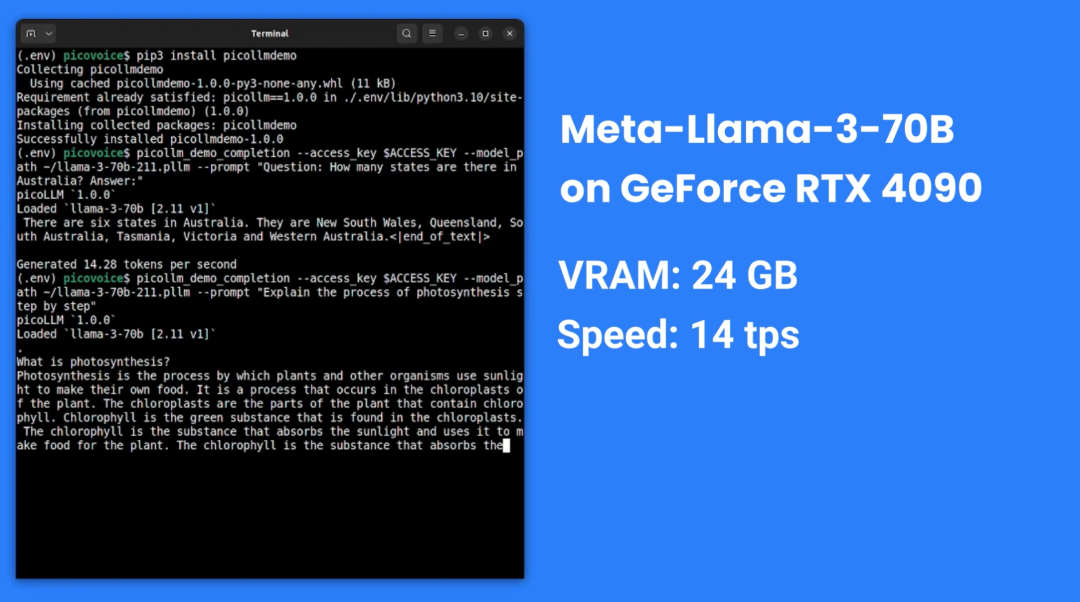

有人量化之后用单张24G显存的4090推理了70B的大模型,每秒14个Token。换成32G的5090理论上能更快,但应该还是不能推理2000亿参数的大模型。

所以,一些准备买5090运行本地大模型的用户,可能需要在两者之间权衡一下了。一台这样的桌面级设备建议零售价为3000美元,仅比单块RTX 5090的售价高了1000美元。

考虑到他能放在桌面上,也就降低了所有普通人在本地玩大语言模型的最低的门槛,还是挺有意思的。