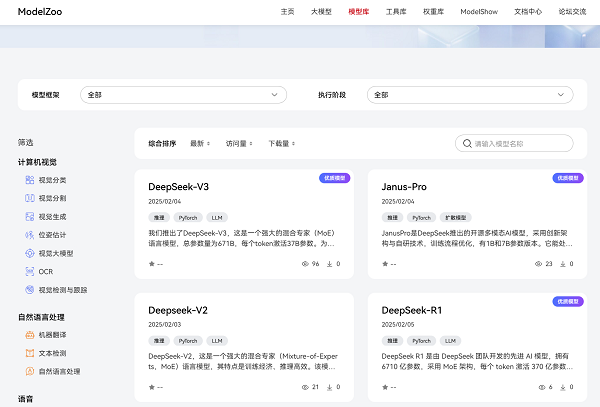

DeepSeek AI最新发布的多模态大模型Janus-Pro,以及之前发布的大型语言模型DeepSeek-R1、DeepSeek-V3及DeepSeek-V2,一经发布,就在AI领域引起了热烈反响,多项创新技术显著提升了模型的性能与效率。DeepSeek系列模型首发即支持昇腾平台,让用户能够在昇腾硬件和MindIE推理引擎上实现高效推理。

2025年2月4日,DeepSeek-R1、DeepSeek-V3、DeepSeek-V2、Janus-Pro正式上线昇腾社区,支持一键获取DeepSeek系列模型,支持昇腾硬件平台上开箱即用,推理快速部署,带来更快、更高效、更便捷的AI开发和应用体验,欢迎广大开发者体验使用。

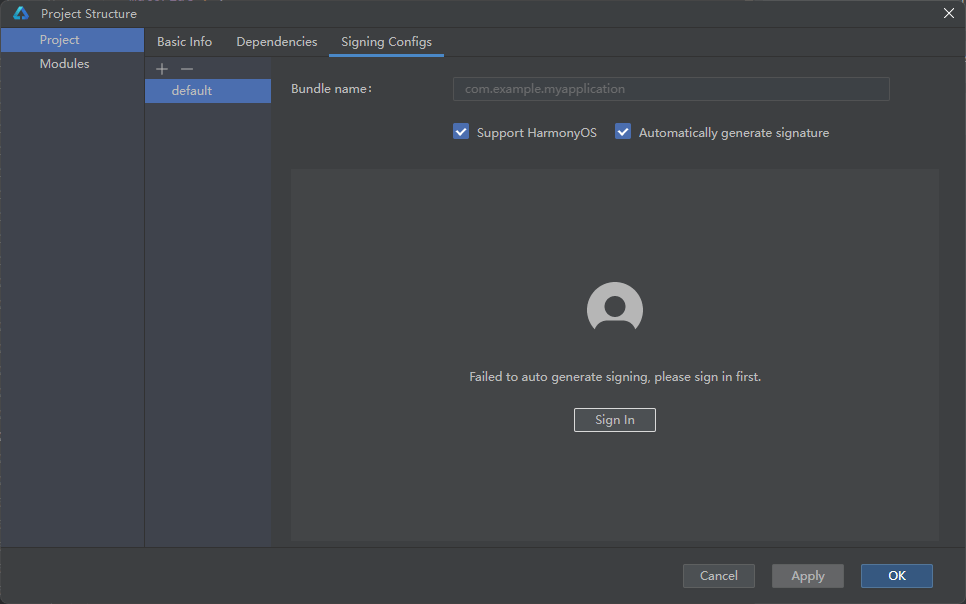

下面以Deepseek-V3为例,演示在昇腾社区如何高效获取模型及使用

硬件要求:

部署DeepSeek-V3模型需配置4台Atlas 800I A2(8*64G)服务器资源

模型调用实践:

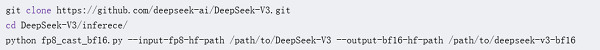

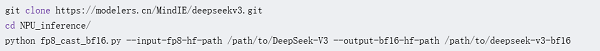

一、权重转换

GPU:

NPU:

二、加载镜像

在昇腾社区/开发资源下载适配DeepSeek-V3的镜像包:

mindie:1.0.T71-800I-A2-py311-ubuntu22.04-arm64

完成之后,请使用docker images命令确认查找具体镜像名称与标签。

三、容器启动

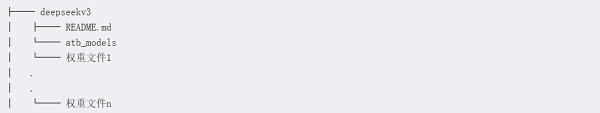

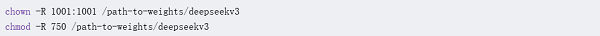

提供的MindIE镜像预置了DeepSeek-V3模型推理脚本,从您信任的来源自行获取权重后,放置在从上述下载的模型代码的主目录下,修改模型文件夹属组为1001,执行权限为750,启动容器。

四、服务化测试

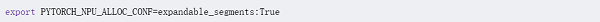

配置服务化环境变量,expandable_segments-使能内存池扩展段功能,即虚拟内存特性

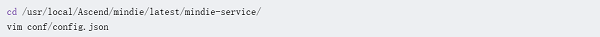

修改服务化参数

拉起服务化

出现“Daemon start success!”,则认为服务成功启动。