近一段时间,生成式 AI 技术经历了飞速的进步,尤其是在强推理模型(Reasoning-LLM)的推动下,AI 从大模型训练到推理应用的范式发生了剧变。以 DeepSeek 等前沿 AI 模型为例,如今的 AI 技术发展已不局限于依赖海量数据训练的单一大模型,而更加注重模型在推理阶段的高效性以及小型专精模型间的协同作用。

本文将带您回顾这一技术演变,探讨强推理 AI 模型如何重构数据生命周期的管理,以及在训练和推理各阶段如何优化存储架构。结合大规模语言模型(LLM)训练的宝贵经验,我们一同展望未来存储技术的演进方向。

AI 范式的变化

深度推理模型重塑 AI 开发逻辑

传统大模型通常依赖端到端的大规模自监督预训练(SSPT),而强推理 AI 模型(如 DeepSeek-R1)则在训练流程中融入了全新策略。具体而言,DeepSeek-R1 利用大规模强化学习参与训练,使模型在多步推理过程中自动生成中间逻辑,并通过多阶段训练及预热数据的辅助,显著提高了结果的可读性与稳定性。这一改变意味着 AI 开发不再仅仅追求“让模型记住答案”,而是教会模型“如何思考”。

传统生成式 AI vs 强推理 AI 的核心变化

从数据、计算和架构三个维度来看,新旧范式迥然不同:

数据维度:传统大模型倾向于“多多益善”,用海量通用数据训练一个大一统模型;强推理模型则更强调高质量、针对性的训练数据,包括逻辑推理、数学和代码等专项数据集,以及交互式的数据来培养推理能力。数据质量的重要性空前提高,甚至催生“数据驱动的算法设计”理念。模型需要从更精炼的数据中学习复杂推理,而不仅是从冗余数据中学习表面模式。

计算维度:以往提升 AI 性能主要依赖于扩大模型参数和算力投入,典型做法是堆叠更深更大的网络来提升表现。而强推理 AI 更注重计算模式的革新:通过多步推理、模块协作来弥补单纯扩展规模的边际效用下降。例如,与其将预算都花在训练一个巨型模型,不如让模型调用自身多次、结合搜索或外部工具来完成任务。这一转变意味着计算资源的利用更加高效,“巧用计算”取代“一味堆计算”,通过优化推理过程来提升效果。

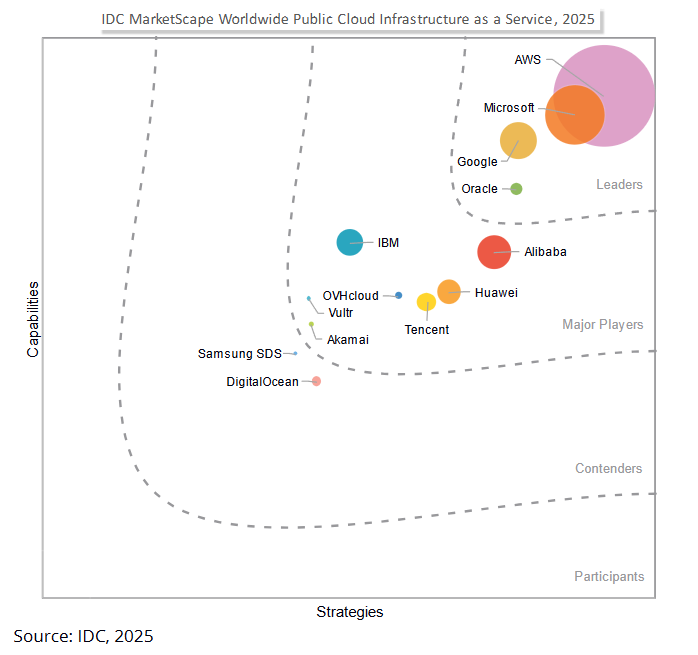

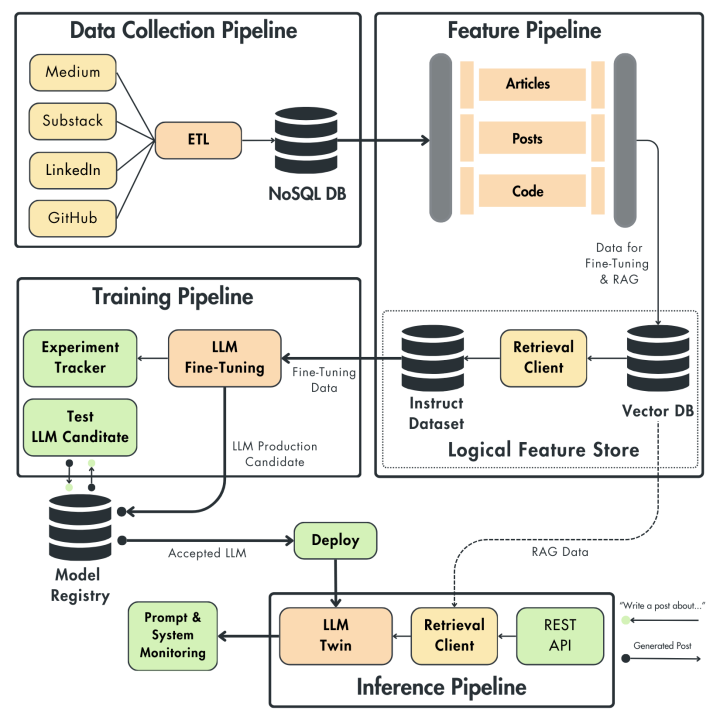

架构维度:传统 AI 架构多为单体模型(monolithic)一次性完成任务,而强推理范式倾向于多组件复合系统。越来越多最先进 AI 成果来自由多个模型或模块组成的系统,而非单一模型。例如,将一个 LLM 与 RAG 等结合,或者采用 Mixture-of-Experts(MoE)架构,将不同专长的小模型组合,以协作完成复杂任务。这种模块化、工具化的架构能针对不同子问题调用最合适的模型,大幅提升整体效果。研究显示,在企业应用中有 60%的 LLM 场景引入了检索增强生成(RAG)来实时获取外部知识,30%使用了多步骤链式推理(CoT)—— 都反映出复合 AI 系统正取代“一模到底”的传统架构。

从大一统模型到小型专精模型体系

随着对成本和效率的考虑,业界开始由追求一个包打天下的通用大模型,转向构建一系列小而专精的模型。大型单体模型不仅训练维护代价高昂,而且在特定领域未必表现最佳。如今,小型化、开源化、专业化的模型成为趋势:通过开源社区共同创新,企业可以使用经过微调的领域模型来获得更高的准确度。例如,DeepSeek 团队开源了基于 R1 大模型蒸馏出的多个小模型(1.5B~70B 参数)供不同需求使用。这一策略不仅降低了部署成本,也使模型体系更具弹性——可以按需组合更新,替代过去那种笨重且难以适应新需求的单一巨模型架构。可以预见,“模型组合拳”将是未来 AI 系统的常态,开发者更关注如何 orchestrate 多模型协同,而非只依赖单个模型的万能性。

强推理 AI 如何影响训练与推理的数据管理

训练过程的智能迭代

传统大模型训练往往采用单阶段的大规模预训练,即一次性将海量语料喂给模型训练,数据准备往往是离线完成。训练时只需顺序或随机读取一个已经准备好的静态数据集,存储系统的主要压力点在读放吞吐量上,对写入实时性要求较低。

而具有强推理能力的模型引入了多阶段训练流程。例如 DeepSeek-R1 的训练被分为两个阶段:

- 第一阶段基于已有基础模型生成“深度推理数据”,也就是让模型自身产出推理过程的中间步骤数据;

- 第二阶段再将这些模型推理产生的数据与常规的有监督微调数据结合,对模型进行微调并配以强化学习,最终得到擅长逻辑推理的模型。

这种训练范式意味着数据不再全是人类标注或静态抓取而来,其中一部分是模型自生成的数据。因此,数据管理需要支持模型在训练过程中动态地产生新数据并纳入训练集。例如 DeepSeek 在第一阶段产出的“大量推理过程数据”需要及时存储、校验,并供后续训练高效读取。这对存储系统的吞吐和延迟提出新要求:既要能快速写入模型推理日志数据,又要能高效读取这些数据进行二次训练。

推理阶段的数据交互

在推理阶段,强推理 AI 模型常常需要处理更复杂的数据交互与多步中间计算。以 DeepSeek 的 MLA(Multi-Level Aggregator)架构为例,其内置的多层 KV Cache 机制允许模型针对不同粒度和阶段的历史信息进行存储与调用,从而实现更灵活的链式推理(CoT)。这一机制显著区别于传统模型一次性输入所有上下文、直接输出答案的方式:

频繁的历史信息引用:MLA 架构会在推理过程中多次读取先前生成的中间表征(如上一阶段或上一个层级的 Key-Value),甚至可能需要回溯早前的推理步骤。传统单层缓存或简单输入-输出模式难以满足这样的反复调用,而多层 KV Cache 能够极大地减少访问延迟和重复计算。

多层存储更近计算单元:为了有效支持这类高频读写和回溯操作,MLA 通常在计算节点附近缓存关键的中间状态(如隐层表示、Key-Value 矩阵等)。相较“计算与存储完全分离”的传统架构,这种将存储部分下沉至计算节点的设计,可显著降低反查历史步骤的延迟,提升推理效率。

MLA 的多层 KV Cache 机制不仅支撑了强推理 AI 对历史上下文与中间结果的反复引用,也带来了对 AI 基础设施的新要求:需要兼顾高并发、低延迟的数据读写模式,能够在推理过程中灵活地管理、缓存与交换信息,从而使得复杂、多步的推理在实际应用中更高效、更可控。

AI 基础设施如何适应更智能的数据流动模式

面对强推理 AI 带来的变革,AI 基础设施必须迅速演进,以支撑更智能且复杂的数据流动。

引入新的存储系统组件

为了满足现代大模型与 AI Agent 对实时数据交互、状态缓存及跨模块协同的需求,必须构建并引入具备高性能、低延迟和弹性扩展能力的新一代存储组件。这些组件不仅包括云原生分布式对象存储、内存级高速缓存和分层存储系统,还需支持与外部向量数据库、检索系统以及 AI Agent 之间的无缝数据交换,从而实现‘存算一体’的智能数据流管理。

计算存储协同设计

正如前文所述的“计算与存储更近”趋势,为支持长链式推理模型,硬件与系统层面纷纷探索计算与存储深度协同的方案。

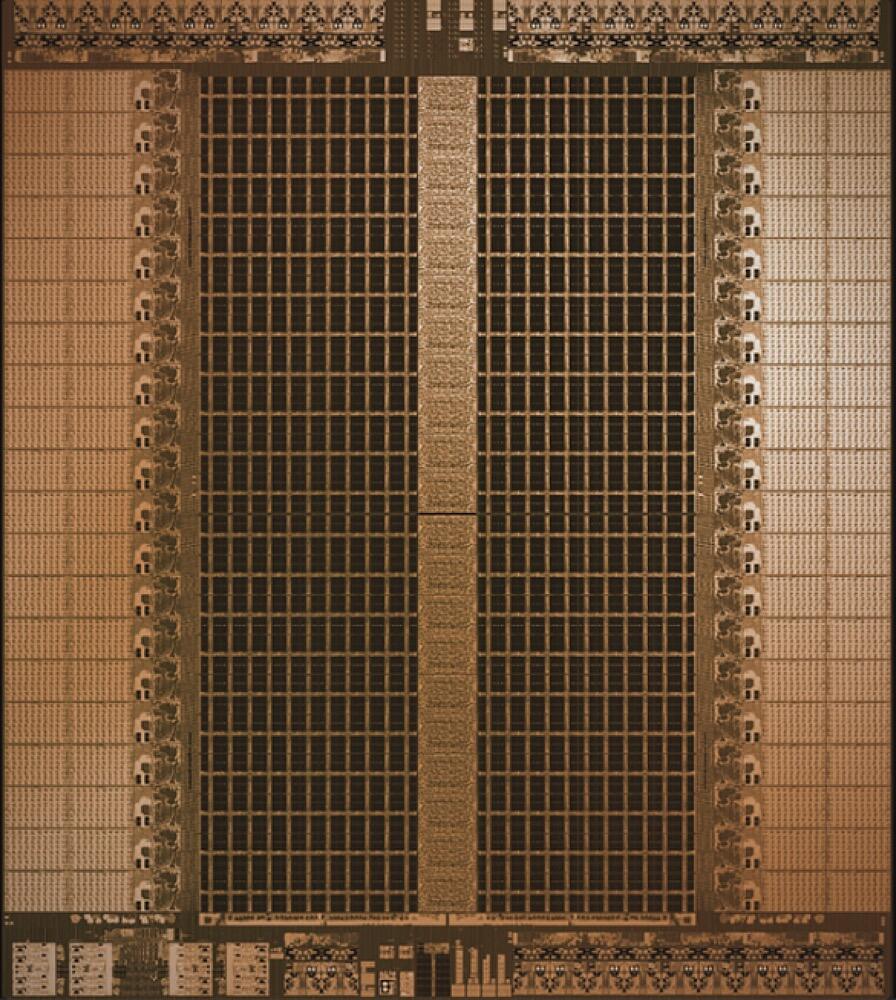

在硬件层面,不少芯片厂商已采用片上大容量高速内存(例如 SRAM)取代传统 GPU 外部显存,使计算单元能够直接访问更大范围的数据上下文,从而实现推理速度的数量级提升;

在系统架构方面,部分方案甚至将存储节点部署于计算集群内部,或令每个 GPU 节点承担部分存储职责,从而模糊了计算与存储节点的边界,并通过高速互连实现数据在计算单元间的直接共享,大幅减少远程存储访问延迟。

对于需要频繁调用历史步骤或共享中间结果的推理任务,这种计算存储协同设计显著降低了整体延迟。

数据流水线的弹性智能调度

AI 基础设施还必须具备更加智能化的数据流管理能力。例如,在模型训练过程中,可通过调度系统根据实际需求动态调整数据加载顺序与节奏,从而确保计算资源的高效利用而不因数据延迟而受阻。在强推理场景下,系统可实时监控推理过程,并提前将可能需要的历史信息或知识库内容预取至本地缓存,为后续操作铺设数据通道。同时,依据推理逻辑的动态演进,实时调整数据供应策略。这种弹性调度的数据流水线管理能力,将成为未来 AI 基础设施的重要标志,使其能够灵活适应各类模型和任务的多样化数据访问需求。换句话说,存储系统将从被动的数据提供者转变为根据 AI 模型“意图”主动优化数据分发的智能组件。

值得注意的是,DeepSeek-R1 的成功也提醒我们:未来 AI 发展未必完全依赖数据规模的粗放增长,更取决于算法和系统效率的提升。在存储层面,这意味着与其简单扩大存储容量,不如优化数据利用效率、加速数据流通。通过更智能的存储架构,我们有望以更小的数据规模实现更强的模型能力,从而走出“规模至上”的路径依赖。

存储架构的演进方向

为了满足新一代 AI 训练与推理对高性能、可扩展性及智能化的需求,存储架构正迎来全方位的升级改造。下面总结了几个关键方向及其最佳实践:

- 分布式对象存储

首先,应优先部署云原生分布式对象存储作为数据湖的核心。例如,采用基于 S3 协议的存储集群不仅可以灵活扩展,还能提供高吞吐能力,目前已有众多 AI 团队利用该方案支持大模型全流程训练。对于需要 POSIX 接口的训练框架,可在对象存储之上构建一个文件系统层,以兼顾扩展性与现有接口兼容性,但同时应注意避免引入不必要的复杂度,确保整体系统简洁而稳定。

- 全闪存加速与分级存储

为训练集群配置全闪存存储(例如采用 NVMe over Fabric 架构)可以充分释放 GPU 计算能力,因为全闪存存储凭借高 IOPS 和低延迟,既能应对训练过程中随机抽取小批数据的需求,也能保障推理时多个模型并发加载时的响应速度。同时,构建分级存储架构同样是一项最佳实践:将最“热”的数据(如当前训练批次和最新检查点)存放于最快的存储层(例如 GPU 本地 HBM/DDR 构建的内存缓存池),将次热数据置于专属分布式 NVMe 池,而较冷的数据则存于容量型存储(如 HDD 池或对象存储)。这种梯度存储设计有效平衡了性能与成本,为不同数据“温度”提供了最合适的存储方案。

- 智能预取与缓存

为了降低存储延迟并提升整体效率,充分利用缓存技术至关重要。在训练阶段,可通过节点本地的 NVMe SSD 构建用于近期读取数据块的缓存,从而使后续的 epoch 能直接命中缓存,避免重复加载。在推理阶段,则建议部署内存或高速 SSD 缓存,专门用于存储热门问答、对话上下文及常用知识库文档。与此同时,借助智能预取机制,系统能够依据训练计划或推理请求模式提前将必要数据加载入缓存——例如,提前预取下一数据分片或相关知识向量。这样的智能缓存策略需依托于 AI 模型的访问模式分析,实现缓存命中率的最优化,并通过软硬件协同调优,使存储系统从被动响应转变为主动满足 AI 需求。

- 可靠性与多云容灾

最后,尽管性能至关重要,但存储系统的可靠性同样不可忽视。由于大模型训练通常周期长、投入巨大,存储解决方案必须考虑故障恢复和数据冗余。最佳实践包括在跨机架或数据中心层面实现冗余存储检查点,利用纠删码技术确保语料数据的安全,以及在多云环境中部署同步存储服务,防止单一云服务故障。这些措施有效保障了在硬件故障或区域中断时,训练任务能够迅速切换数据源,避免前期工作化为泡影。

当前,AI 训练与存储架构正从传统 HPC 模式向 AI 原生架构深度转型。对最新 LLM 存储挑战的分析表明,传统并行文件系统在许多应用场景中已显不足,正在被更灵活高效的对象存储解决方案所替代,同时辅以文件系统 Posix 接口来优化数据管理。随着强推理 AI 模型的不断涌现,未来 AI 工作负载将呈现出更加动态、智能化的数据流,这就要求存储系统更紧密地贴合计算需求,并具备智能调度数据的能力。

数据常青(Make Data Alive)— 请联系 XSKY星辰天合来一起解锁数据的无限价值,让您的数据驱动创新。