最近,KTransformers项目团队宣布,支持让满血版DeepSeek在英伟达RTX 4090D显卡上运行。RTX 4090D是一个游戏显卡,目前电商零售价大概在3万人民币左右,它能以极低的成本在本地运行满血版的DeepSeek-R1模型。

KTransformers是一个可以利用CPU+GPU进行混合推理的项目,将部分计算卸载到CPU内存,从而减少昂贵显存的占用。它支持多种硬件和多种常见的大语言模型,可以降低大语言模型的部署门槛和成本。

类似的,llama.cpp也支持CPU+GPU混合推理,当模型超过显存容量时,可以同时利用CPU和GPU来加速。

KTransformers是由清华大学的KVCache.AI团队和趋境科技合作开发的项目。KVCache.AI是一个通过优化缓存、调度、压缩等技术,提升大语言模型效率的项目,并且和趋境科技以及月之暗面公司合作开发而来,目标是推动学术研究和开源开发。

趋境科技Approaching.AI官网上写道,他们在业界首创“以存换算”全系统推理架构,可以协同HBM、DRAM、SSD和CPU、GPU、NPU全系统异构设备,突破显存容量的限制,释放全系统的存力和算力。

“突破显存容量的限制”是重点。我们知道,原本大语言模型大多都运行在英伟达的高性能企业级显卡上,显卡的计算核心决定了运算的效率和速度,而显存的容量直接决定着显卡能否运行多大参数规模的大语言模型。

然而,显存非常昂贵,高端的A100、H100可以提供80G的HBM显存,但几十万一块的成本太高了。而消费级的RTX 3090可以提供24G GDDR显存,RTX 4090D也能提供24G显存,是运行大语言模型的最有性价比的选择。

如果只能利用显存来运行大语言模型,那么单块4090显卡根本无法运行6710亿参数的DeepSeek-R1。但如果能更充分地利用DRAM、甚至SSD的存储空间,同时更多地利用CPU以及NPU的算力,则无疑是降低了模型的运行门槛。

2024年8月,KTransformers团队宣布使用21GB显存和136GB内存配置的电脑来推理236B DeepSeek-Coder-V2 模型。并且,在BigCodeBench测试中,它的表现甚至优于 GPT4-0613 模型。

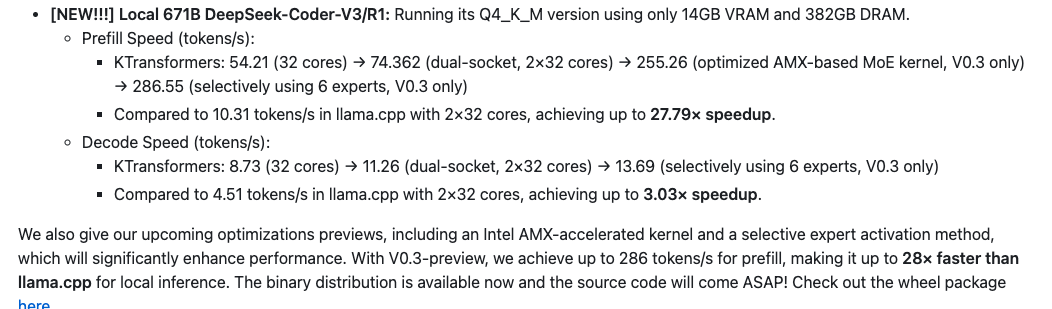

2025年2月10日,KTransformers宣布V0.3预览版可以用单个或者多个带有24GB显存的显卡,以及382GB DRAM的设备来推理满血版的Deepseek-R1和V3。在这种配置下,性能提升可达到llama.cpp的3~28倍。

V0.3预览版支持Intel AMX加速内核和专家选择性激活方法,当然还有FP4量化技术,14GB显存和382GB DRAM的配置下,671B满血版DeepSeek-Coder-V3/R1的预填充速度(开始输出前)提升27.79倍,输出文本速度实现了最多3.03倍的加速。

该项目认为,目前该项目主要瓶颈仍是CPU的计算速度和内存带宽,GPU对性能提升的贡献相对较小。换言之,如果升级CPU和内存,比如把它升级到英特尔至强6 6900P系列是完全有可能实现性能提升的。

我注意到,测试用的是2年前的第四代至强金牌6454S,现在已经是至强6了。它的内存是DDR5 4800,现在至强6支持6400,它支持的MRDIMM技术能拉到8800。此外,内存通道也从8个变成了12个。跟2年前相比,内存能力提升巨大。

当然,KTransformers也可以考虑升级到最新的英伟达RTX 5090D,它可以提供32GB的GDDR7显存,比4090多了8G的显存。不过,由于目前5090才刚发布不久,存在供货不足的问题,搭建起来也比较麻烦。

不过,我个人倒是非常期待它多卡推理的表现,比如,用多块只有8G、12G或者16G显存的显卡做推理,这些显卡的单价更低,可能会构建比使用单个4090或者5090更低的方案。