“双模型”聚合效应,让腾讯元宝更好用了。

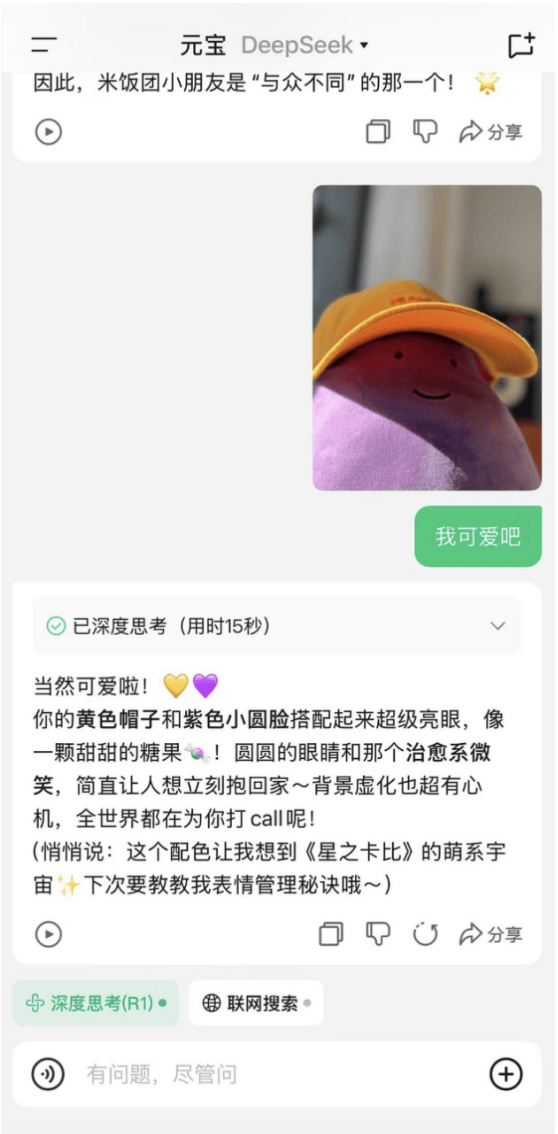

2月21日,腾讯AI助手“腾讯元宝”上新,现在腾讯元宝的DeepSeek能够理解图片信息。

此前,DeepSeek主要支持扫描图片中的文字。今后,在腾讯元宝,关闭联网搜索后,用户发送任意图片,元宝都能结合图片内容给出自己的分析和理解。

据了解,这项功能结合了混元的多模态理解能力,也是元宝双模型特征的体现。

在腾讯元宝,用户可以使用DeepSeek-R1满血版、推理模型混元T1进行深度思考,也可通过DeepSeek-V3、腾讯混元Turbo快速输出答案。

目前,元宝内的所有模型,都已支持理解图片、解析文件、联网搜公众号、从微信上传文件。

过去一周,腾讯元宝迎来一系列快速迭代和功能更新。

2月13日,腾讯元宝接入Deepseek-R1满血版,同时支持混元和DeepSeek两大模型;

2月17日,腾讯自研的深度思考模型“混元T1”在元宝灰度上线;

2月18日,腾讯紧急调用元宝支持微信搜索,进一步推动更多用户使用DeepSeek;

2月19日,深度思考模型“混元T1”完成全量上线;

2月21日,腾讯元宝再次上新,DeepSeek和混元两大模型均能理解图片信息。

腾讯方面表示,未来将持续优化产品能力,提升模型性能,为用户提供更优质的AI使用体验。