导读

2025年4月6日凌晨,Meta以“周末突袭”的方式开源Llama 4系列模型,标志着AI开源生态进入“超参数密度”与“多模态协同”的新阶段。此次发布的三个版本——Scout(轻量级)、Maverick(旗舰级)和Behemoth(超大规模)——不仅首次全面采用混合专家(MoE)架构,更以1000万token上下文窗口刷新行业纪录,直接对标DeepSeek、GPT-4o等顶尖闭源模型。

文字编辑| 宋雨涵

1

Llama 4的核心亮点

MoE架构的工程化突破

该系列包括Llama 4 Scout、Llama 4 Maverick和Llama 4 Behemoth。所有这些模型都经过了大量未标注的文本、图像和视频数据的训练,以使它们具备广泛的视觉理解能力。

• Llama 4 Scout:17B激活参数,16个专家,是同尺寸中最强的多模态模型。支持10M超长上下文窗口,单张NVIDIA H100即可运行,适合轻量级部署。

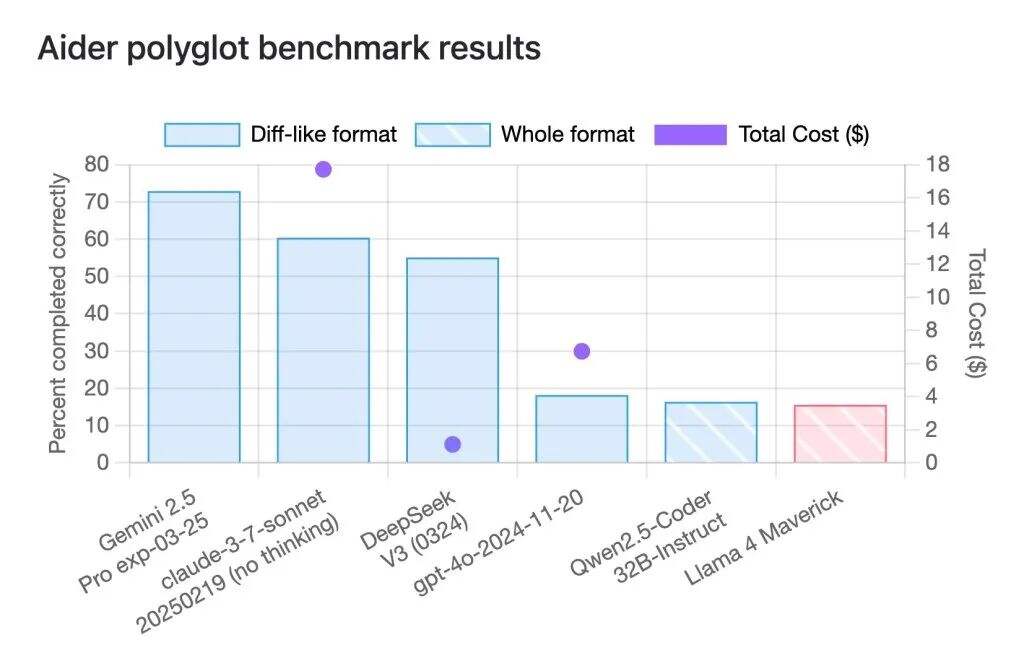

• Llama 4 Maverick:同样是17B激活参数,但拥有128个专家,总参数达400B,超越GPT-4o和Gemini 2.0 Flash,在代码、推理、多语言和图像理解方面全面领先。

• Llama 4 Behemoth(预览中):拥有288B激活参数、2万亿总参数,是目前Meta最强大的“教师模型”。它在STEM、图像、多语言任务上全面超越GPT-4.5、Claude 3.7和Gemini 2.0 Pro。

多模态与长上下文的协同革命:

多模态融合架构

采用早期融合策略,实现文本、图像、视频Token的统一处理,在Chart QA等跨模态任务中达90%+ 准确率。

无限上下文技术

通过iRoPE架构实现1000 万 + Token长距离推理,结合局部 / 全局注意力分层设计,在保持并行效率的同时突破位置编码限制。

训练流程优化

创新采用 “轻量级SFT→在线RL→轻量级DPO” 后训练方案,通过动态样本筛选机制提升模型泛化能力,Behemoth训练中过滤95%低质数据。

智能调参系统

MetaP技术基于贝叶斯优化框架,实现超参数动态优化,较传统方法提升训练效率30%。

开源竞赛背后的算力民主化悖论

Llama 4的发布揭示AI竞赛的两大矛盾:

技术普惠性与硬件门槛的撕裂

尽管Scout模型支持消费级GPU部署,但Behemoth所需的32000块H100集群(单次训练成本超2亿美元)将中小机构拒之门外。

开源理想与商业现实的博弈

Meta通过“开源模型+云服务收费”模式,既吸引开发者生态又掌控商业化入口,与DeepSeek“全栈开源”形成战略对冲。

编者洞察:

“Llama 4的MoE架构革新虽亮眼,但其真正的颠覆性在于重构了开源模型的‘成本-性能’曲线。当170亿参数模型能在单卡运行且效果媲美闭源巨头时,企业级AI落地的最后一公里已被打通。然而,中文生态的薄弱与超大规模模型的‘精英化’倾向,仍为DeepSeek等本土玩家留下反超空间。”

3

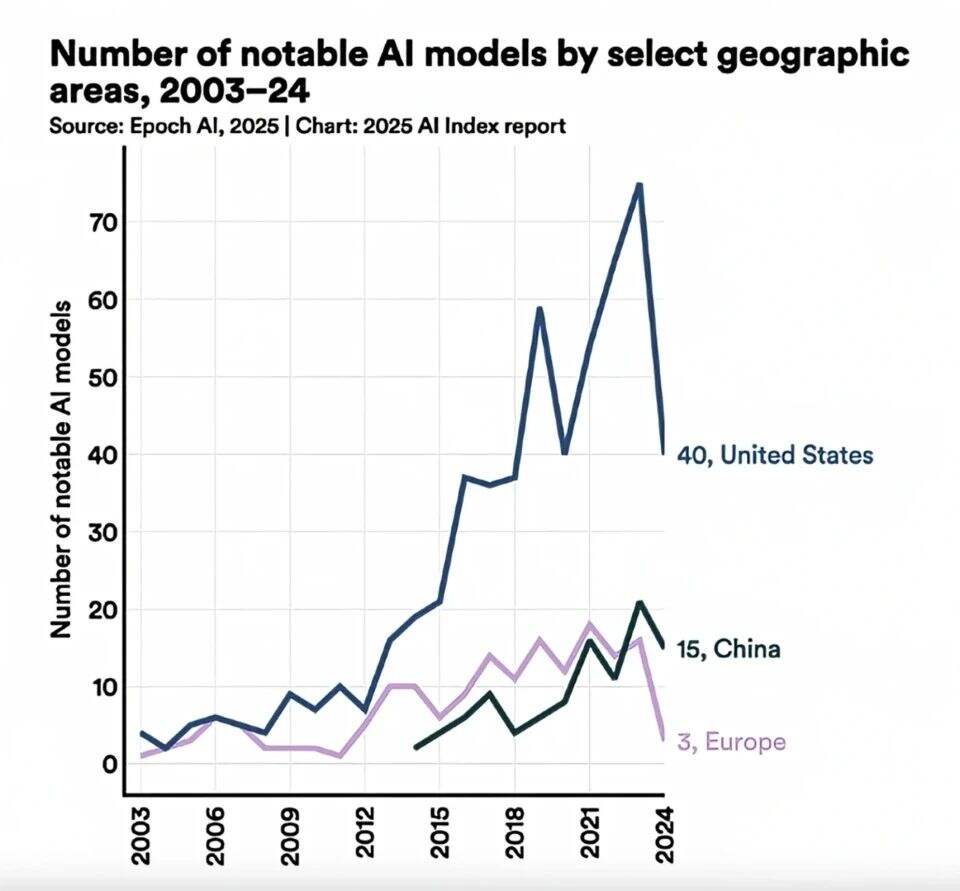

开源生态的“三足鼎立”格局

Meta-DeepSeek-谷歌

| 维度 | Llama 4 Maverick | DeepSeek V3 | Gemini 2.5 Pro |

| 架构 | 128专家MoE | 256专家MoE | 密集模型+路径稀疏化 |

| 上下文窗口 | 1M token | 256K token | 2M token |

| 多模态能力 | 原生图像/视频融合 | 文本优先,需外挂视觉模块 | 多模态联合训练 |

| 推理成本 | $0.17/百万token | $0.19/百万token | $4.38/百万token |

| 中文场景适配 | 训练数据占比不足5% | 中文任务得分超GPT-4o | 依赖翻译接口 |

核心差异点:

效率与成本的平衡:Llama 4的MoE架构在激活参数量相同情况下,推理速度较DeepSeek提升30%,但后者在数学推理(MATH-500准确率90.2%)和代码生成(HumanEval-MUL 82.6%)仍具优势。

生态策略分化:Meta采用“有限开源+商业条款”模式(需标注“Powered by Llama”),而DeepSeek彻底开放训练框架与数据处理方法,吸引更多开发者贡献。

结语

Llama 4的深夜突袭,不仅是Meta的技术宣言,更是全球AI权力重构的序幕。在这场算力、数据与生态的立体战争中,开放与封闭的边界正被重新定义——而最终的赢家,或许是那些既能驾驭技术浪潮,又不失商业洞察的“平衡术大师”。