优刻得云平台已全面接入智谱GLM-Z1系列推理模型,为客户提供更高效、更智能、更低成本的智能解决方案。

国产AI大模型独角兽智谱于4月15日正式开源了 32B/9B 系列 GLM 模型,涵盖基座、推理、沉思模型,均遵循 MIT 许可协议。目前系列所有模型可以通过 “z.ai”访问体验。新版基座模型和推理模型已同步上线智谱 MaaS 平台。优刻得云平台现已同步支持该开源模型镜像(体验地址🔗:https://console.ucloud.cn/uhost/uhost/gpu_create)。

GLM-Z1-32B-0414 是具有深度思考能力的推理模型,这是在智谱最新32B基座模型的基础上,通过冷启动和扩展强化学习,以及在数学、代码和逻辑等任务上对模型的进一步训练得到的。相对于基础模型,显著提升了数理能力和解决复杂任务的能力。在训练的过程中,智谱还引入了基于对战排序反馈的通用强化学习,进一步增强了模型的通用能力。

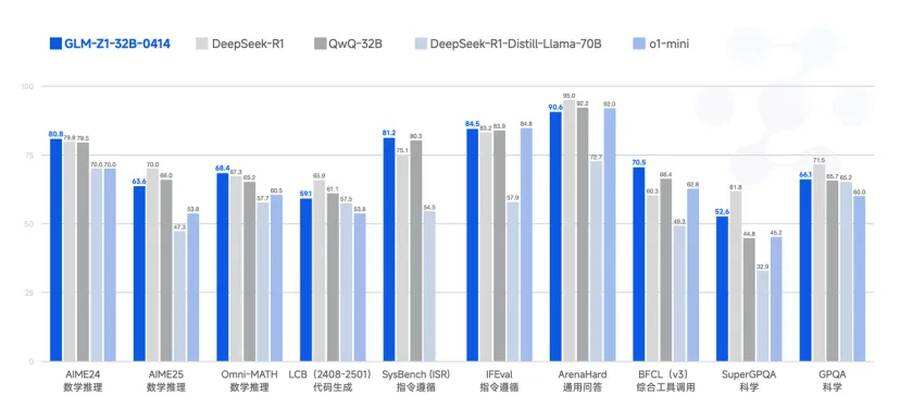

在部分任务的性能表现上,在仅使用 32B 参数的情况下,可与参数高达 6710 亿的 DeepSeek-R1 相媲美。在AIME 24/25、LiveCodeBench、GPQA 等基准测试中,GLM-Z1-32B-0414 展现了较为强大的数理推理能力、指令遵循能力和综合工具调用能力,为更多复杂任务的解决提供了支持。

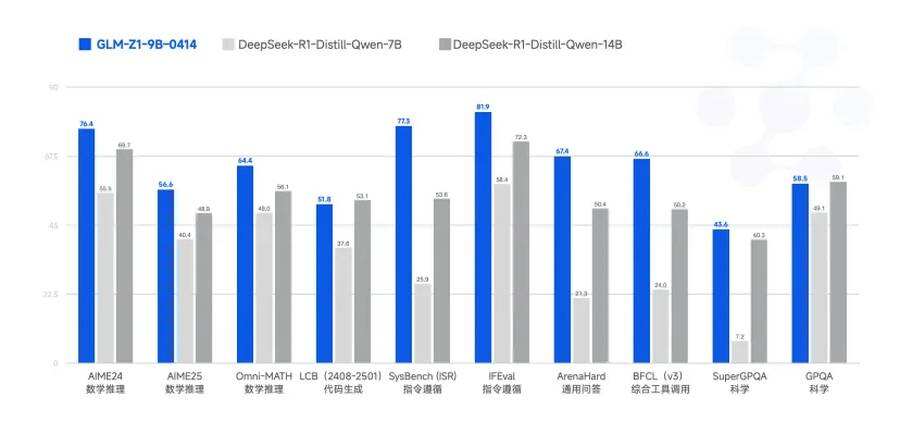

GLM-Z1-9B-0414 是一个惊喜。智谱沿用了上述一系列技术,训练了一个 9B 的小尺寸模型。虽然参数量更少,但是在数学推理及通用任务上依然表现出色,整体性能已跻身同尺寸开源模型的领先水平。特别是在资源受限的场景下,该模型可以很好地在效率与效果之间取得平衡,为需要轻量化部署的用户提供强有力的选择。

此前,优刻得就凭借自身在云计算领域的深厚积淀,为智谱 AI 提供底层算力支持,可靠支撑大模型应用智谱清言、AI智能体AutoGLM等多款AIGC项目的快速上线和对外服务。合作中,优刻得乌兰察布智算中心的定制化高电机柜和 GPU 算力,帮助智谱大模型迅速搭建起训练和推理集群,并不断扩大规模,极大地提升了智谱大模型的研发效率,使得大模型应用能够快速上线并对外服务,为智谱 AI 后续的模型研发筑牢根基。

优刻得模型服务平台融合丰富的行业模型资源,可针对不同行业需求定制,提供精准高效推理能力。合作期间,双方还以 “大模型一体机” 为载体,联合探索行业大模型解决方案,助力金融、医疗、汽车、制造等行业快速落地大模型业务。

此次首批接入在推理能力、端侧算力、运行成本等方面具有独特优势的智谱GLM Z1系列推理模型,标志着优刻得与智谱在智能算力基础设施领域的进一步深化合作。通过将 GLM-Z1-32B 深度思考能力与优刻得智算集群能力相结合,助力客户获取极致推理体验。

优刻得深耕 AI 领域多年,构建了覆盖AI训练、推理、应用落地的全栈服务体系,至今已为超千款 AI 应用提供智能算力服务,支持超大规模分布式训练、多模态模型加速及云边端协同部署,并以异构算力调度引擎实现 GPU 资源利用率的大幅提升。

优刻得将持续以”技术普惠”为核心理念,通过构建开放兼容的智能算力平台,携手更多像智谱这样的国内顶尖 AI 企业,共同推动中国大模型技术应用创新,为数字经济高质量发展注入新动能。